英伟达发布AI芯片H200:性能飙升90%,Llama 2推理速度翻倍

DoNews11月14日消息,英伟达北京时间13日发布了下一代人工智能超级计算机芯片,这些芯片将在深度学习和大型语言模型(LLM)方面发挥重要作用,比如 OpenAI 的 GPT-4。

新一代芯片相较于上一代有了显着的进步,将被广泛应用于数据中心和超级计算机,用于处理天气和气候预测、药物研发、量子计算等复杂任务

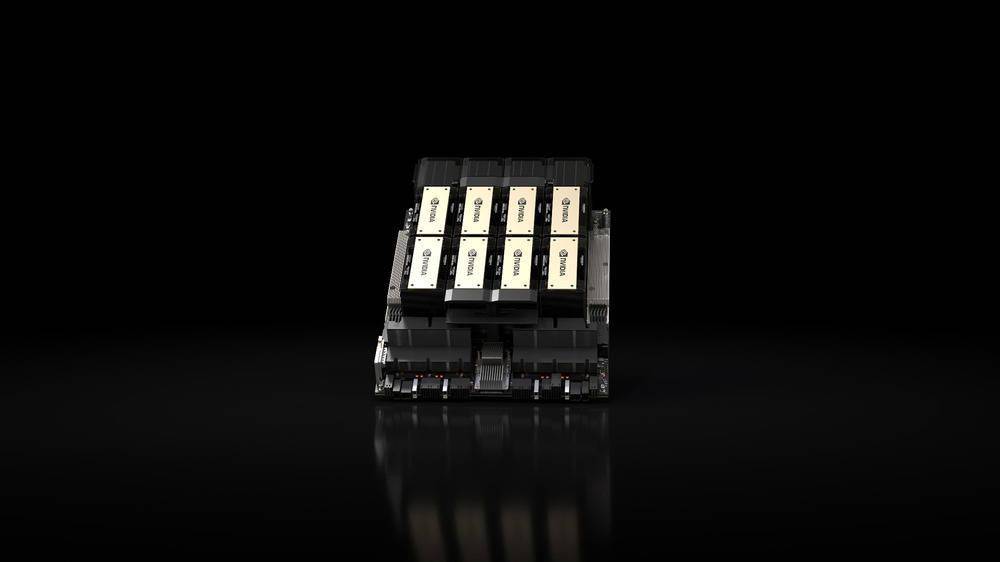

发布的关键产品是基于英伟达的“Hopper”架构的HGX H200 GPU,它是H100 GPU的继任者,并且是该公司首款采用HBM3e内存的芯片。 HBM3e内存具有更快的速度和更大的容量,因此非常适合大型语言模型的应用

英伟达表示:“借助HBM3e技术,英伟达H200内存速度达到每秒4.8TB,容量为141GB,几乎是A100的两倍,带宽也增加了2.4倍。”

在人工智能领域,英伟达宣称HGX H200在Llama 2(700亿参数LLM)上的推理速度比H100快了一倍。 HGX H200将提供4路和8路的配置,与H100系统中的软件和硬件兼容

它将适用于每一种类型的数据中心(本地、云、混合云和边缘),并由 Amazon Web Services、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 等部署,将于 2024 年第二季度推出。

英伟达此次发布的另一个关键产品是GH200 Grace Hopper“超级芯片(superchip)”,其将HGX H200 GPU 和基于Arm 的英伟达Grace CPU 通过该公司的NVLink-C2C 互连结合起来,官方称其专为超级计算机设计,让“科学家和研究人员能够通过加速运行TB 级数据的复杂AI 和HPC 应用程序,来解决世界上最具挑战性的问题”。

GH200 将被用于“全球研究中心、系统制造商和云提供商的 40 多台 AI 超级计算机”,其中包括戴尔、Eviden、惠普企业(HPE)、联想、QCT 和 Supermicro。

值得注意的是,HPE 的 Cray EX2500 超级计算机将采用四路 GH200,可扩展到数万个 Grace Hopper 超级芯片节点

以上是英伟达发布AI芯片H200:性能飙升90%,Llama 2推理速度翻倍的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

Vibe编码通过让我们使用自然语言而不是无尽的代码行创建应用程序来重塑软件开发的世界。受Andrej Karpathy等有远见的人的启发,这种创新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月,Generative AI又是一个改变游戏规则的月份,为我们带来了一些最令人期待的模型升级和开创性的新功能。从Xai的Grok 3和Anthropic的Claude 3.7十四行诗到Openai的G

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

Yolo(您只看一次)一直是领先的实时对象检测框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了进步,可显着提高准确性

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4当前可用并广泛使用,与诸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和产生连贯的响应方面取得了重大改进。未来的发展可能包括更多个性化的间

Google的Gencast:Gencast Mini Demo的天气预报

Mar 16, 2025 pm 01:46 PM

Google的Gencast:Gencast Mini Demo的天气预报

Mar 16, 2025 pm 01:46 PM

Google DeepMind的Gencast:天气预报的革命性AI 天气预报经历了巨大的转变,从基本观察到复杂的AI驱动预测。 Google DeepMind的Gencast,开创性

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

本文回顾了AI最高的艺术生成器,讨论了他们的功能,对创意项目的适用性和价值。它重点介绍了Midjourney是专业人士的最佳价值,并建议使用Dall-E 2进行高质量的可定制艺术。

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

本文讨论了AI模型超过Chatgpt,例如Lamda,Llama和Grok,突出了它们在准确性,理解和行业影响方面的优势。(159个字符)

O1 vs GPT-4O:OpenAI的新型号比GPT-4O好吗?

Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O:OpenAI的新型号比GPT-4O好吗?

Mar 16, 2025 am 11:47 AM

Openai的O1:为期12天的礼物狂欢始于他们迄今为止最强大的模型 12月的到来带来了全球放缓,世界某些地区的雪花放缓,但Openai才刚刚开始。 山姆·奥特曼(Sam Altman)和他的团队正在推出12天的礼物前