11 月 16 日消息,微软 Ignite 2023 大会已于今天拉开帷幕,英伟达高管出席本次大会并宣布更新 TensorRT-LLM,添加了对 OpenAI Chat API 的支持。

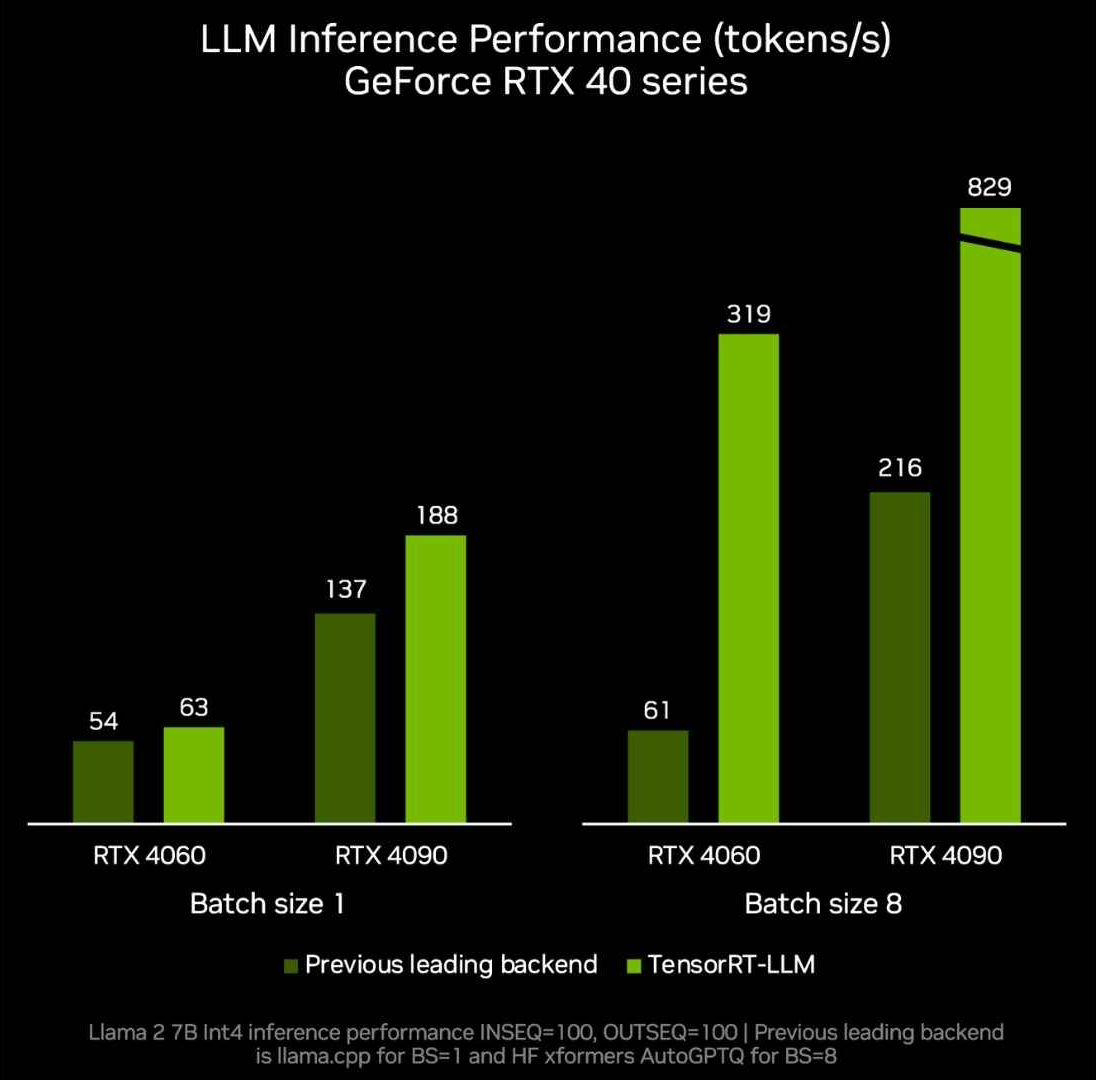

英伟达在今年10月份发布了Tensor RT-LLM开源库,旨在为数据中心和Windows PC提供支持。这一开源库的最大特点是,当Windows PC搭载英伟达的GeForce RTX GPU时,TensorRT-LLM能够将LLM在Windows PC上的运行速度提高四倍

英伟达在今天 Ignite 2023 大会上,宣布更新 TensorRT-LLM,添加 OpenAI 的 Chat API 支持,并增强 DirectML 功能,改善 Llama 2 和 Stable Diffusion 等 AI 模型的性能。

TensorRT-LLM 可以在本地使用英伟达的 AI Workbench 完成。开发者可以利用这个统一且易于使用的工具包,在个人电脑或工作站上快速创建、测试和定制预训练的生成式 AI 模型和 LLM。英伟达还为此推出了一个抢先体验注册页面

英伟达将于本月晚些时候发布 TensorRT-LLM 0.6.0 版本更新,推理性能提高 5 倍,并支持 Mistral 7B 和 Nemotron-3 8B 等其它主流 LLM。

在8GB显存以上的GeForce RTX 30系列和40系列GPU上,用户可以运行,并且一些便携式Windows设备也可以使用快速、准确的本地LLM功能

以上是英伟达揭示新版 TensorRT-LLM:推理能力增长 5 倍,适用于 8GB 以上显卡本地运行,并支持 OpenAI 的 Chat API的详细内容。更多信息请关注PHP中文网其他相关文章!