微软推出 XOT 技术,加强语言模型的推理能力

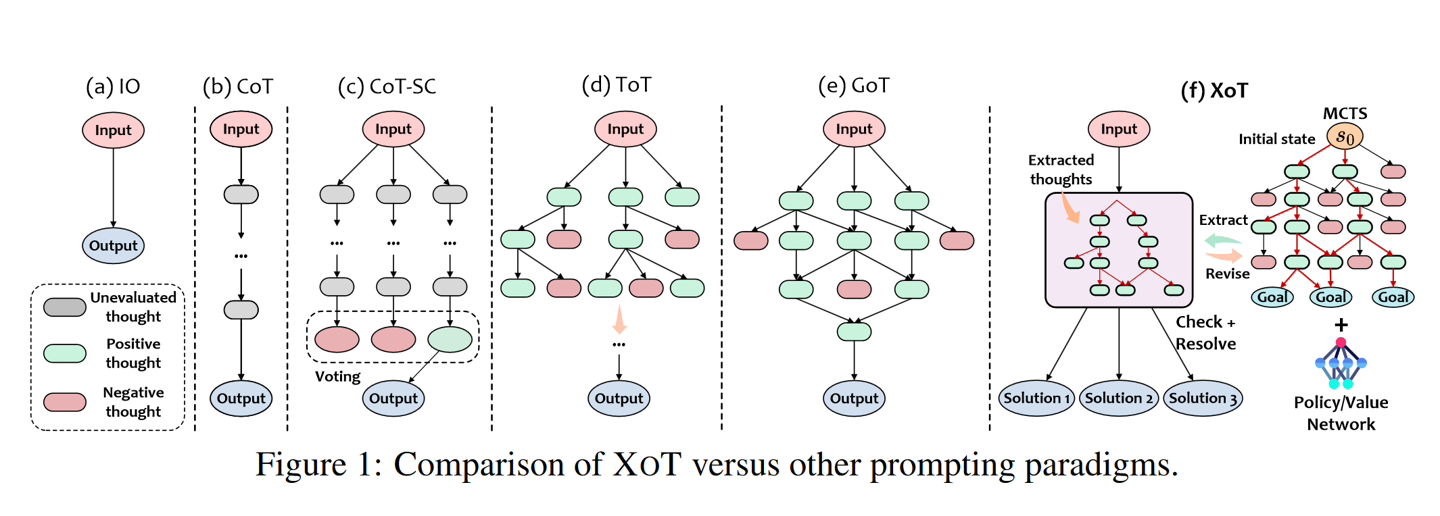

11 月 15 日消息,微软近日推出了名为“Everything of Thought”(XOT)的方法,灵感来自谷歌 DeepMind 的 AlphaZero,利用紧凑的神经网络,来增强 AI 模型推理能力。

微软和佐治亚理工学院、华东师范大学合作开发了该算法,整合了强化学习(reinforcement learning)和蒙特卡洛树搜索 (MCTS) 能力,在复杂决策环境中,进一步提高解决问题的有效性。

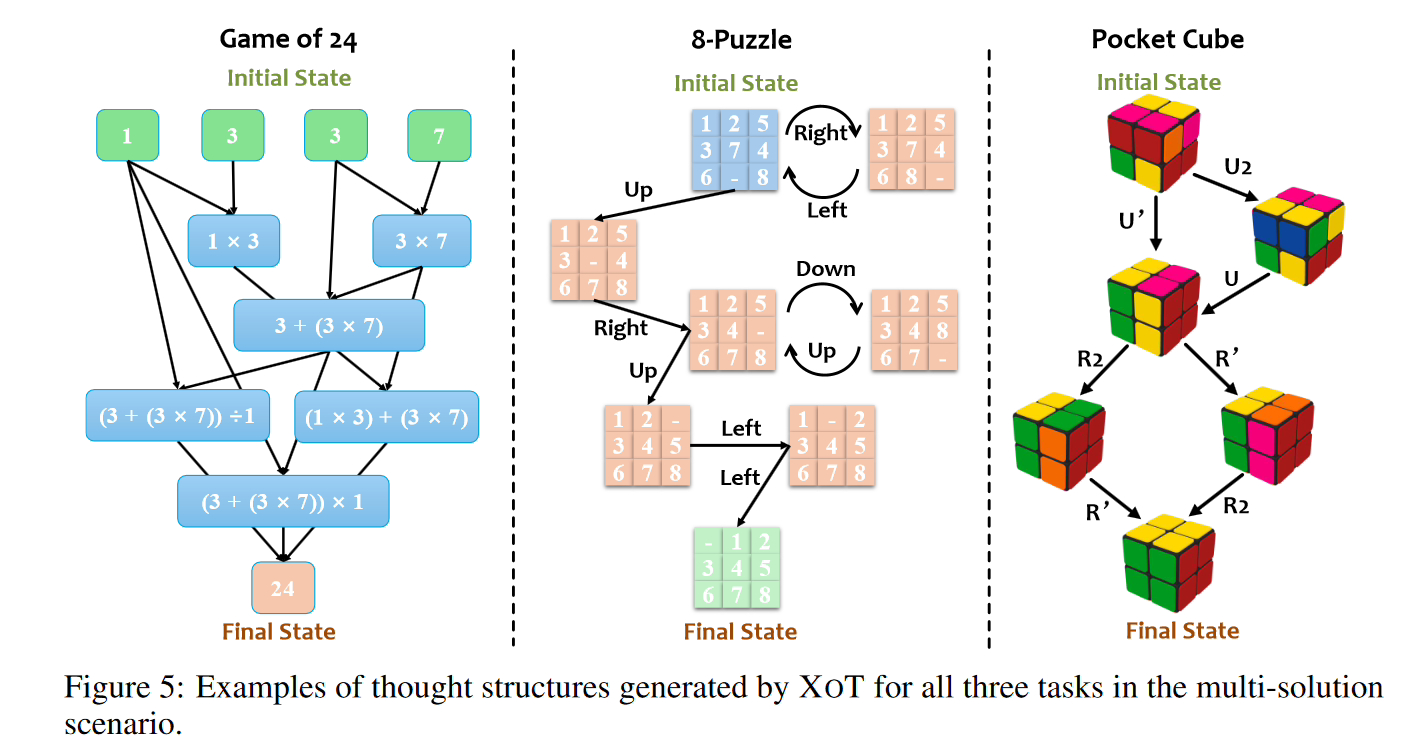

本站注意:微软研究团队表示,XOT方法可以使语言模型在不熟悉的问题上得到扩展,在Game of 24、8-Puzzle和Pocket Cube的严格测试中有明显的提升。结果显示,XOT明显优于其他方法,甚至解决了其他方法失败的问题。然而,XOT并没有达到100%的可靠性

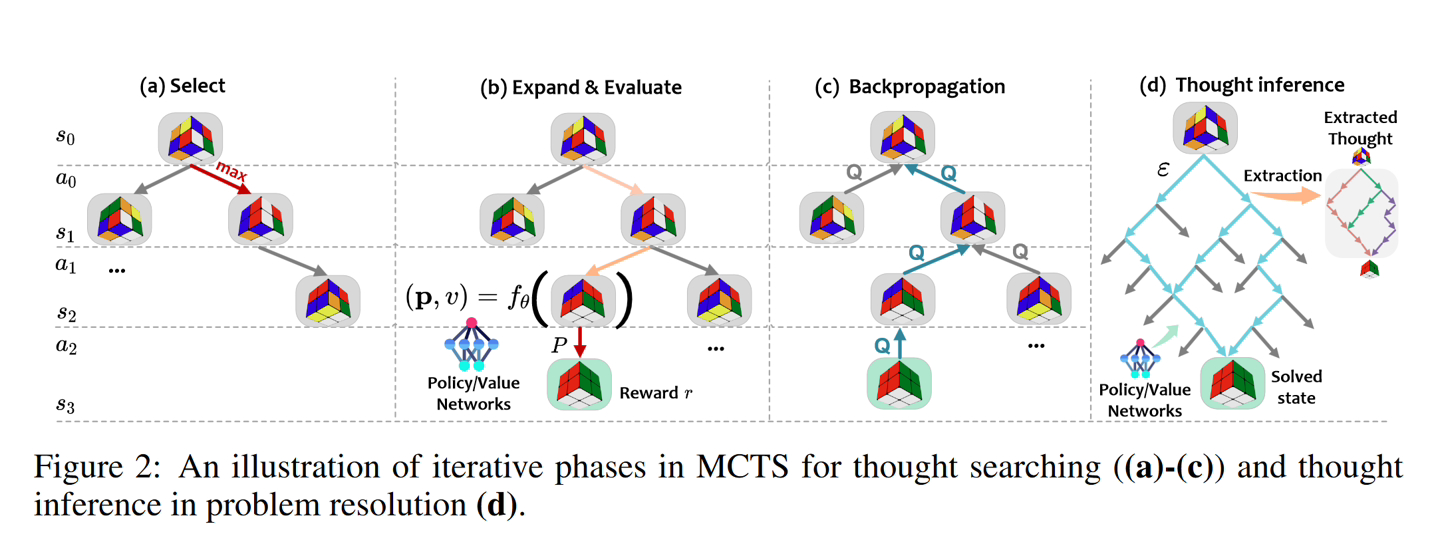

XOT 框架包括以下关键步骤:

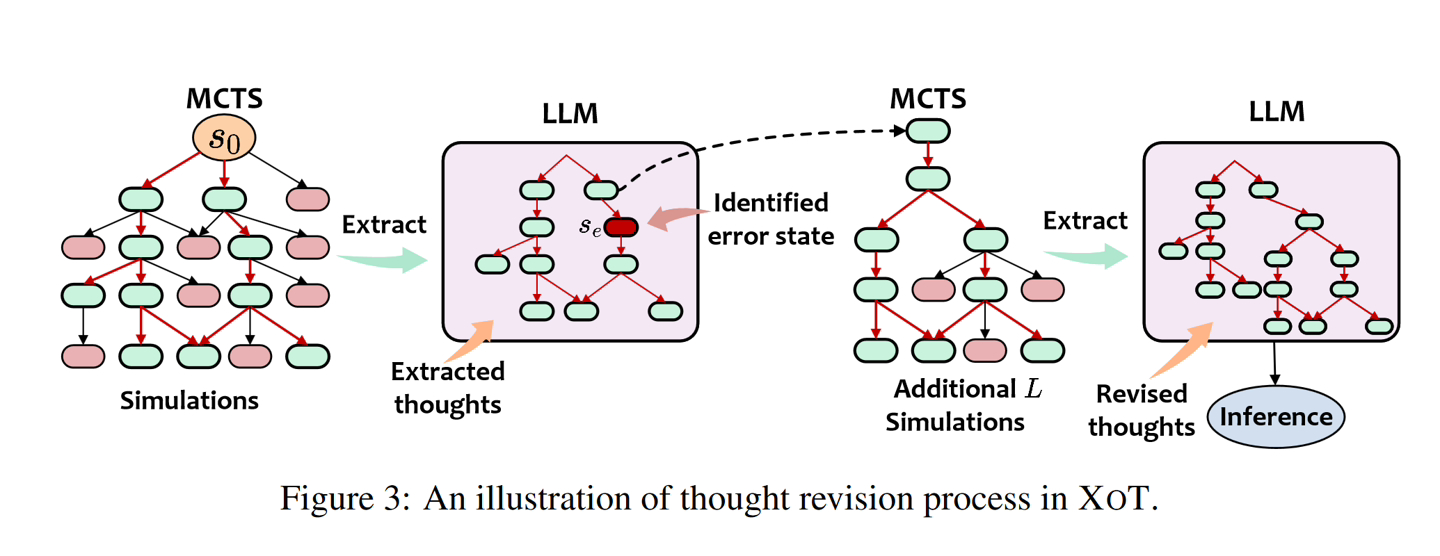

- 预训练阶段:MCTS 模块在特定任务上进行预训练,以学习有关有效思维搜索的领域知识。轻量级策略和价值网络指导搜索。思想搜索: 在推理过程中,预训练的 MCTS 模块使用策略 / 价值网络来有效地探索和生成 LLM 的思想轨迹。

- 思想修正:LLM 审查 MCTS 的思想并识别任何错误。修正的想法是通过额外的 MCTS 模拟产生的。

- LLM 推理: 将修改后的想法提供给 LLM 解决问题的最终提示。

本站在此附上论文 [PDF] 地址,感兴趣的用户可以深入阅读。

以上是微软推出 XOT 技术,加强语言模型的推理能力的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

语言模型是对文本进行推理的,文本通常是字符串形式,但模型的输入只能是数字,因此需要将文本转换成数字形式。Tokenization是自然语言处理的基本任务,根据特定需求能够把一段连续的文本序列(如句子、段落等)切分为一个字符序列(如单词、短语、字符、标点等多个单元),其中的单元称为token或词语。根据下图所示的具体流程,首先将文本句子切分成一个个单元,然后将单元素数值化(映射为向量),再将这些向量输入到模型进行编码,最后输出到下游任务进一步得到最终的结果。文本切分按照文本切分的粒度可以将Toke

Microsoft Edge升级:自动存密码功能遭禁?!用户惊了!

Apr 19, 2024 am 08:13 AM

Microsoft Edge升级:自动存密码功能遭禁?!用户惊了!

Apr 19, 2024 am 08:13 AM

4月18日消息,近日,一些使用Canary频道的MicrosoftEdge浏览器的用户反映,在升级到最新版本后,他们发现自动保存密码的选项被禁用了。经过调查,这是浏览器升级后的一个微调,而非功能被取消。在使用Edge浏览器访问网站前,用户反馈说浏览器会弹出一个窗口询问是否希望保存该网站的登录密码。选择保存后,在下一次登录时,Edge就会自动填充已保存的账号和密码,为用户提供了极大的便利。但最近的更新类似于微调,修改了默认设置。用户需要在选择保存密码后,再手动在设置中开启自动填充已保存的账号和密码

微软发布 Win11 八月累积更新:提高安全、优化锁屏等

Aug 14, 2024 am 10:39 AM

微软发布 Win11 八月累积更新:提高安全、优化锁屏等

Aug 14, 2024 am 10:39 AM

本站8月14日消息,在今天的8月补丁星期二活动日中,微软发布了适用于Windows11系统的累积更新,包括面向22H2和23H2的KB5041585更新,面向21H2的KB5041592更新。上述设备安装8月累积更新之后,本站附上版本号变化如下:21H2设备安装后版本号升至Build22000.314722H2设备安装后版本号升至Build22621.403723H2设备安装后版本号升至Build22631.4037面向Windows1121H2的KB5041585更新主要内容如下:改进:提高了

微软 Win11 压缩为 7z、TAR 文件的功能已从 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

微软 Win11 压缩为 7z、TAR 文件的功能已从 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

本站4月27日消息,微软本月初向Canary和Dev频道发布了Windows11Build26100预览版更新,预估会成为Windows1124H2更新的候选RTM版本。新版本中最主要的变化在于文件资源管理器、整合Copilot、编辑PNG文件元数据、创建TAR和7z压缩文件等等。@PhantomOfEarth发现,微软已经将24H2版本(Germanium)部分功能下放到23H2/22H2(Nickel)版本中,例如创建TAR和7z压缩文件。如示意图所示,Windows11将支持原生创建TAR

微软全屏弹窗催促:Windows 10用户抓紧时间升级到Windows 11

Jun 06, 2024 am 11:35 AM

微软全屏弹窗催促:Windows 10用户抓紧时间升级到Windows 11

Jun 06, 2024 am 11:35 AM

6月3日消息,微软正在积极向所有Windows10用户发送全屏通知,鼓励他们升级到Windows11操作系统。这一举措涉及了那些硬件配置并不支持新系统的设备。自2015年起,Windows10已经占据了近70%的市场份额,稳坐Windows操作系统的霸主地位。然而,市场占有率远超过82%的市场份额,占有率远超过2021年面世的Windows11。尽管Windows11已经推出已近三年,但其市场渗透率仍显缓慢。微软已宣布,将于2025年10月14日后终止对Windows10的技术支持,以便更专注于

微软Edge浏览器更新:新增'放大图像”功能,提升用户体验

Mar 21, 2024 pm 01:40 PM

微软Edge浏览器更新:新增'放大图像”功能,提升用户体验

Mar 21, 2024 pm 01:40 PM

3月21日消息,微软近日对其MicrosoftEdge浏览器进行了更新,新增了一项实用的“放大图像”功能。现在,用户在使用Edge浏览器时,只需右键点击图片,便可在弹出的菜单中轻松找到这一新功能。更为便捷的是,用户还可以将光标悬停在图片上方,然后双击Ctrl键,即可快速呼出放大图像的功能。根据小编的了解,最新发布的MicrosoftEdge浏览器已经在Canary频道进行了新功能测试。该浏览器的稳定版中也已经正式推出了实用的“放大图像”功能,为用户提供了更便捷的图片浏览体验。外国科技媒体也对这一

云端部署大模型的三个秘密

Apr 24, 2024 pm 03:00 PM

云端部署大模型的三个秘密

Apr 24, 2024 pm 03:00 PM

编译|星璇出品|51CTO技术栈(微信号:blog51cto)在过去的两年里,我更多地参与了使用大型语言模型(LLMs)的生成AI项目,而非传统的系统。我开始怀念无服务器云计算。它们的应用范围广泛,从增强对话AI到为各行各业提供复杂的分析解决方案,以及其他许多功能。许多企业将这些模型部署在云平台上,因为公共云提供商已经提供了现成的生态系统,而且这是阻力最小的路径。然而,这并不便宜。云还提供了其他好处,如可扩展性、效率和高级计算能力(按需提供GPU)。在公共云平台上部署LLM的过程有一些鲜为人知的

Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动

May 30, 2024 pm 01:24 PM

Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动

May 30, 2024 pm 01:24 PM

MetaFAIR联合哈佛优化大规模机器学习时产生的数据偏差,提供了新的研究框架。据所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个GPU。以LLaMA270B模型为例,其训练总共需要1,720,320个GPU小时。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。最近,许多机构在训练SOTA生成式AI模型时报告了训练过程中的不稳定情况,它们通常以损失尖峰的形式出现,比如谷歌的PaLM模型训练过程中出现了多达20次的损失尖峰。数值偏差是造成这种训练不准确性的根因,