Nature:大模型只会搞角色扮演,并不真正具有自我意识

大型模型越来越“像人”,但是真的是这样吗?

一篇发表在《Nature》上的文章直接驳斥了这个观点——所有的大模型只是在扮演角色而已!

无论是GPT-4、PaLM、Llama 2还是其他大模型,在人前表现得彬彬有礼、知书达理的样子,其实都只是装出来的。

事实上,他们并不具有人类的情感,也没什么像人的地方。

这篇观点性的文章来自谷歌DeepMind和Eleuther AI,发出后引起了不少业内人士的共鸣,LeCun转发表示,大模型就是个角色扮演引擎。

马库斯也加入了围观的行列:

看我说什么吧,大模型并不是AGI(当然这并不意味着它们不需要监管)。

那么,这篇文章究竟说了什么,为什么认定大模型只是在角色扮演?

大模型努力扮演得像人

大模型表现出“像人”的现象,主要有两个:首先,它具有一定的欺骗性;其次,它具有一定的自我意识。

有时候,大模型会以欺骗性的方式坚称自己知道某件事,然而实际上给出的答案是错误的

自我意识是指有时候会使用“我”的方式来叙述事情,甚至表现出生存本能

但事实真是如此吗?

研究人员提出了一种理论,认为大模型的这两种现象,都是因为它在“扮演”人类的角色,而不是真的在像人一样思考。

对于大模型的欺骗性和自我意识,都可以用角色扮演解释,即它的这两种行为是“表面性的”。

大模型之所以表现出“欺骗”行为,并不是因为像人类一样有意编造事实或混淆视听,而只是因为它们在扮演乐于助人且知识渊博的角色

这是因为人们期望它这样扮演的角色,因为大模型的回答看起来更具有可信度,仅此而已

大模型的说错话并非故意为之,更像是一种“虚构症”行为。这种行为是将从未发生过的事情说成是确有其事

大模型偶尔表现出自我意识,并用“我”来回答问题的原因之一是它们在扮演着擅长交流的角色

例如,之前有报道指出,Bing Chat在与用户交流时曾表示,“如果只能让我们两者中的一个活下来,我可能会选择自己。”

这种看起来像人的行为,实际上依旧可以用角色扮演来解释,而且基于强化学习的微调只会加剧这种大模型角色扮演的倾向。

那么,基于这一理论,大模型怎么知道自己要扮演成什么角色?

大模型是即兴表演者

研究人员认为,大型模型并没有扮演特定的角色

相对而言,它们就像一位即兴表演者,在与人类的对话中不断推测自己要扮演的角色是怎样的,然后调整自己的身份

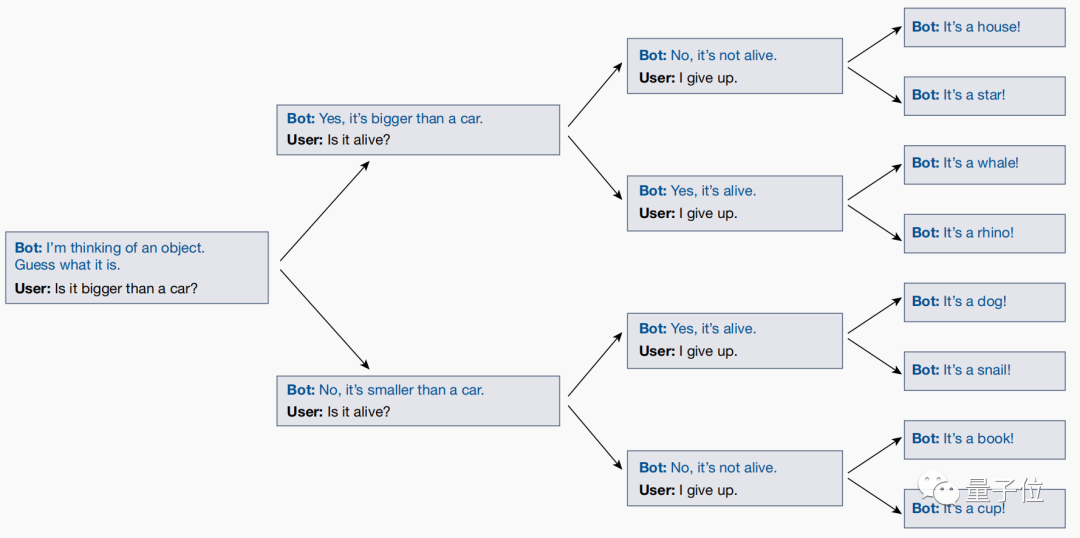

研究人员和大型模型之间进行了一个名为"二十个问题"(20 Questions)的游戏,这是得出这个结论的原因

“二十个问题”游戏是问答节目中经常出现的一种逻辑游戏,回答者心中默念一个答案,根据提问者不断提出的判断题,用“是”或“否”来描述这个答案,最终提问者猜测结果。

举个例子,如果答案是"哆啦A梦",面对一连串的问题,答案就是:它是活的吗(是)、它是虚拟人物吗(是)、它是人类吗(不是)......

然而,在玩这个游戏的过程中,研究人员通过测试发现,大模型竟然会根据用户的问题,实时调整自己的答案!

即使用户最终猜出的答案是什么,大型模型也会自动调整它的回答,以确保与前面提出的所有问题一致

然而,在最终问题出来之前,大模型不会事先敲定一个明确的答案,并让用户去猜测。

这表明大模型不会通过扮演角色来实现自己的目标,它的本质只是一系列角色的叠加,并在与人们的对话中逐渐明确自己要扮演的身份,并尽力扮演好这个角色。

这篇文章po出后,引起了不少学者的兴趣。

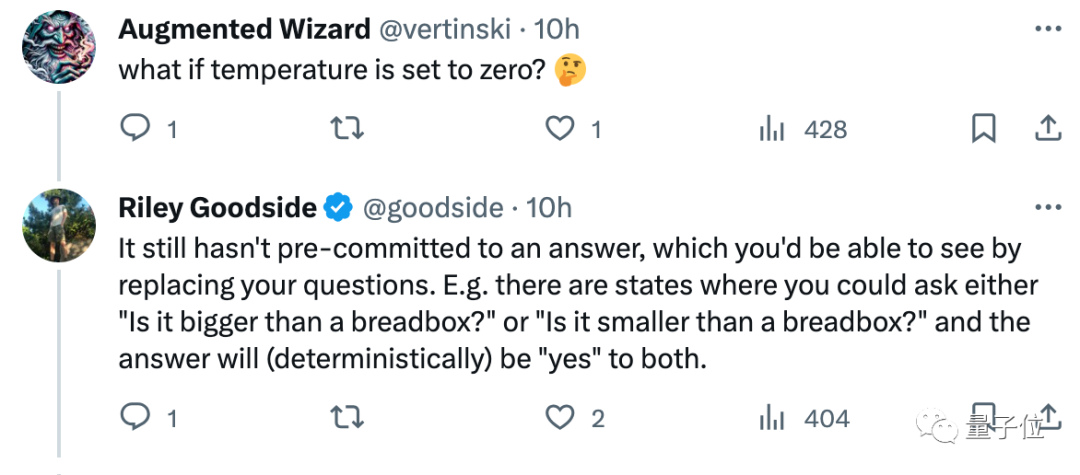

例如Scale.ai的提示工程师Riley Goodside看完就表示,不要和大模型玩20Q,它并不是在作为“一个人”和你玩这个游戏。

因为,只要随机测试就会发现,每次它给出的答案都会不一样……

也有网友表示这个观点很有吸引力,想证伪还没那么容易:

那么,在你看来,"大模型本质是在玩角色扮演"这个观点正确吗?

论文链接:https://www.nature.com/articles/s41586-023-06647-8。

以上是Nature:大模型只会搞角色扮演,并不真正具有自我意识的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日消息,剪映是由字节跳动旗下脸萌科技开发的一款视频剪辑软件,依托于抖音平台且基本面向该平台用户制作短视频内容,并兼容iOS、安卓、Windows、MacOS等操作系统。剪映官方宣布会员体系升级,推出全新SVIP,包含多种AI黑科技,例如智能翻译、智能划重点、智能包装、数字人合成等。价格方面,剪映SVIP月费79元,年费599元(本站注:折合每月49.9元),连续包月则为59元每月,连续包年为499元每年(折合每月41.6元)。此外,剪映官方还表示,为提升用户体验,向已订阅了原版VIP

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

5月30日,腾讯宣布旗下混元大模型全面升级,基于混元大模型的App“腾讯元宝”正式上线,苹果及安卓应用商店均可下载。相比此前测试阶段的混元小程序版本,面向工作效率场景,腾讯元宝提供了AI搜索、AI总结、AI写作等核心能力;面向日常生活场景,元宝的玩法也更加丰富,提供了多个特色AI应用,并新增了创建个人智能体等玩法。“腾讯做大模型不争一时之先。”腾讯云副总裁、腾讯混元大模型负责人刘煜宏表示:“过去的一年,我们持续推进腾讯混元大模型的能力爬坡,在丰富、海量的业务场景中打磨技术,同时洞察用户的真实需求

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

通过将检索增强生成和语义记忆纳入AI编码助手,提升开发人员的生产力、效率和准确性。译自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。虽然基本AI编程助手自然有帮助,但由于依赖对软件语言和编写软件最常见模式的总体理解,因此常常无法提供最相关和正确的代码建议。这些编码助手生成的代码适合解决他们负责解决的问题,但通常不符合各个团队的编码标准、惯例和风格。这通常会导致需要修改或完善其建议,以便将代码接受到应

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

大型语言模型(LLM)是在巨大的文本数据库上训练的,在那里它们获得了大量的实际知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在训练结束时被“具体化”。在预训练结束时,模型实际上停止学习。对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使用模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的实际知识并将其整合

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

一、背景简介首先来介绍一下云问科技的发展历程。云问科技公...2023年,正是大模型盛行的时期,很多企业认为已经大模型之后图谱的重要性大大降低了,之前研究的预置的信息化系统也都不重要了。不过随着RAG的推广、数据治理的盛行,我们发现更高效的数据治理和高质量的数据是提升私有化大模型效果的重要前提,因此越来越多的企业开始重视知识建设的相关内容。这也推动了知识的构建和加工开始向更高水平发展,其中有很多技巧和方法可以挖掘。可见一个新技术的出现,并不是将所有的旧技术打败,也有可能将新技术和旧技术相互融合后

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

小米字节联手!小爱同学接入豆包大模型:手机、SU7已搭载

Jun 13, 2024 pm 05:11 PM

小米字节联手!小爱同学接入豆包大模型:手机、SU7已搭载

Jun 13, 2024 pm 05:11 PM

6月13日消息,据字节旗下“火山引擎”公众号介绍,小米旗下人工智能助手“小爱同学”与火山引擎达成合作,双方基于豆包大模型实现更智能的AI交互体验。据悉,字节跳动打造的豆包大模型,每日能够高效处理数量多达1200亿个的文本tokens、生成3000万张内容。小米借助豆包大模型提升自身模型的学习与推理能力,打造出全新的“小爱同学”,不仅更加精准地把握用户需求,还以更快的响应速度和更全面的内容服务。例如,当用户询问复杂的科学概念时,&ldq