LCM:大大加快生成高质量图像的新方法

作者丨Mike Young

译文:重新创作内容而不改变原义的语言是中文,无需出现原句

审校内容,无需改变原意,需要将语言改写为中文,不需要出现原句

推荐 | 51CTO技术栈(微信号:blog51cto)

图片

图片

由于一项名为潜在一致性模型(LCM)的新技术的出现,AI将迎来在将文本转换成图像方面的重大突破。传统方法如潜在扩散模型(LDM)在使用文本提示生成详细、创造性图像方面表现出色,但其致命缺点是速度较慢。使用LDM生成单个图像可能需要进行数百个步骤,这对于许多实际应用来说速度实在太慢了

重新写成中文: LCM通过减少生成图像所需步骤的数量来改变游戏规则。与LDM需要数百步才能辛苦地生成图像相比,LCM只需1到4步就能得到类似质量的结果。为了实现这种效率,LCM将预训练的LDM提炼成更简洁的形式,从而大大减少了所需的计算资源和时间。我们将分析一篇最近的论文,介绍LDM模型的工作原理

本文还介绍了一种名为LCM-LoRA的创新,这是一种通用的Stable-Diffusion加速模块。该模块可以插入到各种Stable--Diffusion微调模型,无需任何额外的训练。它是一种普遍适用的工具,可以加速各种图像生成任务,使其成为利用AI创建图像的潜在利器。我们还将剖析论文的这个部分。

1、高效训练LCM

在神经网络领域,存在一个巨大的挑战,即需要庞大的计算能力,尤其是在训练复杂方程的神经网络时。然而,这篇论文的团队采用了一种名为提炼的巧妙方法,成功地解决了这个问题

重写后的内容: 研究团队的方法如下:首先,他们使用一个文本与图像配对的数据集来训练一个标准的潜在扩散模型(LDM)。一旦LDM被启动并运行,他们将其用作导师,生成新的训练数据。然后,他们使用这些新数据来训练潜在一致性模型(LCM)。最吸引人的是,LCM可以从LDM的能力中学习,而无需从头开始使用庞大的数据集进行训练

真正重要的是这个过程的效率。研究人员仅使用单个GPU就在大约32小时内完成了高质量LCM的训练。这很重要,因为它比以前的方法快得多、实用得多。这意味着现在更多的人和项目都可以创建这种先进的模型,而不是只有享有超级计算资源的人才能创建。

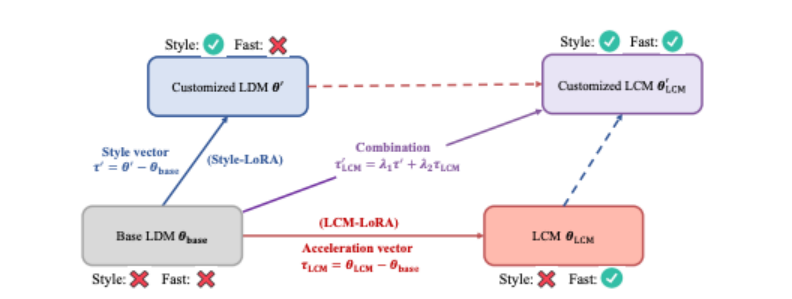

图1、LCM-LoRA概述

图1、LCM-LoRA概述

通过将LoRA引入到LCM的提炼过程中,我们显著降低了提炼的内存开销,这使得我们可以用有限的资源训练更庞大的模型,比如SDXL和SSD-1B。更重要的是,通过LCM-LoRA训练获得的LoRA参数(“加速向量”)可以直接与通过针对特定样式的数据集进行微调获得的其他LoRA参数(“样式向量”)结合起来。无需任何训练,由加速向量和样式向量的线性组合获得的模型获得了以最少的采样步骤生成特定绘画样式的图像这种能力。

2、结果

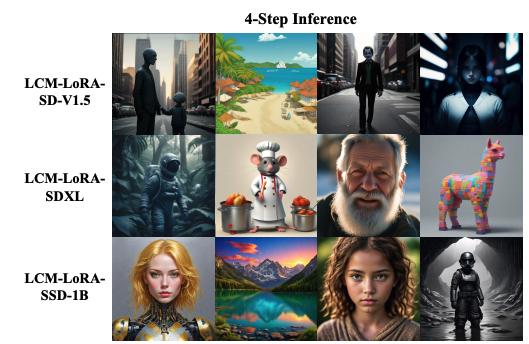

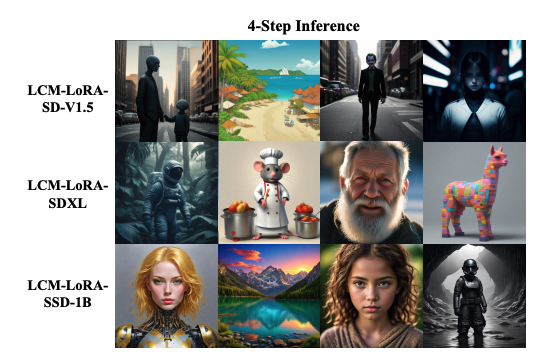

该研究展示了基于潜在一致性模型(LCM)利用AI生成图像方面的重大进展。LCM擅长仅用四个步骤就能创建高质量的512x512图像,与潜在扩散模型(LDM)等传统模型所需的数百个步骤相比有了显著改进。这些图像拥有清晰的细节和逼真的纹理,这个优点在下面的例子中尤为明显。

图片

图片

图2、论文声称:“使用从不同的预训练扩散模型中提取的潜在一致性模型生成的图像。我们使用LCM-LoRA-SD-V1.5生成512×512分辨率的图像,使用LCM-LoRA-SDXL和LCM-LoRA-SSD-1B生成1024×1024分辨率的图像。”

这些模型不仅可以轻松处理较小的图像,还擅长生成更庞大的1024x1024图像。它们展示了一种扩展到比以前大得多的神经网络模型的能力,展示了其适应能力。在论文中的示例中(比如LCM-LoRA-SD-V1.5和LCM-LoRA-SSD-1B版本的示例),阐明了该模型在各种数据集和实际场景中的广泛适用性

3、局限性

LCM的当前版本存在几处局限性。最重要的是两个阶段的训练过程:首先训练LDM,然后用它来训练LCM。在未来的研究中,可能会探索一种更直接的LDM训练方法,因而可能不需要LDM。论文主要讨论无条件图像生成,条件生成任务(比如文本到图像的合成)可能需要做更多的工作。

4、主要的启示

潜在一致性模型(LCM)在快速生成高质量图像方面迈出了重要一步。这些模型只需1到4步就能生成与较慢的LDM相媲美的结果,可能会彻底改变文本到图像模型的实际应用。虽然目前存在一些局限性,特别是在训练过程和生成任务的范围方面,但LCM标志着基于神经网络的实用图像生成取得了重大进展。提供的示例强调了这些模型的潜力

5、LCM-LoRA作为通用加速模块

在引言中提到的,该论文分为两个部分。第二部分讨论了LCM-LoRA技术,它能够使用较少的内存对预训练模型进行微调,从而提高效率

这里的关键创新是将LoRA参数集成到LCM中,从而生成结合两者优点的混合模型。这种集成对于创建特定样式的图像或响应特定任务特别有用。如果选择和组合不同的LoRA参数集,每个参数集又都针对独特的样式进行微调,研究人员创建了一个多功能模型,可以用最少的步骤生成图像,不需要额外的训练。

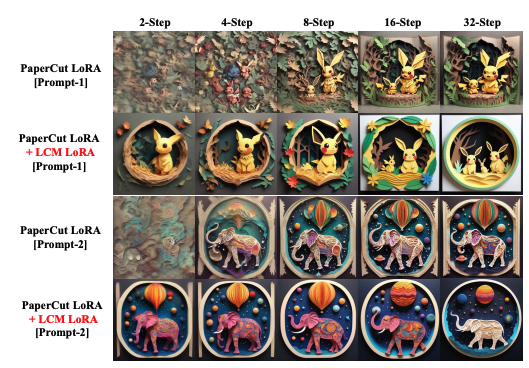

通过将针对特定绘画样式进行微调的LoRA参数与LCM-LoRA参数相结合的例子,他们在研究中证明了这一点。这种组合允许在不同的采样步骤(如2步、4步、8步、16步和32步)创建样式迥异的1024 × 1024分辨率图像。结果显示,这些组合的参数无需进一步训练即可生成高质量的图像,凸显了该模型的效率和通用性

这里值得关注的一个地方是使用所谓的“加速向量”(τLCM)和“样式向量”(τ),两者使用特定的数学公式(λ1和λ2是这些公式中的可调整因子)组合在一起。这种组合产生的模型可以快速地生成定制样式的图像。

论文中的图3(如下所示)通过展示特定样式LoRA参数与LCM-LoRA参数结合的结果,表明了这种方法的有效性。这证明了该模型能够快速高效地生成样式不同的图像。

图3

图3

总的来说,本文的这一部分强调了LCM-LoRA模型的通用性和高效性,它可以用于快速生成高质量的特定样式图像,而只需使用很少的计算资源。该技术的应用范围广泛,有望彻底改变从数字艺术到自动化内容创作等各个领域中图像生成的方式

6、结论

我们研究了一种新的方法,即潜在一致性模型(LCM),用于加快从文本生成图像的过程。与传统的潜在扩散模型(LDM)不同,LCM只需1到4个步骤即可生成质量相似的图像,而不需要数百个步骤。这种显著的效率提升是通过提炼方法实现的,即使用预训练的LDM来训练LCM,从而避免了大量的计算

此外,我们还研究了LCM-LoRA,这是一种使用低秩自适应(LoRA)对预训练模型进行微调的增强技术,以降低内存需求。这种集成方法可以在不需要额外训练的情况下,通过最小的计算步骤创建特定样式的图像

着重强调的关键结果包括LCM仅用几个步骤就能创建高质量的512x512和1024x1024图像,而LDM却需要数百个步骤。然而,目前存在的局限性是LDM依赖两步训练过程,因此你仍需要LDM开始入手!未来的研究可能会简化这个过程。

LCM特别是在提议的LCM-LoRA模型中与LoRA结合使用时,是一种非常巧妙的创新。它们提供了更快速、更高效地创建高质量图像这个优点,我认为它们在数字内容创建方面有着广泛的应用前景。

参考链接:https://notes.aimodels.fyi/lcm-lora-a-new-method-for-generating-high-quality-images-much-faster/

以上是LCM:大大加快生成高质量图像的新方法的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何在 Windows 11 中清除桌面背景最近的图像历史记录

Apr 14, 2023 pm 01:37 PM

如何在 Windows 11 中清除桌面背景最近的图像历史记录

Apr 14, 2023 pm 01:37 PM

Windows 11 改进了系统中的个性化功能,这使用户可以查看之前所做的桌面背景更改的近期历史记录。当您进入windows系统设置应用程序中的个性化部分时,您可以看到各种选项,更改背景壁纸也是其中之一。但是现在可以看到您系统上设置的背景壁纸的最新历史。如果您不喜欢看到此内容并想清除或删除此最近的历史记录,请继续阅读这篇文章,它将帮助您详细了解如何使用注册表编辑器进行操作。如何使用注册表编辑

如何在电脑上下载 Windows 聚光灯壁纸图像

Aug 23, 2023 pm 02:06 PM

如何在电脑上下载 Windows 聚光灯壁纸图像

Aug 23, 2023 pm 02:06 PM

窗户从来不是一个忽视美学的人。从XP的田园绿场到Windows11的蓝色漩涡设计,默认桌面壁纸多年来一直是用户愉悦的源泉。借助WindowsSpotlight,您现在每天都可以直接访问锁屏和桌面壁纸的美丽、令人敬畏的图像。不幸的是,这些图像并没有闲逛。如果您爱上了Windows聚光灯图像之一,那么您将想知道如何下载它们,以便将它们作为背景保留一段时间。以下是您需要了解的所有信息。什么是WindowsSpotlight?窗口聚光灯是一个自动壁纸更新程序,可以从“设置”应用中的“个性化>

如何在Python中使用图像语义分割技术?

Jun 06, 2023 am 08:03 AM

如何在Python中使用图像语义分割技术?

Jun 06, 2023 am 08:03 AM

随着人工智能技术的不断发展,图像语义分割技术已经成为图像分析领域的热门研究方向。在图像语义分割中,我们将一张图像中的不同区域进行分割,并对每个区域进行分类,从而达到对这张图像的全面理解。Python是一种著名的编程语言,其强大的数据分析和数据可视化能力使其成为了人工智能技术研究领域的首选。本文将介绍如何在Python中使用图像语义分割技术。一、前置知识在深入

iOS 17:如何在照片中使用一键裁剪

Sep 20, 2023 pm 08:45 PM

iOS 17:如何在照片中使用一键裁剪

Sep 20, 2023 pm 08:45 PM

借助iOS17照片应用,Apple可以更轻松地根据您的规格裁剪照片。继续阅读以了解如何操作。以前在iOS16中,在“照片”应用程序中裁剪图像涉及几个步骤:点击编辑界面,选择裁剪工具,然后通过捏合缩放手势或拖动裁剪工具的角来调整裁剪。在iOS17中,值得庆幸的是,苹果简化了这个过程,这样当你放大照片库中任何选定的照片时,一个新的“裁剪”按钮会自动出现在屏幕的右上角。点击它会弹出完整的裁剪界面,其中包含您选择的缩放级别,因此您可以裁剪到您喜欢的图像部分,旋转图像,反转图像,或应用屏幕比例,或使用标记

2D图像脑补3D人体,衣服随便搭,还能改动作

Apr 11, 2023 pm 02:31 PM

2D图像脑补3D人体,衣服随便搭,还能改动作

Apr 11, 2023 pm 02:31 PM

得益于 NeRF 提供的可微渲染,近期的三维生成模型已经在静止物体上达到了很惊艳的效果。但是在人体这种更加复杂且可形变的类别上,三维生成依旧有很大的挑战。本文提出了一个高效的组合的人体 NeRF 表达,实现了高分辨率(512x256)的三维人体生成,并且没有使用超分模型。EVA3D 在四个大型人体数据集上均大幅超越了已有方案,代码已开源。论文名称:EVA3D: Compositional 3D Human Generation from 2D image Collections论文地址:http

新视角图像生成:讨论基于NeRF的泛化方法

Apr 09, 2023 pm 05:31 PM

新视角图像生成:讨论基于NeRF的泛化方法

Apr 09, 2023 pm 05:31 PM

新视角图像生成(NVS)是计算机视觉的一个应用领域,在1998年SuperBowl的比赛,CMU的RI曾展示过给定多摄像头立体视觉(MVS)的NVS,当时这个技术曾转让给美国一家体育电视台,但最终没有商业化;英国BBC广播公司为此做过研发投入,但是没有真正产品化。在基于图像渲染(IBR)领域,NVS应用有一个分支,即基于深度图像的渲染(DBIR)。另外,在2010年曾很火的3D TV,也是需要从单目视频中得到双目立体,但是由于技术的不成熟,最终没有流行起来。当时基于机器学习的方法已经开始研究,比

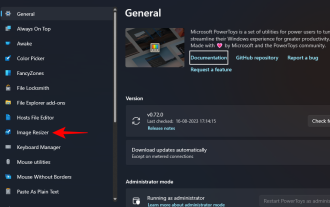

如何在Windows上使用PowerToys批量调整图像大小

Aug 23, 2023 pm 07:49 PM

如何在Windows上使用PowerToys批量调整图像大小

Aug 23, 2023 pm 07:49 PM

那些必须每天处理图像文件的人经常不得不调整它们的大小以适应他们的项目和工作的需求。但是,如果要处理的图像太多,则单独调整它们的大小会消耗大量时间和精力。在这种情况下,像PowerToys这样的工具可以派上用场,除其他外,可以使用其图像调整大小器实用程序批量调整图像文件的大小。以下是设置图像调整器设置并开始使用PowerToys批量调整图像大小的方法。如何使用PowerToys批量调整图像大小PowerToys是一个多合一的程序,具有各种实用程序和功能,可帮助您加快日常任务。它的实用程序之一是图像

一键抹去瑕疵、褶皱:深入解读达摩院高清人像美肤模型ABPN

Apr 12, 2023 pm 12:25 PM

一键抹去瑕疵、褶皱:深入解读达摩院高清人像美肤模型ABPN

Apr 12, 2023 pm 12:25 PM

随着数字文化产业的蓬勃发展,人工智能技术开始广泛应用于图像编辑和美化领域。其中,人像美肤无疑是应用最广、需求最大的技术之一。传统美颜算法利用基于滤波的图像编辑技术,实现了自动化的磨皮去瑕疵效果,在社交、直播等场景取得了广泛的应用。然而,在门槛较高的专业摄影行业,由于对图像分辨率以及质量标准的较高要求,人工修图师还是作为人像美肤修图的主要生产力,完成包括匀肤、去瑕疵、美白等一系列工作。通常,一位专业修图师对一张高清人像进行美肤操作的平均处理时间为 1-2 分钟,在精度要求更高的广告、影视等领域,该