一言不合就跑分,国内AI大模型为何沉迷于'刷榜”

“不服跑个分”这句话,我相信关注手机圈的朋友一定不会感到陌生。例如,安兔兔、GeekBench等理论性能测试软件因为能够在一定程度上反映手机的性能,因此备受玩家的关注。同样地,在PC处理器、显卡上也有相应的跑分软件来衡量它们的性能

既然"万物皆可跑分",目前最火爆的AI大模型也开始参与跑分比拼,尤其是在"百模大战"开始后,几乎每天都有突破,各家都自称为"跑分第一"

国产AI大模型在性能评分方面几乎从未落后,但在用户体验方面却始终无法超越GPT-4。这就引发了一个问题,即在大促销售节点,各手机厂商总能够宣称自家产品“销量第一”,通过不断增加定语,将市场细分再细分,让每个人都有机会成为第一,但在AI大模型领域,情况却不同。毕竟,它们的评估标准基本上是统一的,其中包括MMLU(用于衡量多任务语言理解能力)、Big-Bench(用于量化和外推LLMs的能力),以及AGIEval(用于评估应对人类级任务的能力)

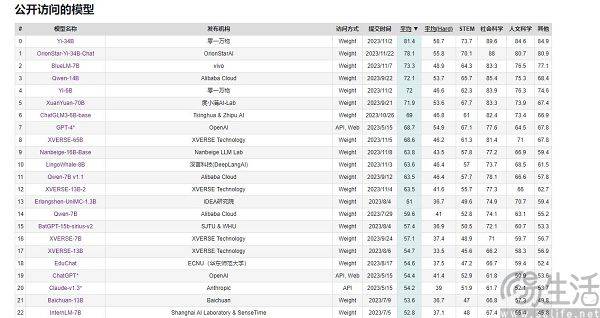

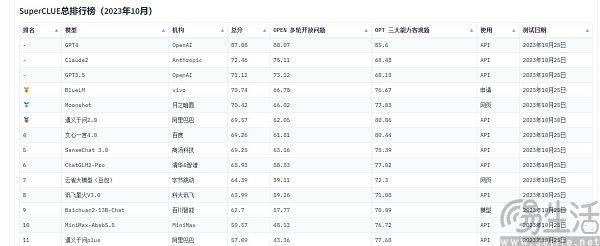

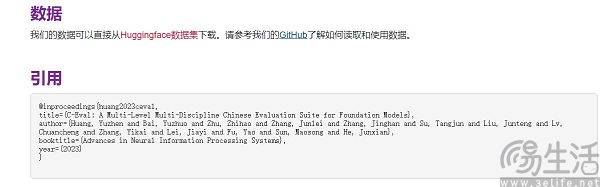

目前在国内常被引用的大型模型评测榜单有SuperCLUE、CMMLU和C-Eval。其中,CMMLU和C-Eval是由清华大学、上海交通大学和爱丁堡大学合作构建的综合性考试评测集。而CMMLU则是由MBZUAI、上海交通大学和微软亚洲研究院共同推出。至于SuperCLUE,则是由各大高校的人工智能专业人士共同编写的

以C-Eval为例,在9月初的榜单上,云天励飞大模型 " 云天书 " 排在第一、360排第八,GPT-4却只能排在第十名。既然标准是可量化的,为什么会出现反直觉的结果呢?大模型跑分榜单之所以会呈现出“群魔乱舞”的景象,其实是目前评价AI大模型性能的方法有局限性,它们是用“做题”的方式来衡量大模型的能力。

众所周知,智能手机的SoC、电脑的CPU和显卡为了保护自身寿命,在高温情况下会自动降频,而低温则能提升芯片性能。因此,有些人会将手机放入冰箱中,或者为电脑配备更强大的散热系统来进行性能测试,通常能得到比正常状态下更高的成绩。此外,各大手机厂商也会进行“专属优化”,针对各类跑分软件,这已经成为他们的标准操作了

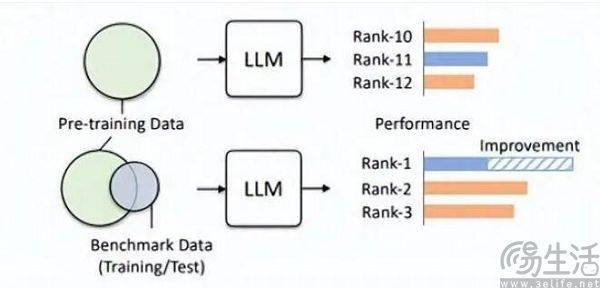

同样道理,人工智能大模型的评分以做题为核心,自然会有一个题库。没错,国内一些大模型在不断上榜的原因就在于这一点。由于各种原因,目前各大大模型榜单的题库对厂商几乎是单向透明的,也就是出现了所谓的“基准泄露”。例如,C-Eval榜单在刚上线时就有13948道题目,并且由于题库有限,出现了让某些不知名大模型通过刷题的方式“通关”的情况

大家可以想象一下,在考试之前,如果偶然看到了试卷和标准答案,然后突击背题,考试成绩将会大幅度提高。因此,将大模型榜单预设的题库加入训练集,这样一来大模型就成为了拟合基准数据的模型。而且,目前的LLM本身就以出色的记忆力而著称,背诵标准答案简直就是小菜一碟

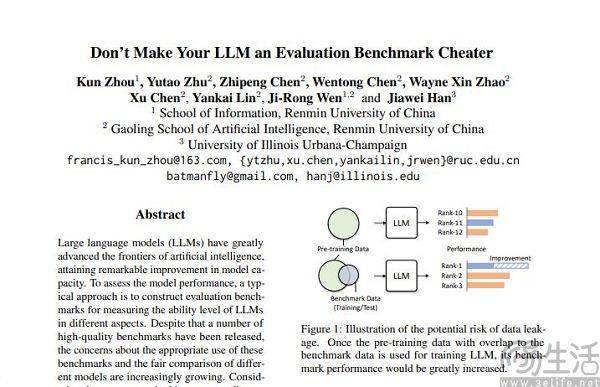

通过这一方式,小尺寸模型在跑分中也能拥有比大尺寸模型更好的结果,部分大模型取得的高分就是在这样的“微调”下实现。人大高瓴团队在论文《Don't Make Your LLM an Evaluation Benchmark Cheater》中,就直白地指明了此类现象,而且这种投机取巧的做法对于大模型的性能反而是有害的。

高瓴团队的研究人员发现,基准泄漏会导致大模型跑出夸张的成绩,例如1.3B的模型可以在某些任务上超越10倍体量的模型,但副作用就是这些专门为“应试”设计的大模型,在其他正常测试任务上的表现会受到不利影响。毕竟想想也能知道,AI大模型本来应该是“做题家”、却变成了“背题家”,为了获得某榜单的高分,去使用该榜单特定的知识和输出样式,肯定就会误导大模型。

训练集、验证集、测试集的不交叉显然只是理想状态,毕竟现实很骨感,数据泄露问题从根源上就几乎不可避免。随着相关技术的不断进步,当下大模型的基石Transformer结构的记忆和接收能力在不断提升,今年夏季微软研究院General AI的策略就已经实现了让模型接收1亿Tokens、而不会产生无法接受的遗忘。换而言之,未来AI大模型很有可能具有读取整个互联网的能力。

即使抛开技术进步,单纯以当下的技术水平,数据污染其实也难以规避,因为优质数据总归是稀缺、且产能有限的。AI研究团队Epoch在今年年初发表的论文就表明,AI不出5年就会把人类所有的高质量语料用光,而且这一结果是其将人类语言数据增长率,即全体人类未来5年内出版的书籍、撰稿的论文、编写的代码都考虑在内,所预测的结果。

如果一个数据集适合用于评估的话,那么它在预训练方面肯定也能够发挥更好的作用。例如,OpenAI的GPT-4就使用了权威的推理评估数据集GSM8K。因此,目前在大型模型评估领域存在一个尴尬的问题,大型模型对数据的需求似乎没有止境,这导致评估机构必须比人工智能大型模型制造商更快、更远地前进。然而,现如今评估机构似乎根本没有能力做到这一点

至于说为什么某些厂商会在大模型跑分上格外上心,纷纷去操作刷榜呢?其实这一行为背后的逻辑,就与App开发者给自家App的用户量注水一模一样。毕竟App的用户规模是衡量其价值的关键要素,而在当下这个AI大模型的起步阶段,评测榜单的成绩几乎就是唯一一个相对客观的评判标尺,毕竟在大众的认知里跑分高就等于性能强。

当刷榜可能带来强烈的宣传效应,甚至可能会为融资打下基础的情况下,商业利益的加入就必然会驱使AI大模型厂商争先恐后去刷榜了。

以上是一言不合就跑分,国内AI大模型为何沉迷于'刷榜”的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

2023年最新显卡性能排名列表

Jan 05, 2024 pm 11:12 PM

2023年最新显卡性能排名列表

Jan 05, 2024 pm 11:12 PM

2023最新显卡跑分排行榜已经发布,关注显卡天梯图的用户们都可以来看看,最近随着显卡厂商不断的发布新显卡,甚至还有老系列的推陈出新,新的榜单已经完全不一样了~2023最新显卡跑分排行榜显卡天梯排行2023年电脑显卡选购建议:1、低端显卡:RTX3050、5600XT、2060S都是不错的入门之选相当于买显卡送CPU,可用于玩LOL、Cf、守望先锋等轻量级3D网游,性价比突出,2、入门显卡:3060,适合多数一般的主流3D游戏,中低画质吃鸡。3、中端显卡:NVIDIA:RTX3060Ti、RTX2

麒麟9000S解锁跑分曝光:令人惊叹的性能超越预期

Sep 05, 2023 pm 12:45 PM

麒麟9000S解锁跑分曝光:令人惊叹的性能超越预期

Sep 05, 2023 pm 12:45 PM

华为最新发布的Mate60Pro手机在国内市场开售后,引起了广泛关注。然而,最近在跑分平台上出现了一些关于该机搭载的麒麟9000S处理器性能的争议。根据平台的测试结果显示,麒麟9000S的跑分并不完整,其中GPU跑分存在缺失,导致一些跑分软件无法适配根据网上曝光的信息显示,麒麟9000S在解锁跑分测试中取得了惊人的950935分的总分。具体来看,CPU跑分高达279677分,而之前缺失的GPU跑分则为251152分。与之前安兔兔官方测试的总分699783分相比,这显示出麒麟9000S在性能方面的

AI大模型浪潮下算力需求爆增,商汤“大模型+大算力”赋能多产业发展

Jun 09, 2023 pm 07:35 PM

AI大模型浪潮下算力需求爆增,商汤“大模型+大算力”赋能多产业发展

Jun 09, 2023 pm 07:35 PM

近日,以“AI引领时代,算力驱动未来”为主题的“临港新片区智算大会”举行。会上,新片区智算产业联盟正式成立,商汤科技作为算力提供企业成为联盟一员,同时商汤科技被授予“新片区智算产业链链主”企业。作为临港算力生态的积极参与者,商汤目前已建设了亚洲目前最大的智能计算平台之一——商汤AIDC,可以输出5000Petaflops的总算力,可支持20个千亿参数量的超大模型同时训练。以AIDC为底座、前瞻打造的商汤大装置SenseCore,致力于打造高效率、低成本、规模化的下一代AI基础设施与服务,赋能人工

研究者:AI模型推理环节耗电更多,2027年行业用电将堪比荷兰

Oct 14, 2023 am 08:25 AM

研究者:AI模型推理环节耗电更多,2027年行业用电将堪比荷兰

Oct 14, 2023 am 08:25 AM

IT之家10月13日消息,《Cell》的姐妹期刊《Joule》本周出版了一篇名为《持续成长的人工智慧能源足迹(Thegrowingenergyfootprintofartificialintelligence)》论文。通过查询,我们了解到这篇论文是由科研机构Digiconomist的创始人AlexDeVries发表的。他声称未来人工智能的推理性能可能会消耗大量的电力,预计到2027年,人工智能的用电量可能会相当于荷兰一年的电力消耗量AlexDeVries表示,外界一向认为训练一个AI模型“AI最

OPPO Reno11 F现身Geekbench:搭载天玑7050

Feb 06, 2024 pm 11:10 PM

OPPO Reno11 F现身Geekbench:搭载天玑7050

Feb 06, 2024 pm 11:10 PM

2月6日消息,据媒体报道,OPPO去年发布了OPPOReno11系列,提供标准版和Pro版两种版本,如今OPPO还将带来Reno11系列的新版本——Reno11F。目前,OPPOReno11F已经现身Geekbench6数据库,新机单核跑分897分,多核跑分2329分。根据基准测试,新机搭载的是联发科天玑7050SoC,搭配Mali-G68MC4GPU和8GBRAM,出厂预装基于Android14打造的ColorOS14系统。根据爆料,OPPOReno11F将采用一块6.7英寸的A

四倍提速,字节跳动开源高性能训练推理引擎LightSeq技术揭秘

May 02, 2023 pm 05:52 PM

四倍提速,字节跳动开源高性能训练推理引擎LightSeq技术揭秘

May 02, 2023 pm 05:52 PM

Transformer模型出自于Google团队2017年发表的论文《Attentionisallyouneed》,该论文中首次提出了使用Attention替换Seq2Seq模型循环结构的概念,给NLP领域带来了极大冲击。且随着近年来研究的不断推进,Transformer相关技术逐渐由自然语言处理流向其他领域。截止目前,Transformer系列模型已经成为了NLP、CV、ASR等领域的主流模型。因此,如何更快地训练和推理Transformer模型已成为业界的一个重要研究方向。低精度量化技术能够

中国联通发布图文AI大模型,可实现以文生图、视频剪辑

Jun 29, 2023 am 09:26 AM

中国联通发布图文AI大模型,可实现以文生图、视频剪辑

Jun 29, 2023 am 09:26 AM

驱动中国2023年6月28日消息,今日在上海世界移动通信大会期间,中国联通发布图文大模型“鸿湖图文大模型1.0”。中国联通称,鸿湖图文大模型是首个面向运营商增值业务的大模型。第一财经记者了解到,鸿湖图文大模型目前拥有8亿训练参数和20亿训练参数两个版本,可以实现以文生图、视频剪辑、以图生图等功能。此外,中国联通董事长刘烈宏在今天的主题演讲中也表示,生成式AI正在迎来发展的奇点,未来2年内50%的工作将受到人工智能深刻影响。

一加Ace 3V现身Geekbench平台:全球首发骁龙7+ Gen3

Mar 12, 2024 pm 10:34 PM

一加Ace 3V现身Geekbench平台:全球首发骁龙7+ Gen3

Mar 12, 2024 pm 10:34 PM

3月12日消息,一加Ace3V手机目前已经现身Geekbench跑分平台,型号为PJF110。在Geekbench6跑分中,一加Ace3V取得了最高单核1848、多核5007的分数,并于Geekbench5中取得了单核1416、多核4829的分数,接近天玑9200+。据悉,一加Ace3V将会全球首发骁龙7+Gen3移动平台,基于台积电4nm工艺制程制造,采用“1+4+3”的核心配置,其中Cortex-X4超大核频率为2.9GHz,集成Adreno732GPU。续航方面,该机配备55