AAAI2024:Far3D - 创新的直接干到150m视觉3D目标检测思路

最近在 Arxiv 上阅读到一篇关于纯视觉环视感知的最新研究,该研究基于 PETR 系列方法,并专注于解决远距离目标检测的纯视觉感知问题,将感知范围扩大到150米。这篇论文的方法和结果对我们来说有很大的参考价值,所以我尝试着对其进行解读

原标题:Far3D: Expanding the Horizon for Surround-view 3D Object Detection

论文链接:https:/ /arxiv.org/abs/2308.09616

作者单位:北京理工大学& 旷视科技

任务背景

三维物体检测在理解自动驾驶的三维场景方面发挥着重要作用,其目的是对自车周围的物体进行精确定位和分类。纯视觉环视感知方法具有成本低、适用性广等优点,已取得显着进展。然而,它们大多侧重于近距离感知(例如,nuScenes的感知距离约为 50 米),对远距离探测领域的探索较少。检测远距离物体对于实际驾驶中保持安全距离至关重要,尤其是在高速或复杂路况下。

近来,从环视图像中进行三维物体检测取得了显着进展,其部署成本较低。然而,大多数研究主要集中在近距离感知范围,对远距离检测的研究较少。将现有方法直接扩展到覆盖长距离会面临计算成本高、收敛性不稳定等挑战。为了解决这些局限性,本文提出了一种新的基于稀疏查询的框架,称为 Far3D。

论文思路

根据中间表征,现有的环视感知方法可以大致分为两类:基于BEV表征和基于稀疏查询表征的方法。基于BEV表征的方法由于需要计算密集的BEV特征,计算量非常大,难以扩展到远距离场景。而基于稀疏查询表征的方法会从训练数据中学习到全局的3D查询,计算量相对较小,且具有较强的扩展性。然而,它也存在一些弱点,尽管可以避免查询数量的平方增长,但全局固定查询不易适应动态场景,在远距离检测中通常会遗漏目标

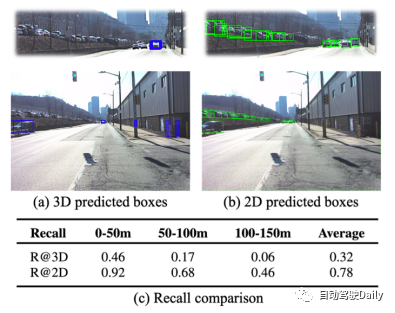

图1:Argoverse 2 数据集上,3D检测和2D 检测的性能对比。

在远距离检测中,基于稀疏 query 表征的方法有两个主要挑战。

- 首先是召回性能较差。由于 query 在 3D 空间分布的稀疏性,在远距离范围只能产生少量匹配的 positive query。如上图所示,3D 检测的召回率较低,而现有 2D 检测的召回率要高得多,两者之间存在明显的性能差距。因此,利用高质量的 2D 物体先验来改进 3D query 是一种很有潜力的方法,它有利于实现物体的精确定位和全面覆盖。

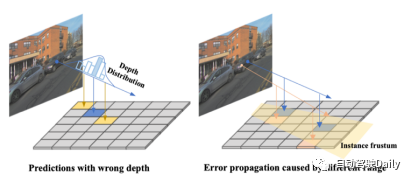

- 其次,直接引入 2D 检测结果来帮助 3D 检测会面临误差传播的问题。如下图所示,两种主要来源是 1) 由于深度预测不准的物体定位误差;2) 随着距离的增大,视锥变换中的 3D 位置误差也会增大。这些 noisy query 会影响训练的稳定性,需要有效的去噪方法来优化。此外,在训练过程中,模型会表现出对密集的近距离物体过度拟合的倾向,而忽略稀疏分布的远距离物体。

为了应对以上提到的问题,本文采取了以下设计方案:

- 除了从数据集中学到的 3D global query 外,还引入了由 2D 检测结果生成的 3D adaptive query。具体地,首先利用 2D 检测器和深度预测网络得到 2D 框和对应深度,再通过空间变换投射到 3D 空间,作为 3D adaptive query 的初始化。

- 为了适应不同距离的物体的尺度不同,设计了 Perspective-aware Aggergation。它使得 3D query 可以和不同尺度的特征交互,有利于不同距离物体的特征捕捉。比如,远处物体需要大分辨率的特征,而近处则不同。模型通过这种设计可以自适应地与特征交互。

- 设计了一种称为 Range-modulated 3D Denoising 的策略,以减轻 query 错误传播和收敛缓慢的问题。考虑到不同距离的 query 回归难度不同,noisy query 根据真实框的距离和尺度来调整。将 GT 附近的多组 noisy query 输入解码器,来分别实现重建3D 真实框(对于正样本)和舍弃负样本的作用。

主要贡献

- 本文提出了一种新的基于稀疏 query 的检测框架,它利用高质量的 2D object prior 来生成 3D adaptive query, 从而扩大三维检测的感知范围。

- 本文设计了 Perspective-aware Aggregation 模块,它从不同尺度和视角聚合视觉特征,以及一个基于目标距离的 3D Denoising 策略,来解决 query 误差传播和框架收敛问题。

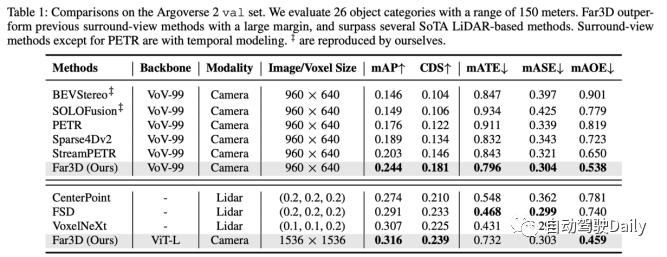

- 在远距离的 Argoverse 2 数据集的实验结果表明,Far3D 超越了此前的环视方法,并优于几种基于激光雷达的方法。并且在 nuScenes 数据集上验证了其通用性。

模型设计

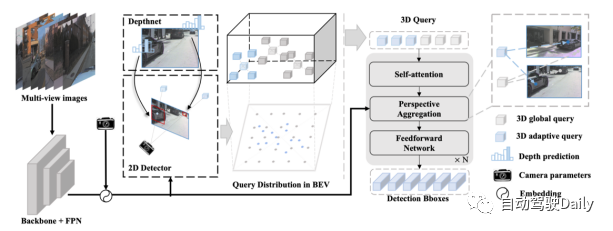

Far3D 流程概览:

- 将环视图像输入主干网络和 FPN 层,编码得到 2D 图像特征,并将其与相机参数进行编码。

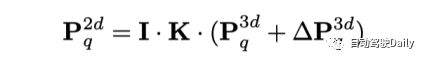

- 利用 2D 检测器和深度预测网络,生成可靠的 2D 物体框及其相应深度,然后通过相机变换投影到 3D 空间。

- 生成的3D adaptive query 与初始的 3D global query 相结合,由解码器层迭代回归,以预测 3D 物体框。更进一步,该模型可通过长时序的 query 传播实现时序建模。

Perspective-aware Aggregation:

为了给远距离检测模型引入多尺度特征,本文应用了 3D spatial deformable attention。它先在 query 对应的 3D 位置附近进行偏移采样,而后通过 3D-2D 视图变换聚合图像特征。这种方法替代 PETR 系列中的 global attention 的优势在于,计算量可以大幅降低。具体地,对于 3D 空间中的每个 query 的参考点,模型会学习其周围的 M 个采样偏移,并将这些偏移点投影到不同的 2D 视图特征中。

其后,3D query 与投影得到的采样特征交互。通过这种方式,来自不同视角和尺度的各种特征将通过考虑其相对重要性汇聚到三维查询中。

Range-modulated 3D Denoising:

不同距离的 3D query 具有不同的回归难度,这不同于现有的 2D Denoising 方法(如 DN-DETR, 通常同等对待的2D query)。难度差异来自于 query 匹配密度和误差传播。一方面,与远处物体相对应的 query 匹配度低于近处物体。另一方面,在 3D adaptive query 中引入二维先验时,2D 物体框的微小误差会被放大,更不用说这种影响会随着物体距离的增加而增大。因此,GT 框附近的一些 query 可被视为 positive query,而其他有明显偏差则应被视为 negative query。本文提出一种 3D Denoising 方法,旨在优化那些正样本,并直接舍弃负样本。

具体而言,作者通过同时添加正样本和负样本组来构建基于 GT 的嘈杂查询。对于这两种类型,都会根据物体的位置和大小应用随机噪声,以促进远距离感知中的去噪学习。具体来说,正样本是在3D框内的随机点,而负样本则在GT上施加更大的偏移,偏移范围随着物体的距离变化。这种方法可以在训练过程中模拟有噪声的候选正样本和误报样本

实验结果

Far3D 在 150m 感知范围的 Argoverse 2 上取得了最高的性能。并且模型 scale up 之后,可以达到几个 Lidar-based 方法的性能,展现了纯视觉方法的潜力。

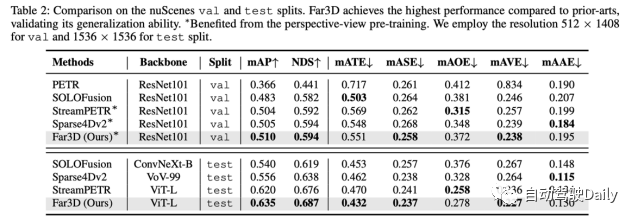

为了验证泛化性能,作者也在 nuScenes 数据集上做了实验,表明其在验证集和测试集上都达到 SoTA 性能。

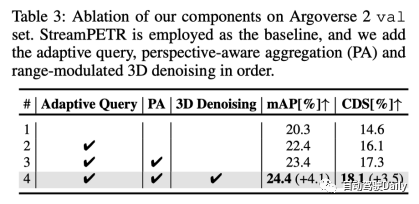

经过消融实验,我们得出了以下结论:3D自适应查询、透视感知聚合和范围调节的3D降噪各自都具有一定的增益

论文思考

Q:这篇文章有什么 novelty?

A:主要 novelty 是解决远距离场景的感知问题。现有方法拓展到远距离场景有许多问题,计算成本和收敛困难等。本文作者为这个任务提出了一个高效的框架。尽管单拎出来各个模块似曾相识,它们都是服务于远处目标的检测的,目标明确。

Q:相比 BevFormer v2, MV2D 有什么区别?

A: MV2D 主要是依赖 2D anchor 去取对应的特征对 3D 进行了绑定,但是没有显式的深度估计,所以对于远距离物体来说不确定性就会比较大,然后难收敛;BevFormer v2 主要解决的是2D backbone与 3D 任务场景之间的domain gap,一般 2D 识别任务上预训练的 backbone 察觉 3D 场景的能力存在不足,并没有探索远距离任务中的问题。

Q: 时序上能否改进,如 query propagation 再加上 feature propagation?

A: 理论上是可行的,但是实际应用中应该考虑performance-efficiency tradeoff。

Q: 还有哪些需要改进的地方?

A: 在长尾问题和远距离评测指标上都值得改进。在 Argoverse 2 这样的 26 类目标上,模型在长尾类别上表现不佳,最终也会降低平均精度,这一点尚未被探索。另一方面,使用统一的指标来评估远距离和近距离物体可能并不合适,这就强调了对实用的动态评估标准的需求,以适应现实世界的不同场景。

原文链接:https://mp.weixin.qq.com/s/xxaaYQsjuWzMI7PnSmuaWg

以上是AAAI2024:Far3D - 创新的直接干到150m视觉3D目标检测思路的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

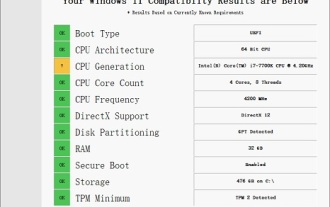

i7-7700无法升级至Windows 11的解决方案

Dec 26, 2023 pm 06:52 PM

i7-7700无法升级至Windows 11的解决方案

Dec 26, 2023 pm 06:52 PM

i77700的性能运行win11完全足够,但是用户却发现自己的i77700不能升级win11,这主要是受到了微软硬性条件的限制,所以只要跳过该限制就能安装了。i77700不能升级win11:1、因为微软限制了cpu的版本。2、intel只有第八代及以上版本可以直升win11。3、而i77700作为7代,无法满足win11的升级需求。4、但是i77700在性能上是完全能流畅使用win11的。5、所以大家可以使用本站的win11直装系统。6、下载完成后,右键“装载”该文件。7、再双击运行其中的“一键

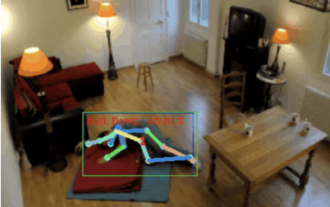

摔倒检测,基于骨骼点人体动作识别,部分代码用 Chatgpt 完成

Apr 12, 2023 am 08:19 AM

摔倒检测,基于骨骼点人体动作识别,部分代码用 Chatgpt 完成

Apr 12, 2023 am 08:19 AM

哈喽,大家好。今天给大家分享一个摔倒检测项目,准确地说是基于骨骼点的人体动作识别。大概分为三个步骤识别人体识别人体骨骼点动作分类项目源码已经打包好了,获取方式见文末。0. chatgpt首先,我们需要获取监控的视频流。这段代码比较固定,我们可以直接让chatgpt完成chatgpt写的这段代码是没有问题的,可以直接使用。但后面涉及到业务型任务,比如:用mediapipe识别人体骨骼点,chatgpt给出的代码是不对的。我觉得chatgpt可以作为一个工具箱,能独立于业务逻辑,都可以试着交给c

超越ORB-SLAM3!SL-SLAM:低光、严重抖动和弱纹理场景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3!SL-SLAM:低光、严重抖动和弱纹理场景全搞定

May 30, 2024 am 09:35 AM

写在前面今天我们探讨下深度学习技术如何改善在复杂环境中基于视觉的SLAM(同时定位与地图构建)性能。通过将深度特征提取和深度匹配方法相结合,这里介绍了一种多功能的混合视觉SLAM系统,旨在提高在诸如低光条件、动态光照、弱纹理区域和严重抖动等挑战性场景中的适应性。我们的系统支持多种模式,包括拓展单目、立体、单目-惯性以及立体-惯性配置。除此之外,还分析了如何将视觉SLAM与深度学习方法相结合,以启发其他研究。通过在公共数据集和自采样数据上的广泛实验,展示了SL-SLAM在定位精度和跟踪鲁棒性方面优

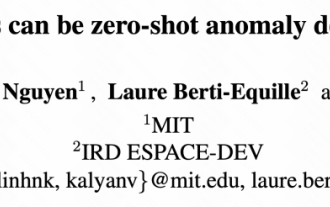

MIT最新力作:用GPT-3.5解决时间序列异常检测问题

Jun 08, 2024 pm 06:09 PM

MIT最新力作:用GPT-3.5解决时间序列异常检测问题

Jun 08, 2024 pm 06:09 PM

今天给大家介绍一篇MIT上周发表的文章,使用GPT-3.5-turbo解决时间序列异常检测问题,初步验证了LLM在时间序列异常检测中的有效性。整个过程没有进行finetune,直接使用GPT-3.5-turbo进行异常检测,文中的核心是如何将时间序列转换成GPT-3.5-turbo可识别的输入,以及如何设计prompt或者pipeline让LLM解决异常检测任务。下面给大家详细介绍一下这篇工作。图片论文标题:Largelanguagemodelscanbezero-shotanomalydete

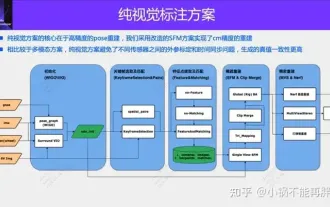

自动驾驶第一性之纯视觉静态重建

Jun 02, 2024 pm 03:24 PM

自动驾驶第一性之纯视觉静态重建

Jun 02, 2024 pm 03:24 PM

纯视觉的标注方案,主要是利用视觉加上一些GPS、IMU和轮速传感器的数据进行动态标注。当然面向量产场景的话,不一定非要是纯视觉,有一些量产的车辆里面,会有像固态雷达(AT128)这样的传感器。如果从量产的角度做数据闭环,把这些传感器都用上,可以有效地解决动态物体的标注问题。但是我们的方案里面,是没有固态雷达的。所以,我们就介绍这种最通用的量产标注方案。纯视觉的标注方案的核心在于高精度的pose重建。我们采用StructurefromMotion(SFM)的pose重建方案,来保证重建精度。但是传

NeRF是什么?基于NeRF的三维重建是基于体素吗?

Oct 16, 2023 am 11:33 AM

NeRF是什么?基于NeRF的三维重建是基于体素吗?

Oct 16, 2023 am 11:33 AM

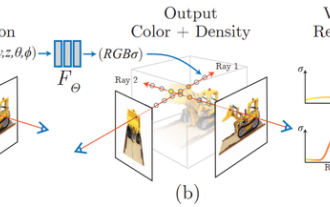

1介绍神经辐射场(NeRF)是深度学习和计算机视觉领域的一个相当新的范式。ECCV2020论文《NeRF:将场景表示为视图合成的神经辐射场》(该论文获得了最佳论文奖)中介绍了这项技术,该技术自此大受欢迎,迄今已获得近800次引用[1]。该方法标志着机器学习处理3D数据的传统方式发生了巨大变化。神经辐射场场景表示和可微分渲染过程:通过沿着相机射线采样5D坐标(位置和观看方向)来合成图像;将这些位置输入MLP以产生颜色和体积密度;并使用体积渲染技术将这些值合成图像;该渲染函数是可微分的,因此可以通过

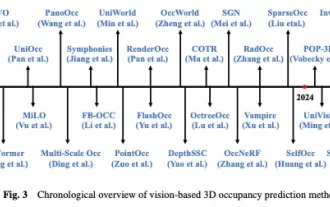

一览Occ与自动驾驶的前世今生!首篇综述全面汇总特征增强/量产部署/高效标注三大主题

May 08, 2024 am 11:40 AM

一览Occ与自动驾驶的前世今生!首篇综述全面汇总特征增强/量产部署/高效标注三大主题

May 08, 2024 am 11:40 AM

写在前面&笔者的个人理解近年来,自动驾驶因其在减轻驾驶员负担和提高驾驶安全方面的潜力而越来越受到关注。基于视觉的三维占用预测是一种新兴的感知任务,适用于具有成本效益且对自动驾驶安全全面调查的任务。尽管许多研究已经证明,与基于物体为中心的感知任务相比,3D占用预测工具具有更大的优势,但仍存在专门针对这一快速发展领域的综述。本文首先介绍了基于视觉的3D占用预测的背景,并讨论了这一任务中遇到的挑战。接下来,我们从特征增强、部署友好性和标签效率三个方面全面探讨了当前3D占用预测方法的现状和发展趋势。最后

改进的检测算法:用于高分辨率光学遥感图像目标检测

Jun 06, 2024 pm 12:33 PM

改进的检测算法:用于高分辨率光学遥感图像目标检测

Jun 06, 2024 pm 12:33 PM

01前景概要目前,难以在检测效率和检测结果之间取得适当的平衡。我们就研究出了一种用于高分辨率光学遥感图像中目标检测的增强YOLOv5算法,利用多层特征金字塔、多检测头策略和混合注意力模块来提高光学遥感图像的目标检测网络的效果。根据SIMD数据集,新算法的mAP比YOLOv5好2.2%,比YOLOX好8.48%,在检测结果和速度之间实现了更好的平衡。02背景&动机随着远感技术的快速发展,高分辨率光学远感图像已被用于描述地球表面的许多物体,包括飞机、汽车、建筑物等。目标检测在远感图像的解释中