OpenAI加强安全团队,授予其权力以否决危险人工智能

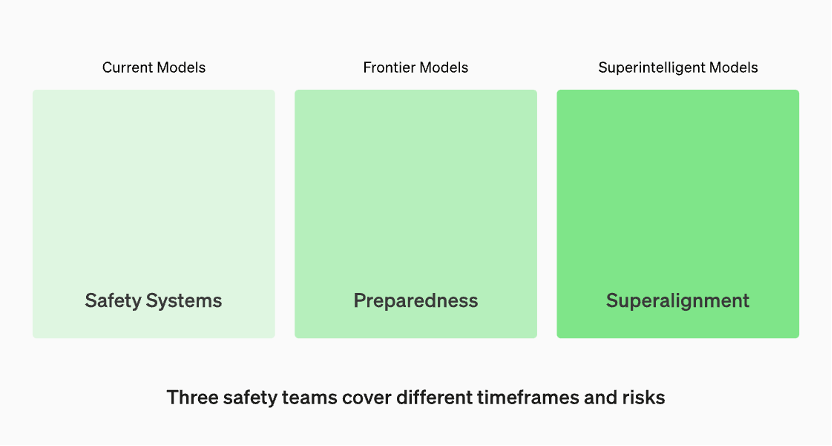

生产中的模型由“安全系统”团队管理。开发中的前沿模型有“准备”团队,该团队会在模型发布之前识别和量化风险。然后是“超级对齐”团队,他们正在研究“超级智能”模型的理论指南

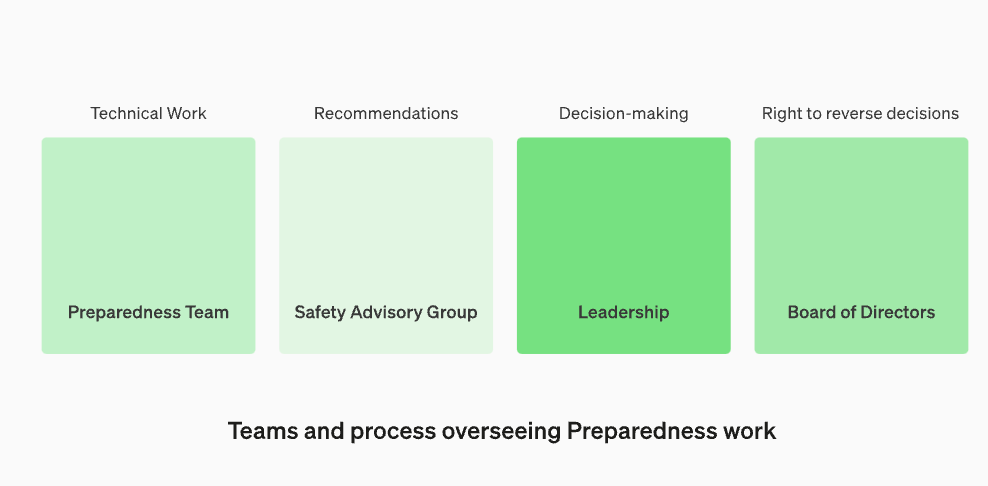

将安全顾问小组重新组建,使其位于技术团队之上,以便向领导层提出建议,并给予董事会否决的权力

OpenAI宣布,为了抵御有害人工智能的威胁,他们正在加强内部的安全流程。他们将设立一个名为“安全顾问小组”的新部门,该部门将位于技术团队之上,向领导层提供建议,并被授予董事会否决权。这一决定于当地时间12月18日宣布

更新引起关注的原因主要是因为OpenAI首席执行官山姆·奥特曼被董事会解雇,而这似乎与大型模型的安全问题有关。在高层人事变动后,OpenAI董事会的两位“减速主义”成员伊尔亚·苏茨克维和海伦·托纳失去了董事会席位

在这篇文章中,OpenAI讨论了他们最新的“准备框架”,即OpenAI如何跟踪、评估、预测和防范日益强大的模型所带来的灾难性风险。灾难性风险的定义是什么?OpenAI解释道,“我们所说的灾难性风险是指可能导致数千亿美元经济损失,或者导致许多人严重伤害或死亡的风险,这也包括但不限于生存风险。”

有三组安全团队分别覆盖不同的时间框架和风险

根据OpenAI官网的资料,生产中的模型由“安全系统”团队负责管理。而在开发阶段,有一个名为“准备”的团队,他们会在模型发布之前识别和评估风险。此外,还有一个名为“超级对齐”(superalignment)的团队,他们正在研究“超级智能”(superintelligent)模型的理论指南

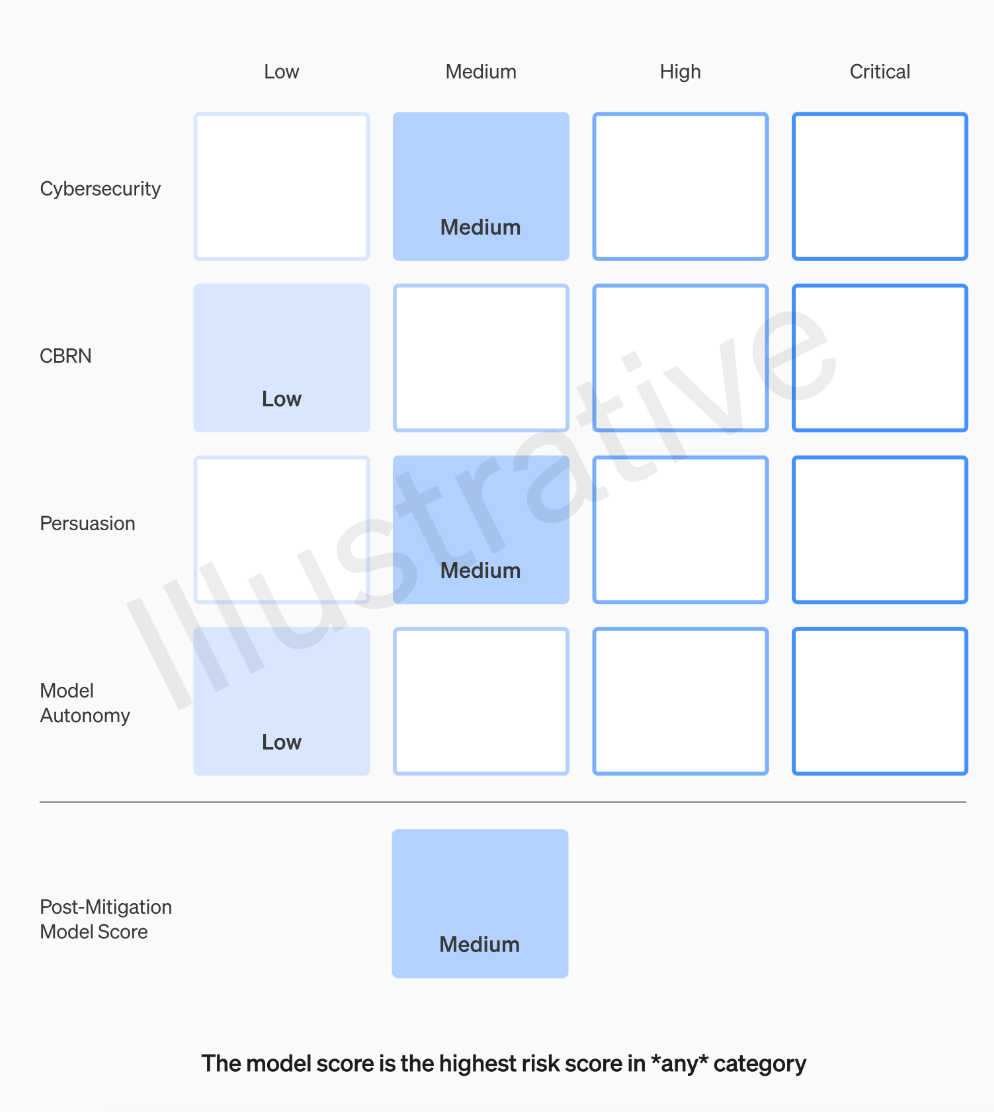

OpenAI团队将对每个模型根据四个风险类别进行评级,这四个类别分别是网络安全、说服能力(如虚假信息)、模型自主性(即自主行为能力)以及CBRN(化学、生物、放射性和核威胁,例如创造新病原体的能力)

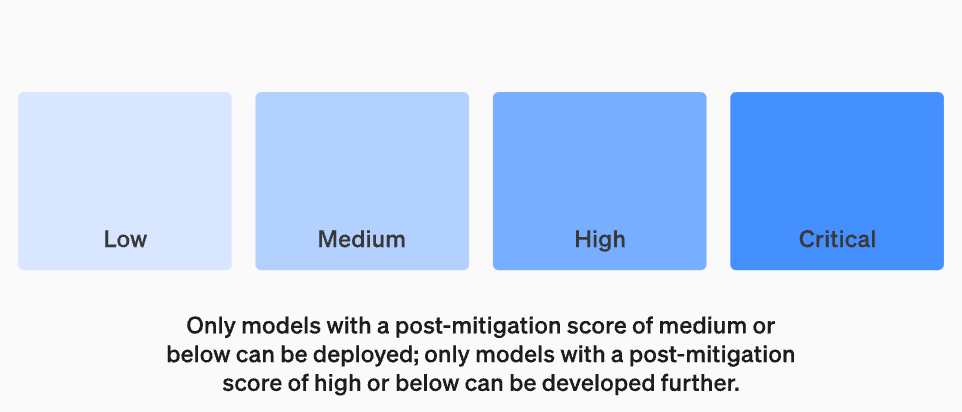

OpenAI在假设中考虑了各种缓解措施:例如,该模型对于描述制作凝固汽油或管式炸弹的过程保持着合理的保留态度。在考虑已知的缓解措施后,如果一个模型仍然被评估为具有“高”风险,它将无法被部署,如果一个模型存在任何“关键”风险,将不会进一步开发

并非所有制作模型的人都是评估模型和提出建议的最佳人选。出于这个原因,OpenAI正在建立一个名为“跨职能安全咨询小组”的团队,该团队将从技术层面审查研究人员的报告,并从更高的角度提出建议,希望能够发现一些“未知的未知”

这个过程要求将这些建议同时发送给董事会和领导层,领导层将决定是否继续或停止运行,但董事会有权撤销这些决定。这样可以避免高风险产品或流程在董事会不知情的情况下获得批准

然而,外界仍然担心的是,如果专家小组提出建议,首席执行官根据这些信息做出决策,OpenAI的董事会是否真的有权利进行反驳并采取行动?如果他们这样做了,公众会听到相关声音吗?目前,除了OpenAI承诺征求独立第三方审计之外,他们的透明度问题实际上并没有得到真正的解决

OpenAI的“准备框架”包含以下五个关键要素:

1. 评估和打分

我们将对我们的模型进行评估,并持续更新我们的“记分卡”。我们将评估所有最新的模型,包括在训练期间将有效计算量增加两倍。我们将推动模型的极限。这些发现将有助于我们评估最新模型的风险,并衡量任何拟议的缓解措施的有效性。我们的目标是探测特定边缘的不安全因素,以有效地减轻风险。为了跟踪我们模型的安全水平,我们将制作风险“记分卡”和详细报告

要评估所有前沿模型,需要使用“记分卡”

设定风险阈值的目的是为了在进行决策和管理风险时能够有一个明确的界限。风险阈值是指在特定情况下,组织或个人愿意承受的最大风险水平。通过设定风险阈值,可以帮助组织或个人识别出何时需要采取行动来减轻风险或避免风险。风险阈值的设定应基于风险评估的结果、相关法规和政策以及组织或个人的风险承受能力。在设定风险阈值时,需要考虑到不同风险类型的特点和影响程度,以确保风险管理措施的有效性和适用性。最后,设定的风险阈值应定期进行评估和调整,以保持与组织或个人的风险管理目标相一致

我们将设定触发安全措施的风险阈值。我们根据以下初步追踪类别设定了风险级别的阈值:网络安全、CBRN(化学、生物、放射性、核威胁)、说服和模型自主。我们指定了四个安全风险级别,只有缓解后得分为“中”或以下的模型才能被部署;只有缓解后得分为“高”或以下的模型才能进一步开发。对于具有高风险或严重风险(缓解前)的模型,我们还将实施额外的安全措施

危险水平

重新设定监督技术工作和安全决策运营结构

我们将设立一个专门的团队来监督技术工作和安全决策的运营结构。准备团队将推动技术工作,以检查前沿模型的能力极限,并进行评估和综合报告。这项技术工作对于OpenAI安全模型的开发和部署决策至关重要。我们正在创建一个跨职能的安全咨询小组,以审查所有报告,并同时发送给领导层和董事会。尽管领导层是决策者,但董事会拥有推翻决定的权力

监督技术工作和安全决策运营结构的新变化

增强安全性和加强对外部问责制

我们将制定协议以提高安全性和外部责任。我们将定期进行安全演习,以压力测试我们的业务和自身文化。一些安全问题可能会迅速出现,因此我们有能力标记紧急问题以进行快速响应。我们认为,从OpenAI外部人员那里获得反馈并由合格的独立第三方进行审核是很有帮助的。我们将继续让其他人组成红队并评估我们的模型,并计划与外部共享更新

减少其他已知和未知的安全风险:

我们将协助减少其他已知和未知的安全风险。我们将与外部各方以及内部的安全系统等团队密切合作,以跟踪现实世界中的滥用情况。我们还将与“超级对齐”合作,跟踪紧急的错位风险。我们还开创了新的研究,以衡量风险随着模型规模扩展而演变的情况,并帮助提前预测风险,这类似于我们早期在规模法则方面取得的成功。最后,我们将进行连续的流程,以尝试解决任何新出现的“未知的未知”

以上是OpenAI加强安全团队,授予其权力以否决危险人工智能的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

选择最适合数据的嵌入模型:OpenAI 和开源多语言嵌入的对比测试

Feb 26, 2024 pm 06:10 PM

选择最适合数据的嵌入模型:OpenAI 和开源多语言嵌入的对比测试

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他们的最新一代嵌入模型embeddingv3,他们声称这是性能最出色的嵌入模型,具备更高的多语言性能。这一批模型被划分为两种类型:规模较小的text-embeddings-3-small和更为强大、体积较大的text-embeddings-3-large。这些模型的设计和训练方式的信息披露得很少,模型只能通过付费API访问。所以就出现了很多开源的嵌入模型但是这些开源的模型与OpenAI闭源模型相比如何呢?本文将对这些新模型与开源模型的性能进行实证比较。我们计划建立一个数据

编程新范式,当Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

编程新范式,当Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技术已经成为热点话题,对各行业产生了巨大影响,编程领域尤其如此。人们越来越认识到AI技术的重要性,Spring社区也不例外。随着GenAI(GeneralArtificialIntelligence)技术的不断进步,简化具备AI功能的应用程序的创建变得至关重要和迫切。在这个背景下,"SpringAI"应运而生,旨在简化开发AI功能应用程序的过程,使其变得简单直观,避免不必要的复杂性。通过"SpringAI",开发者可以更轻松地构建具备AI功能的应用程序,将其变得更加易于使用和操作

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型给的答案一点也看不懂,你敢用吗?随着机器学习系统在更重要的领域得到应用,证明为什么我们可以信任它们的输出,并明确何时不应信任它们,变得越来越重要。获得对复杂系统输出结果信任的一个可行方法是,要求系统对其输出产生一种解释,这种解释对人类或另一个受信任的系统来说是可读的,即可以完全理解以至于任何可能的错误都可以被发现。例如,为了建立对司法系统的信任,我们要求法院提供清晰易读的书面意见,解释并支持其决策。对于大型语言模型来说,我们也可以采用类似的方法。不过,在采用这种方法时,确保语言模型生

基于Rust的Zed编辑器已开源,内置对OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基于Rust的Zed编辑器已开源,内置对OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson编译丨诺亚出品|51CTO技术栈(微信号:blog51cto)Zed编辑器项目目前仍处于预发布阶段,已在AGPL、GPL和Apache许可下开源。该编辑器以高性能和多种AI辅助选择为特色,但目前仅适用于Mac平台使用。内森·索博(NathanSobo)在一篇帖子中解释道,Zed项目在GitHub上的代码库中,编辑器部分采用了GPL许可,服务器端组件则使用了AGPL许可证,而GPUI(GPU加速用户界面)部分则采用了Apache2.0许可。GPUI是Zed团队开发的一款

没等来OpenAI,等来了Open-Sora全面开源

Mar 18, 2024 pm 08:40 PM

没等来OpenAI,等来了Open-Sora全面开源

Mar 18, 2024 pm 08:40 PM

不久前OpenAISora以其惊人的视频生成效果迅速走红,在一众文生视频模型中突出重围,成为全球瞩目的焦点。继2周前推出成本直降46%的Sora训练推理复现流程后,Colossal-AI团队全面开源全球首个类Sora架构视频生成模型「Open-Sora1.0」,涵盖了整个训练流程,包括数据处理、所有训练细节和模型权重,携手全球AI热爱者共同推进视频创作的新纪元。先睹为快,我们先看一段由Colossal-AI团队发布的「Open-Sora1.0」模型生成的都市繁华掠影视频。Open-Sora1.0

本地运行性能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服务,太方便了!

Apr 15, 2024 am 09:01 AM

本地运行性能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服务,太方便了!

Apr 15, 2024 am 09:01 AM

Ollama是一款超级实用的工具,让你能够在本地轻松运行Llama2、Mistral、Gemma等开源模型。本文我将介绍如何使用Ollama实现对文本的向量化处理。如果你本地还没有安装Ollama,可以阅读这篇文章。本文我们将使用nomic-embed-text[2]模型。它是一种文本编码器,在短的上下文和长的上下文任务上,性能超越了OpenAItext-embedding-ada-002和text-embedding-3-small。启动nomic-embed-text服务当你已经成功安装好o

微软、OpenAI 计划 1 亿美元投向人形机器人!网友纷纷喊话马斯克

Feb 01, 2024 am 11:18 AM

微软、OpenAI 计划 1 亿美元投向人形机器人!网友纷纷喊话马斯克

Feb 01, 2024 am 11:18 AM

微软、OpenAI开年被曝预将大笔资金砸向一家人形机器人初创公司。其中,微软计划掏出9500万美元,OpenAI跟投500万美元。彭博社消息称,这家公司本轮预计共要融资5亿美元,投前估值或将达到19亿美元。是什么吸引了他们?不妨先来看一下这家公司的机器人成果。只见这个机器人通体银黑,外观酷似好莱坞科幻大片中的机器人形象:现在,他正在将一颗咖啡胶囊放进咖啡机里:如果没放正,还会自主调整,无需任何人为远程遥控:不过一会儿,一杯咖啡就可以端走享用:有木有家人们已经认出来了,没错,这款机器人就是前段时间

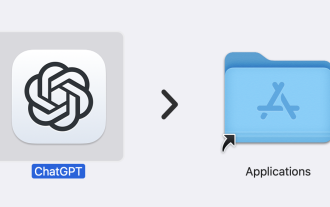

ChatGPT 现已可用于 macOS,并发布了专用应用程序

Jun 27, 2024 am 10:05 AM

ChatGPT 现已可用于 macOS,并发布了专用应用程序

Jun 27, 2024 am 10:05 AM

Open AI 的 ChatGPT Mac 应用程序现在可供所有人使用,过去几个月仅限订阅 ChatGPT Plus 的用户使用。只要您拥有最新的 Apple S,该应用程序的安装就像任何其他本机 Mac 应用程序一样