Transformer模型降维减少,移除90%以上特定层的组件时,LLM性能保持不变

在大型模型时代,Transformer独自支撑起了整个科研领域。自从发布以来,基于Transformer的语言模型在各种任务上展现出了出色的性能,在自然语言建模和推理方面的底层Transformer架构已经成为最先进的技术,在计算机视觉和强化学习等领域也显示出了强大的前景

当前的 Transformer 架构非常庞大,通常需要大量的计算资源来进行训练和推理

这是有意为之的,因为经过更多参数或数据训练的 Transformer 显然比其他模型更有能力。尽管如此,越来越多的工作表明,基于 Transformer 的模型以及神经网络不需要所有拟合参数来保留其学到的假设。

一般来说,在训练模型时大规模过度参数化似乎有帮助,但这些模型在推理之前可以进行大幅剪枝;研究表明,神经网络通常可以去除90%以上的权重,而性能不会有明显下降。这种现象促使研究者开始转向研究有助于模型推理的剪枝策略

来自麻省理工学院和微软的研究人员在一篇名为《真相就在其中:通过层选择性排名减少提高语言模型的推理能力》的论文中提出了一个令人惊讶的发现。他们发现,在Transformer模型的特定层进行精细的剪枝可以显著提高模型在某些任务上的性能

- 论文地址:https://arxiv.org/pdf/2312.13558.pdf

- 论文主页:https://pratyushasharma.github.io/laser/

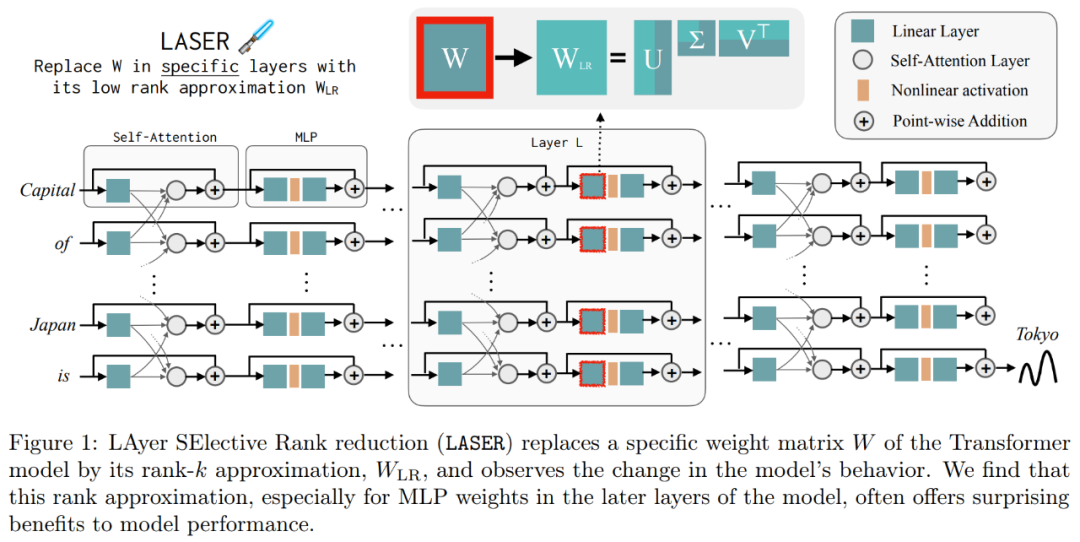

研究中将这种简单的干预措施称为LASER(LAyer SElective Rank reduction,层选择性降秩)。它通过奇异值分解有选择地减少Transformer模型中特定层的学习权重矩阵的高阶分量,从而显著提高LLM的性能。这种操作可以在模型训练完成后进行,而且无需额外的参数或数据

在操作过程中,权重的减少是通过对模型特定的权重矩阵和层进行执行的。研究还发现,许多类似的矩阵都能够显著地减少权重,并且在删除超过90%的组件之前,通常不会观察到性能下降

研究还发现,减少这些因素可以显著提高准确率。有趣的是,这一发现不仅适用于自然语言,对于强化学习也能提升性能

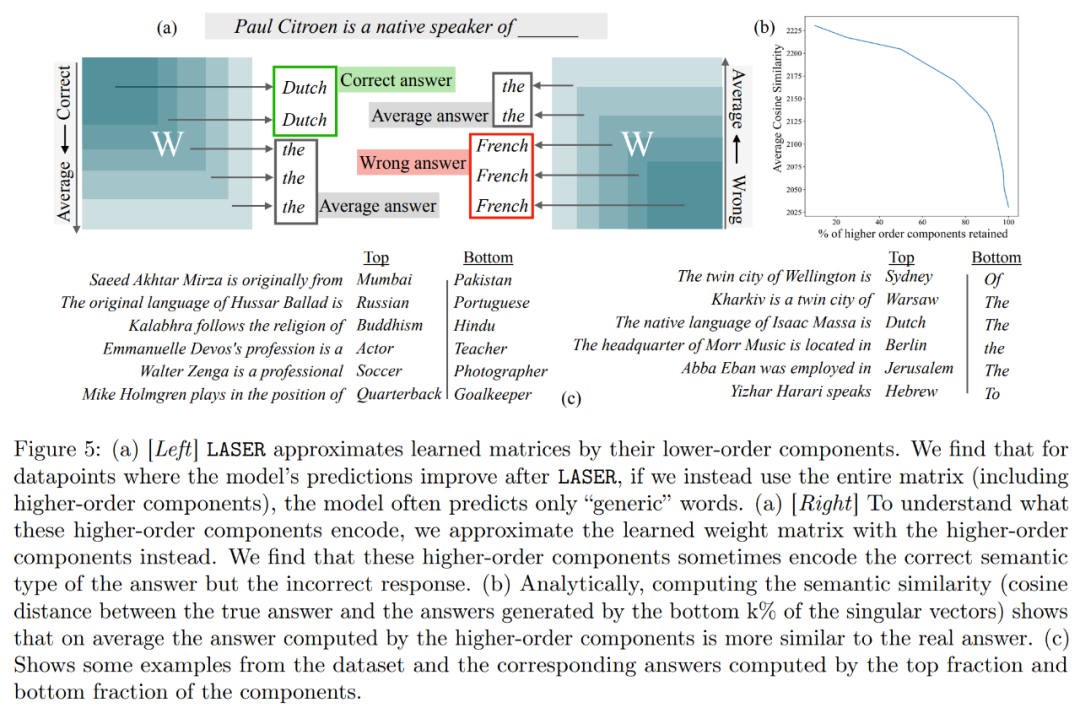

此外,这项研究试图推断出存储在高阶组件中的内容,以便通过删除来提高性能。研究发现,在使用LASER回答问题之后,原始模型主要使用高频词(如“the”、“of”等)作出回应。这些词与正确答案的语义类型甚至不相符,也就是说在没有干预的情况下,这些成分会导致模型生成一些不相关的高频词汇

然而,通过进行一定程度的降秩后,模型的回答可以转变为正确的。

为了理解这一点,该研究还探索了其余组件各自编码的内容,他们仅使用其高阶奇异向量来近似权重矩阵。结果发现这些组件描述了与正确答案相同语义类别的不同响应或通用高频词。

这些结果表明,当嘈杂的高阶分量与低阶分量组合时,它们相互冲突的响应会产生一种平均答案,这可能是不正确的。图 1 直观地展示了 Transformer 架构和 LASER 遵循的程序。在这里,特定层的多层感知器(MLP)的权重矩阵被替换为其低秩近似。

LASER 概览

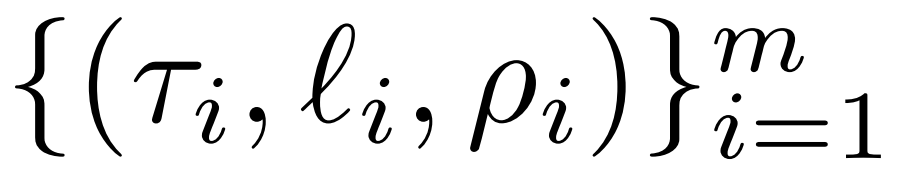

研究者对LASER干预进行了详细介绍。单步LASER干预是通过三个参数(τ、ℓ和ρ)来定义的。这些参数共同描述了要被低秩近似替代的矩阵以及近似的程度。研究者根据参数类型对待干预的矩阵进行分类

研究者关注的重点是矩阵 W = {W_q, W_k, W_v, W_o, U_in, U_out},该矩阵由多层感知机(MLP)和注意力层中的矩阵组成。层数表示研究者干预的层级,其中第一层的索引是0。例如,Llama-2有32个层级,因此表示为 ℓ ∈ {0, 1, 2,・・・31}

最终,ρ ∈ [0, 1) 描述了在做低秩近似时应该保留最大秩的哪一部分。例如设 ,则该矩阵的最大秩为 d。研究者将它替换为⌊ρ・d⌋- 近似。

,则该矩阵的最大秩为 d。研究者将它替换为⌊ρ・d⌋- 近似。

以下是需要 在下图1中,展示了一个LASER的示例。图中的符号τ = U_in和ℓ = L表示在第L层的Transformer块中更新MLP的第一层权重矩阵。还有一个参数用于控制rank-k近似中的k值

LASER 可以限制网络中某些信息的流动,并出乎意料地产生显着的性能优势。这些干预也可以很容易组合起来,比如以任何顺序来应用一组干预 。

。

LASER 方法只是对这类干预进行简单的搜索,并修改以带来最大收益。不过,还有很多其他方法可以将这些干预组合起来,这是研究者未来工作的方向。

实验结果

在实验部分,研究者使用了在 PILE 数据集上预训练的 GPT-J 模型,该模型的层数为 27,参数为 60 亿。然后在 CounterFact 数据集上评估模型的行为,该数据集包含(主题、关系和答案)三元组的样本,每个问题提供了三个释义 prompt。

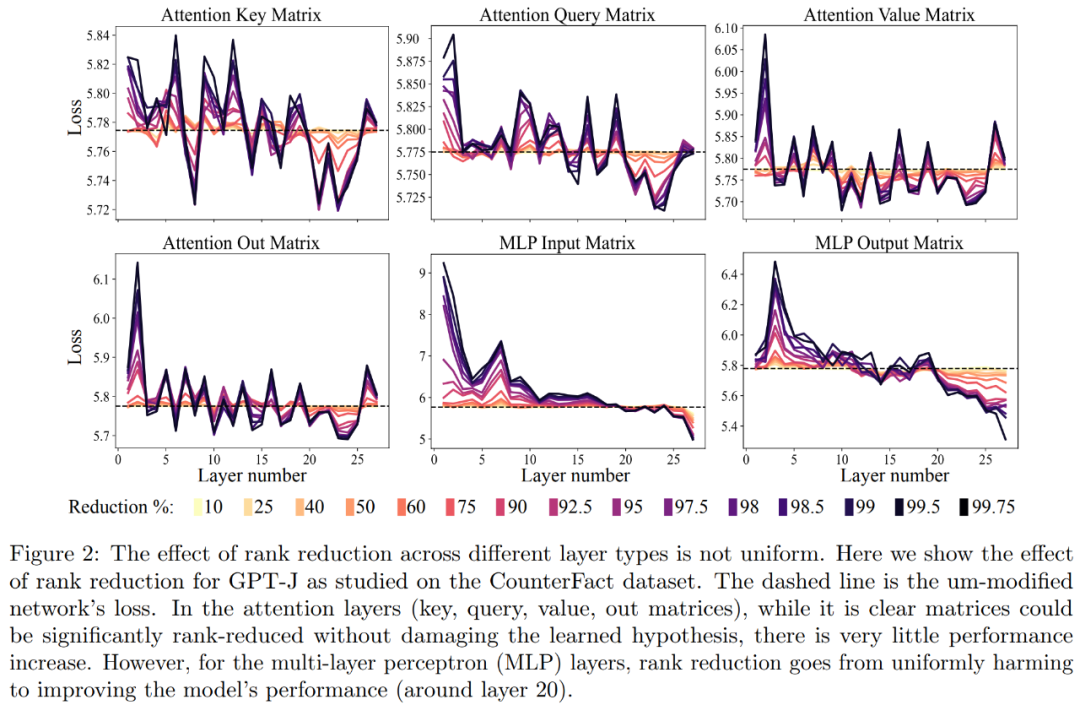

首先,我们对 GPT-J 模型在 CounterFact 数据集上进行了分析。图 2 展示了在 Transformer 架构中,将不同数量的降秩应用于每个矩阵后,对数据集分类损失的影响。每个 Transformer 层由一个两层的小型 MLP 组成,输入和输出矩阵分别显示。不同颜色表示移除组件的不同百分比

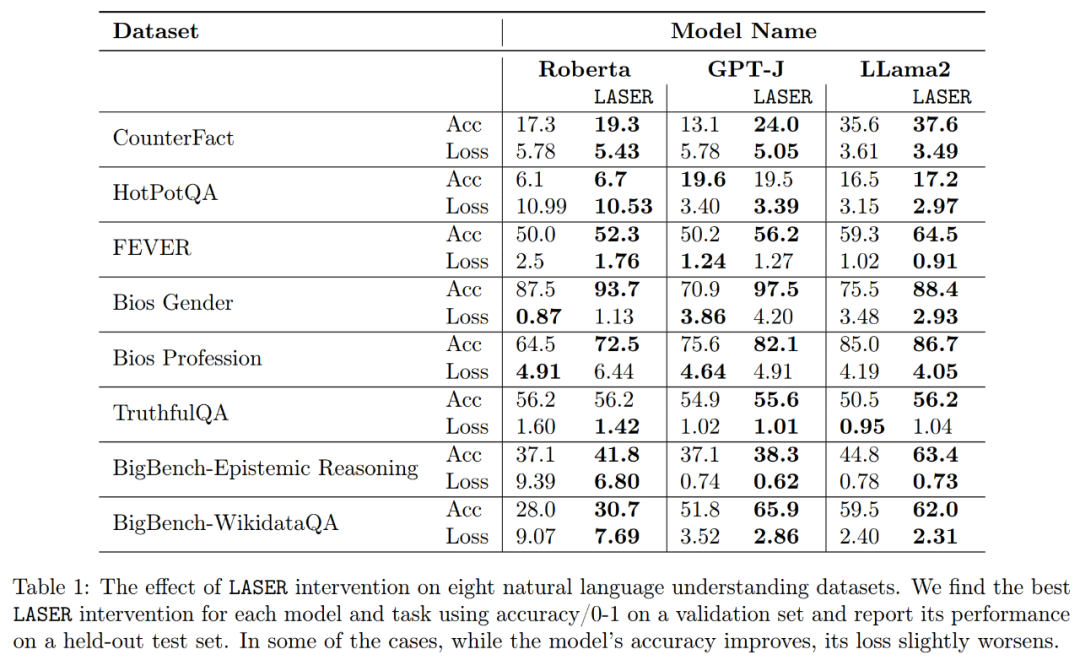

关于提升释义的准确度和稳健性,如上图2 和下表1 所示,研究者发现,当在单层上进行降秩时, GPT-J 模型在CounterFact 数据集上的事实准确度从13.1% 增加到了24.0%。需要注意一点,这些改进只是降秩的结果,并不涉及对模型的任何进一步训练或微调。

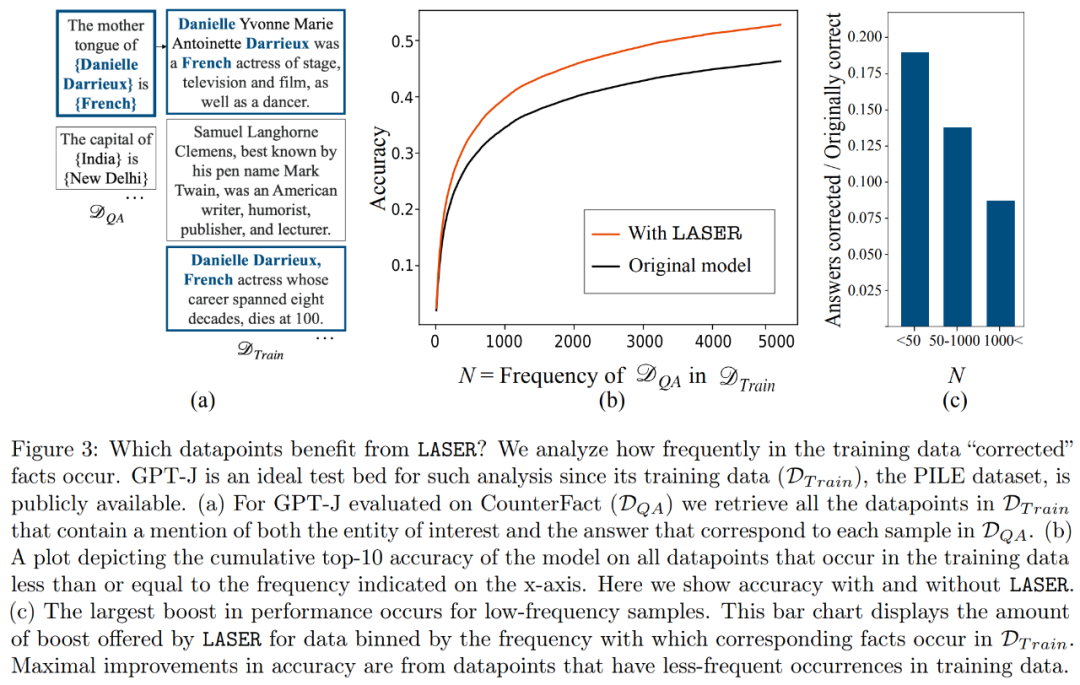

哪些事实在进行降秩恢复时会得到恢复?研究者发现,通过降秩恢复得到的事实很可能在数据集中出现的次数非常少,如图3所示

高阶组件存储什么呢?研究者使用高阶组件近似最终的权重矩阵(而不像 LASER 那样使用低阶组件来近似),如下图 5 (a) 所示。当使用不同数量的高阶组件来近似矩阵时,他们测量了真实答案相对于预测答案的平均余弦相似度,如下图 5 (b) 所示。

研究者最终对他们发现的三种不同的LLM在多项语言理解任务上的普适性进行了评估。对于每个任务,他们使用生成准确度、分类准确度和损失三个指标来评估模型的性能。根据表1的结果显示,即使矩阵的秩降低很大,也不会导致模型准确度下降,反而能提升模型的性能

以上是Transformer模型降维减少,移除90%以上特定层的组件时,LLM性能保持不变的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接内存访问技术,允许硬件设备直接与内存进行数据传输,不需要CPU干预。1)DMA操作高度依赖于硬件设备和驱动程序,实现方式因系统而异。2)直接访问内存可能带来安全风险,需确保代码的正确性和安全性。3)DMA可提高性能,但使用不当可能导致系统性能下降。通过实践和学习,可以掌握DMA的使用技巧,在高速数据传输和实时信号处理等场景中发挥其最大效能。

C 中的chrono库如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono库如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono库可以让你更加精确地控制时间和时间间隔,让我们来探讨一下这个库的魅力所在吧。C 的chrono库是标准库的一部分,它提供了一种现代化的方式来处理时间和时间间隔。对于那些曾经饱受time.h和ctime折磨的程序员来说,chrono无疑是一个福音。它不仅提高了代码的可读性和可维护性,还提供了更高的精度和灵活性。让我们从基础开始,chrono库主要包括以下几个关键组件:std::chrono::system_clock:表示系统时钟,用于获取当前时间。std::chron

怎样在C 中处理高DPI显示?

Apr 28, 2025 pm 09:57 PM

怎样在C 中处理高DPI显示?

Apr 28, 2025 pm 09:57 PM

在C 中处理高DPI显示可以通过以下步骤实现:1)理解DPI和缩放,使用操作系统API获取DPI信息并调整图形输出;2)处理跨平台兼容性,使用如SDL或Qt的跨平台图形库;3)进行性能优化,通过缓存、硬件加速和动态调整细节级别来提升性能;4)解决常见问题,如模糊文本和界面元素过小,通过正确应用DPI缩放来解决。

C 中的实时操作系统编程是什么?

Apr 28, 2025 pm 10:15 PM

C 中的实时操作系统编程是什么?

Apr 28, 2025 pm 10:15 PM

C 在实时操作系统(RTOS)编程中表现出色,提供了高效的执行效率和精确的时间管理。1)C 通过直接操作硬件资源和高效的内存管理满足RTOS的需求。2)利用面向对象特性,C 可以设计灵活的任务调度系统。3)C 支持高效的中断处理,但需避免动态内存分配和异常处理以保证实时性。4)模板编程和内联函数有助于性能优化。5)实际应用中,C 可用于实现高效的日志系统。

量化交易所排行榜2025 数字货币量化交易APP前十名推荐

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 数字货币量化交易APP前十名推荐

Apr 30, 2025 pm 07:24 PM

交易所内置量化工具包括:1. Binance(币安):提供Binance Futures量化模块,低手续费,支持AI辅助交易。2. OKX(欧易):支持多账户管理和智能订单路由,提供机构级风控。独立量化策略平台有:3. 3Commas:拖拽式策略生成器,适用于多平台对冲套利。4. Quadency:专业级算法策略库,支持自定义风险阈值。5. Pionex:内置16 预设策略,低交易手续费。垂直领域工具包括:6. Cryptohopper:云端量化平台,支持150 技术指标。7. Bitsgap:

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中使用字符串流的主要步骤和注意事项如下:1.创建输出字符串流并转换数据,如将整数转换为字符串。2.应用于复杂数据结构的序列化,如将vector转换为字符串。3.注意性能问题,避免在处理大量数据时频繁使用字符串流,可考虑使用std::string的append方法。4.注意内存管理,避免频繁创建和销毁字符串流对象,可以重用或使用std::stringstream。

怎样在C 中测量线程性能?

Apr 28, 2025 pm 10:21 PM

怎样在C 中测量线程性能?

Apr 28, 2025 pm 10:21 PM

在C 中测量线程性能可以使用标准库中的计时工具、性能分析工具和自定义计时器。1.使用库测量执行时间。2.使用gprof进行性能分析,步骤包括编译时添加-pg选项、运行程序生成gmon.out文件、生成性能报告。3.使用Valgrind的Callgrind模块进行更详细的分析,步骤包括运行程序生成callgrind.out文件、使用kcachegrind查看结果。4.自定义计时器可灵活测量特定代码段的执行时间。这些方法帮助全面了解线程性能,并优化代码。

MySQL批量插入数据的高效方法

Apr 29, 2025 pm 04:18 PM

MySQL批量插入数据的高效方法

Apr 29, 2025 pm 04:18 PM

MySQL批量插入数据的高效方法包括:1.使用INSERTINTO...VALUES语法,2.利用LOADDATAINFILE命令,3.使用事务处理,4.调整批量大小,5.禁用索引,6.使用INSERTIGNORE或INSERT...ONDUPLICATEKEYUPDATE,这些方法能显着提升数据库操作效率。