提升Pytorch关键点,改进优化器!

嗨,我是小壮!

今儿咱们聊聊Pytorch中的优化器。

优化器的选择对深度学习模型的训练效果和速度有直接影响。不同的优化器适用于不同的问题,它们的性能差异可能导致模型更快、更稳定地收敛,或者在特定任务上表现更好。因此,在选择优化器时,需要根据具体问题的特点来进行权衡和决策。

因此,选择正确的优化器对于调优深度学习模型至关重要。优化器的选择不仅会显着影响模型的性能,还会影响训练过程的效率。

PyTorch提供了多种优化器,可用于训练神经网络并更新模型权重。这些优化器包括常见的SGD、Adam、RMSprop等,每个优化器都有其独特的特点和适用场景。选择合适的优化器可以加速模型收敛,提高训练效果。在使用优化器时,需要设置学习率、权重衰减等超参数,以及定义损失函数和模型参数。

常见优化器

让我们首先罗列一些PyTorch中常用的优化器,并对其进行简单的介绍:

让我们一起来了解一下SGD(随机梯度下降)的工作原理吧。 SGD是一种常用的优化算法,用于求解机器学习模型的参数。它通过随机选择一小批样本来估计梯度,并使用梯度的负方向来更新参数。这样可以在迭代过程中逐渐优化模型的性能。 SGD的优势是计算效率高,尤其适用于

随机梯度下降是一种常用的优化算法,用于最小化损失函数。它通过计算权重相对于损失函数的梯度,并朝着梯度的负方向更新权重。这种算法在机器学习和深度学习中广泛应用。

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate)

(2) Adam

Adam是一种自适应学习率的优化算法,它结合了AdaGrad和RMSProp的思想。相比于传统的梯度下降算法,Adam能够为每个参数计算不同的学习率,从而更好地适应不同参数的特性。通过自适应调整学习率,Adam可以提高模型的收敛速度和性能。

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

(3) Adagrad

Adagrad是一种自适应学习率的优化算法,根据参数的历史梯度调整学习率。但由于学习率逐渐减小,可能导致训练过早停止。

optimizer = torch.optim.Adagrad(model.parameters(), lr=learning_rate)

(4) RMSProp

RMSProp也是一种自适应学习率的算法,通过考虑梯度的滑动平均来调整学习率。

optimizer = torch.optim.RMSprop(model.parameters(), lr=learning_rate)

(5) Adadelta

Adadelta是一种自适应学习率的优化算法,是RMSProp的改进版本,通过考虑梯度的移动平均和参数的移动平均来动态调整学习率。

optimizer = torch.optim.Adadelta(model.parameters(), lr=learning_rate)

一个完整案例

在这里,咱们聊聊如何使用PyTorch训练一个简单的卷积神经网络(CNN)来进行手写数字识别。

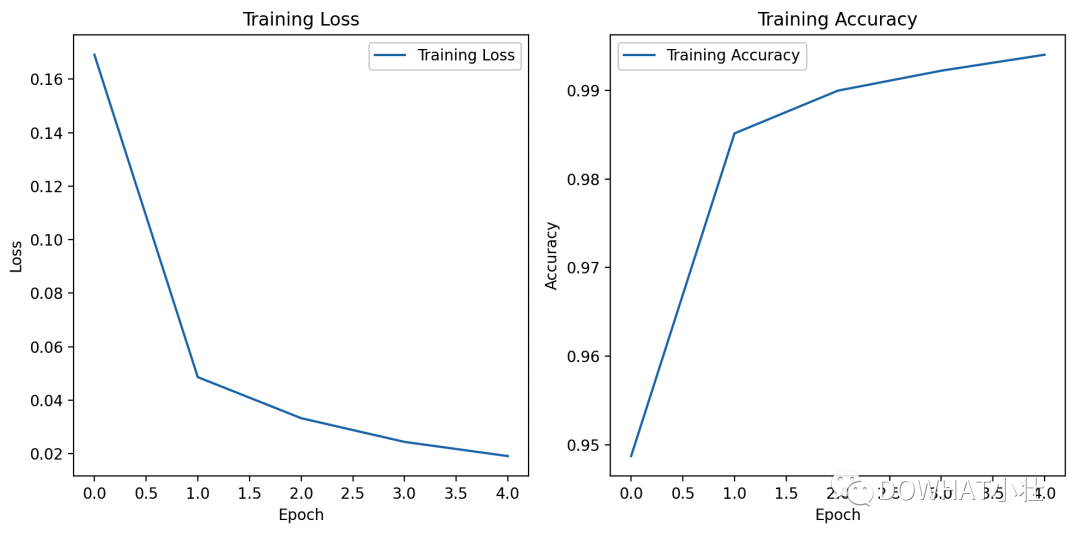

这个案例使用的是MNIST数据集,并使用Matplotlib库绘制了损失曲线和准确率曲线。

import torchimport torch.nn as nnimport torch.optim as optimfrom torchvision import datasets, transformsfrom torch.utils.data import DataLoaderimport matplotlib.pyplot as plt# 设置随机种子torch.manual_seed(42)# 定义数据转换transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])# 下载和加载MNIST数据集train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)test_loader = DataLoader(test_dataset, batch_size=1000, shuffle=False)# 定义简单的卷积神经网络模型class CNN(nn.Module):def __init__(self):super(CNN, self).__init__()self.conv1 = nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1)self.relu = nn.ReLU()self.pool = nn.MaxPool2d(kernel_size=2, stride=2)self.conv2 = nn.Conv2d(32, 64, kernel_size=3, stride=1, padding=1)self.fc1 = nn.Linear(64 * 7 * 7, 128)self.fc2 = nn.Linear(128, 10)def forward(self, x):x = self.conv1(x)x = self.relu(x)x = self.pool(x)x = self.conv2(x)x = self.relu(x)x = self.pool(x)x = x.view(-1, 64 * 7 * 7)x = self.fc1(x)x = self.relu(x)x = self.fc2(x)return x# 创建模型、损失函数和优化器model = CNN()criterion = nn.CrossEntropyLoss()optimizer = optim.Adam(model.parameters(), lr=0.001)# 训练模型num_epochs = 5train_losses = []train_accuracies = []for epoch in range(num_epochs):model.train()total_loss = 0.0correct = 0total = 0for inputs, labels in train_loader:optimizer.zero_grad()outputs = model(inputs)loss = criterion(outputs, labels)loss.backward()optimizer.step()total_loss += loss.item()_, predicted = torch.max(outputs.data, 1)total += labels.size(0)correct += (predicted == labels).sum().item()accuracy = correct / totaltrain_losses.append(total_loss / len(train_loader))train_accuracies.append(accuracy)print(f"Epoch {epoch+1}/{num_epochs}, Loss: {train_losses[-1]:.4f}, Accuracy: {accuracy:.4f}")# 绘制损失曲线和准确率曲线plt.figure(figsize=(10, 5))plt.subplot(1, 2, 1)plt.plot(train_losses, label='Training Loss')plt.title('Training Loss')plt.xlabel('Epoch')plt.ylabel('Loss')plt.legend()plt.subplot(1, 2, 2)plt.plot(train_accuracies, label='Training Accuracy')plt.title('Training Accuracy')plt.xlabel('Epoch')plt.ylabel('Accuracy')plt.legend()plt.tight_layout()plt.show()# 在测试集上评估模型model.eval()correct = 0total = 0with torch.no_grad():for inputs, labels in test_loader:outputs = model(inputs)_, predicted = torch.max(outputs.data, 1)total += labels.size(0)correct += (predicted == labels).sum().item()accuracy = correct / totalprint(f"Accuracy on test set: {accuracy * 100:.2f}%")上述代码中,我们定义了一个简单的卷积神经网络(CNN),使用交叉熵损失和Adam优化器进行训练。

在训练过程中,我们记录了每个epoch的损失和准确率,并使用Matplotlib库绘制了损失曲线和准确率曲线。

我是小壮,下期见!

以上是提升Pytorch关键点,改进优化器!的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

科大讯飞:华为升腾 910B 能力基本可对标英伟达 A100,正合力打造我国通用人工智能新底座

Oct 22, 2023 pm 06:13 PM

科大讯飞:华为升腾 910B 能力基本可对标英伟达 A100,正合力打造我国通用人工智能新底座

Oct 22, 2023 pm 06:13 PM

本站10月22日消息,今年第三季度,科大讯飞实现净利润2579万元,同比下降81.86%;前三季度净利润9936万元,同比下降76.36%。科大讯飞副总裁江涛在Q3业绩说明会上透露,讯飞已于2023年初与华为升腾启动专项攻关,与华为联合研发高性能算子库,合力打造我国通用人工智能新底座,让国产大模型架构在自主创新的软硬件基础之上。他指出,目前华为升腾910B能力已经基本做到可对标英伟达A100。在即将举行的科大讯飞1024全球开发者节上,讯飞和华为在人工智能算力底座上将有进一步联合发布。他还提到,

PyCharm与PyTorch完美结合:安装配置步骤详解

Feb 21, 2024 pm 12:00 PM

PyCharm与PyTorch完美结合:安装配置步骤详解

Feb 21, 2024 pm 12:00 PM

PyCharm是一款强大的集成开发环境(IDE),而PyTorch是深度学习领域备受欢迎的开源框架。在机器学习和深度学习领域,使用PyCharm和PyTorch进行开发可以极大地提高开发效率和代码质量。本文将详细介绍如何在PyCharm中安装配置PyTorch,并附上具体的代码示例,帮助读者更好地利用这两者的强大功能。第一步:安装PyCharm和Python

自然语言生成任务中的五种采样方法介绍和Pytorch代码实现

Feb 20, 2024 am 08:50 AM

自然语言生成任务中的五种采样方法介绍和Pytorch代码实现

Feb 20, 2024 am 08:50 AM

在自然语言生成任务中,采样方法是从生成模型中获得文本输出的一种技术。这篇文章将讨论5种常用方法,并使用PyTorch进行实现。1、GreedyDecoding在贪婪解码中,生成模型根据输入序列逐个时间步地预测输出序列的单词。在每个时间步,模型会计算每个单词的条件概率分布,然后选择具有最高条件概率的单词作为当前时间步的输出。这个单词成为下一个时间步的输入,生成过程会持续直到满足某种终止条件,比如生成了指定长度的序列或者生成了特殊的结束标记。GreedyDecoding的特点是每次选择当前条件概率最

用PyTorch实现噪声去除扩散模型

Jan 14, 2024 pm 10:33 PM

用PyTorch实现噪声去除扩散模型

Jan 14, 2024 pm 10:33 PM

在详细了解去噪扩散概率模型(DDPM)的工作原理之前,我们先来了解一下生成式人工智能的一些发展情况,这也是DDPM的基础研究之一。 VAEVAE使用编码器、概率潜在空间和解码器。在训练过程中,编码器预测每个图像的均值和方差,并从高斯分布中对这些值进行采样。采样的结果传递到解码器中,解码器将输入图像转换为与输出图像相似的形式。 KL散度用于计算损失。 VAE的一个显着优势是其能够生成多样化的图像。在采样阶段,可以直接从高斯分布中采样,并通过解码器生成新的图像。 GAN在变分自编码器(VAEs)的短短一年之

安装PyTorch的PyCharm教程

Feb 24, 2024 am 10:09 AM

安装PyTorch的PyCharm教程

Feb 24, 2024 am 10:09 AM

PyTorch作为一款功能强大的深度学习框架,被广泛应用于各类机器学习项目中。PyCharm作为一款强大的Python集成开发环境,在实现深度学习任务时也能提供很好的支持。本文将详细介绍如何在PyCharm中安装PyTorch,并提供具体的代码示例,帮助读者快速上手使用PyTorch进行深度学习任务。第一步:安装PyCharm首先,我们需要确保已经在计算机上

使用PHP和PyTorch进行深度学习

Jun 19, 2023 pm 02:43 PM

使用PHP和PyTorch进行深度学习

Jun 19, 2023 pm 02:43 PM

深度学习是人工智能领域的一个重要分支,近年来受到了越来越多人的关注和重视。为了能够进行深度学习的研究和应用,往往需要使用到一些深度学习框架来帮助实现。在本文中,我们将介绍如何使用PHP和PyTorch进行深度学习。一、什么是PyTorchPyTorch是一个由Facebook开发的开源机器学习框架,它可以帮助我们快速地创建深度学习模型并进行训练。PyTorc

真快!几分钟就把视频语音识别为文本了,不到10行代码

Feb 27, 2024 pm 01:55 PM

真快!几分钟就把视频语音识别为文本了,不到10行代码

Feb 27, 2024 pm 01:55 PM

大家好,我是风筝两年前,将音视频文件转换为文字内容的需求难以实现,但是如今只需几分钟便可轻松解决。据说一些公司为了获取训练数据,已经对抖音、快手等短视频平台上的视频进行了全面爬取,然后将视频中的音频提取出来转换成文本形式,用作大数据模型的训练语料。如果您需要将视频或音频文件转换为文字,可以尝试今天提供的这个开源解决方案。例如,可以搜索影视节目的对话出现的具体时间点。话不多说,进入正题。Whisper这个方案就是OpenAI开源的Whisper,当然是用Python写的了,只需要简单安装几个包,然

大模型中常用的注意力机制GQA详解以及Pytorch代码实现

Apr 03, 2024 pm 05:40 PM

大模型中常用的注意力机制GQA详解以及Pytorch代码实现

Apr 03, 2024 pm 05:40 PM

组查询注意力(GroupedQueryAttention)是大型语言模型中的一种多查询注意力力方法,它的目标是在保持MQA速度的同时实现MHA的质量。GroupedQueryAttention将查询分组,每个组内的查询共享相同的注意力权重,这有助于降低计算复杂度和提高推理速度。这篇文章中,我们将解释GQA的思想以及如何将其转化为代码。GQA是在论文GQA:TrainingGeneralizedMulti-QueryTransformerModelsfromMulti-HeadCheckpoint