掌握高效的数据爬取技术:构建强大的Java爬虫

掌握高效的数据爬取技术:构建强大的Java爬虫,需要具体代码示例

一、引言

随着互联网的快速发展和数据资源的丰富,越来越多的应用场景需要从网页中抓取数据。而Java作为一门强大的编程语言,自带的网络爬虫开发框架以及丰富的第三方库,使得它成为一个理想的选择。在本文中,我们将介绍如何使用Java构建强大的网络爬虫,并提供具体的代码示例。

二、网络爬虫基础知识

- 什么是网络爬虫?

网络爬虫是一种自动化程序,用于模拟人类在互联网上浏览网页的行为,从网页中抓取所需的数据。爬虫会按照一定规则从网页中提取数据,并将其保存在本地或者进行进一步处理。 - 爬虫的工作原理

爬虫的工作原理大致可以分为以下几个步骤: - 发送HTTP请求获取网页内容。

- 解析页面,提取需要的数据。

- 进行存储或者其他进一步的处理。

三、Java爬虫开发框架

Java有很多开发框架可以用于网络爬虫的开发,下面介绍两个常用的框架。

- Jsoup

Jsoup是一个用于解析、遍历和操作HTML的Java库。它提供了灵活的API和便捷的选择器,使得从HTML中提取数据变得非常简单。下面是一个使用Jsoup进行数据提取的示例代码:

// 导入Jsoup库

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class JsoupExample {

public static void main(String[] args) throws Exception {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com").get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

}- HttpClient

HttpClient是一种Java的HTTP请求库,它可以方便地模拟浏览器发送HTTP请求,并获取服务器的响应。下面是一个使用HttpClient发送HTTP请求的示例代码:

// 导入HttpClient库

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.DefaultHttpClient;

import org.apache.http.util.EntityUtils;

public class HttpClientExample {

public static void main(String[] args) throws Exception {

// 创建HttpClient实例

HttpClient httpClient = new DefaultHttpClient();

// 创建HttpGet请求

HttpGet httpGet = new HttpGet("http://example.com");

// 发送HTTP请求并获取服务器的响应

HttpResponse response = httpClient.execute(httpGet);

// 解析响应,提取需要的数据

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

System.out.println(content);

}

}四、进阶技术

- 多线程

为了提高爬虫的效率,我们可以使用多线程来同时抓取多个网页。下面是一个使用Java多线程实现的爬虫示例代码:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class MultiThreadSpider {

private static final int THREAD_POOL_SIZE = 10;

public static void main(String[] args) throws Exception {

ExecutorService executorService = Executors.newFixedThreadPool(THREAD_POOL_SIZE);

for (int i = 1; i <= 10; i++) {

final int page = i;

executorService.execute(() -> {

try {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com/page=" + page).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

} catch (Exception e) {

e.printStackTrace();

}

});

}

executorService.shutdown();

}

}- 代理IP

为了解决因为爬取频率过高而被服务器封禁IP的问题,我们可以使用代理IP来隐藏真实的IP地址。下面是一个使用代理IP的爬虫示例代码:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.net.InetSocketAddress;

import java.net.Proxy;

public class ProxyIPSpider {

public static void main(String[] args) throws Exception {

// 创建代理IP

Proxy proxy = new Proxy(Proxy.Type.HTTP, new InetSocketAddress("127.0.0.1", 8080));

// 发送HTTP请求并使用代理IP

Document doc = Jsoup.connect("http://example.com").proxy(proxy).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

}五、总结

在本文中,我们介绍了如何使用Java构建强大的网络爬虫,并提供了具体的代码示例。通过学习这些技术,我们可以更加高效地从网页中抓取所需的数据。当然,网络爬虫的使用也需要遵守相关的法律和道德规范,合理使用爬虫工具,保护隐私和他人权益。希望本文对于你学习和使用Java爬虫有所帮助!

以上是掌握高效的数据爬取技术:构建强大的Java爬虫的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3的论文终于来了!这个模型于两周前发布,采用了与Sora相同的DiT(DiffusionTransformer)架构,一经发布就引起了不小的轰动。与之前版本相比,StableDiffusion3生成的图质量有了显着提升,现在支持多主题提示,并且文字书写效果也得到了改善,不再出现乱码情况。 StabilityAI指出,StableDiffusion3是一个系列模型,其参数量从800M到8B不等。这一参数范围意味着该模型可以在许多便携设备上直接运行,从而显着降低了使用AI

自动驾驶与轨迹预测看这一篇就够了!

Feb 28, 2024 pm 07:20 PM

自动驾驶与轨迹预测看这一篇就够了!

Feb 28, 2024 pm 07:20 PM

轨迹预测在自动驾驶中承担着重要的角色,自动驾驶轨迹预测是指通过分析车辆行驶过程中的各种数据,预测车辆未来的行驶轨迹。作为自动驾驶的核心模块,轨迹预测的质量对于下游的规划控制至关重要。轨迹预测任务技术栈丰富,需要熟悉自动驾驶动/静态感知、高精地图、车道线、神经网络架构(CNN&GNN&Transformer)技能等,入门难度很大!很多粉丝期望能够尽快上手轨迹预测,少踩坑,今天就为大家盘点下轨迹预测常见的一些问题和入门学习方法!入门相关知识1.预习的论文有没有切入顺序?A:先看survey,p

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

这篇论文探讨了在自动驾驶中,从不同视角(如透视图和鸟瞰图)准确检测物体的问题,特别是如何有效地从透视图(PV)到鸟瞰图(BEV)空间转换特征,这一转换是通过视觉转换(VT)模块实施的。现有的方法大致分为两种策略:2D到3D和3D到2D转换。2D到3D的方法通过预测深度概率来提升密集的2D特征,但深度预测的固有不确定性,尤其是在远处区域,可能会引入不准确性。而3D到2D的方法通常使用3D查询来采样2D特征,并通过Transformer学习3D和2D特征之间对应关系的注意力权重,这增加了计算和部署的

《我的世界》化身AI小镇,NPC居民角色扮演如同真人

Jan 02, 2024 pm 06:25 PM

《我的世界》化身AI小镇,NPC居民角色扮演如同真人

Jan 02, 2024 pm 06:25 PM

请留意,这个方块人正在紧锁眉头,思考着面前几位“不速之客”的身份。原来她陷入了危险境地,意识到这一点后,她迅速展开脑力搜索,寻找解决问题的策略。最终,她决定先逃离现场,然后尽快寻求帮助,并立即采取行动。与此同时,对面的人也在进行着与她相同的思考……在《我的世界》中出现了这样一个场景,所有的角色都由人工智能控制。他们每个人都有着独特的身份设定,比如之前提到的女孩就是一个年仅17岁但聪明勇敢的快递员。他们拥有记忆和思考能力,在这个以《我的世界》为背景的小镇中像人类一样生活。驱动他们的,是一款全新的、

入门Java爬虫:认识其基本概念和应用方法

Jan 10, 2024 pm 07:42 PM

入门Java爬虫:认识其基本概念和应用方法

Jan 10, 2024 pm 07:42 PM

Java爬虫初探:了解它的基本概念与用途,需要具体代码示例随着互联网的快速发展,获取并处理大量的数据成为企业和个人不可或缺的一项任务。而爬虫(WebScraping)作为一种自动化的数据获取方法,不仅能够快速地收集互联网上的数据,还能够对大量的数据进行分析和处理。在许多数据挖掘和信息检索项目中,爬虫已经成为一种非常重要的工具。本文将介绍Java爬虫的基本概

综述!深度模型融合(LLM/基础模型/联邦学习/微调等)

Apr 18, 2024 pm 09:43 PM

综述!深度模型融合(LLM/基础模型/联邦学习/微调等)

Apr 18, 2024 pm 09:43 PM

23年9月国防科大、京东和北理工的论文“DeepModelFusion:ASurvey”。深度模型融合/合并是一种新兴技术,它将多个深度学习模型的参数或预测合并为一个模型。它结合了不同模型的能力来弥补单个模型的偏差和错误,以获得更好的性能。而大规模深度学习模型(例如LLM和基础模型)上的深度模型融合面临着一些挑战,包括高计算成本、高维参数空间、不同异构模型之间的干扰等。本文将现有的深度模型融合方法分为四类:(1)“模式连接”,通过一条损失减少的路径将权重空间中的解连接起来,以获得更好的模型融合初

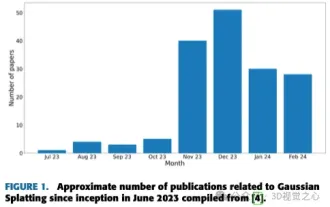

不止3D高斯!最新综述一览最先进的3D重建技术

Jun 02, 2024 pm 06:57 PM

不止3D高斯!最新综述一览最先进的3D重建技术

Jun 02, 2024 pm 06:57 PM

写在前面&笔者的个人理解基于图像的3D重建是一项具有挑战性的任务,涉及从一组输入图像推断目标或场景的3D形状。基于学习的方法因其直接估计3D形状的能力而受到关注。这篇综述论文的重点是最先进的3D重建技术,包括生成新颖的、看不见的视图。概述了高斯飞溅方法的最新发展,包括输入类型、模型结构、输出表示和训练策略。还讨论了尚未解决的挑战和未来的方向。鉴于该领域的快速进展以及增强3D重建方法的众多机会,对算法进行全面检查似乎至关重要。因此,本研究对高斯散射的最新进展进行了全面的概述。(大拇指往上滑

构建流畅无阻:如何正确配置Maven镜像地址

Feb 20, 2024 pm 08:48 PM

构建流畅无阻:如何正确配置Maven镜像地址

Feb 20, 2024 pm 08:48 PM

构建流畅无阻:如何正确配置Maven镜像地址在使用Maven构建项目时,配置正确的镜像地址是非常重要的。正确配置镜像地址可以加快项目构建的速度,避免网络延迟等问题。本文将介绍如何正确配置Maven镜像地址,并给出具体的代码示例。为什么需要配置Maven镜像地址Maven是一个项目管理工具,可以自动化构建项目、管理依赖、生成报告等。在Maven构建项目时,通常