kafka重复消费问题怎么解决

kafka重复消费问题的解决办法:1、处理消费者故障;2、使用幂等性处理;3、消息去重技术;4、使用消息唯一标识符;5、设计幂等性的生产者;6、优化Kafka配置和消费者参数;7、监控和告警。详细介绍:1、处理消费者故障,Kafka消费者可能会出现故障或异常退出的情况,导致已处理的消息被重新消费;2、使用幂等性处理,幂等性处理是指对同一个消息进行多次处理,其结果与一次处理等等。

解决Kafka重复消费问题需要采取多种措施,包括处理消费者故障、使用幂等性处理、消息去重技术、使用消息唯一标识符等。下面将详细介绍这些措施:

1、处理消费者故障

Kafka消费者可能会出现故障或异常退出的情况,导致已处理的消息被重新消费。为了避免这种情况,可以采用以下措施:

开启消费者自动提交偏移量:在消费者程序中开启自动提交偏移量的功能,确保每次成功消费的消息都会被正确地提交到Kafka中。这样可以保证即使消费者出现故障,也不会导致已处理消息的重复消费。

使用持久化存储:将消费者的偏移量存储在持久化存储中,例如数据库或RocksDB。这样即使消费者出现故障,也可以从持久化存储中恢复偏移量,避免重复消费。

2、使用幂等性处理

幂等性处理是指对同一个消息进行多次处理,其结果与一次处理相同。在Kafka消费者中,可以通过对消息进行幂等性处理来避免重复消费。例如,在处理消息时对消息进行去重处理,或者使用唯一标识符来识别重复的消息。这样可以保证即使消息被重复消费,也不会导致副作用。

3、消息去重技术

消息去重技术是解决重复消费问题的一种常见方法。可以通过在应用程序中维护一个已处理消息的记录或使用外部存储(如数据库)来实现消息的去重。在消费消息前,先检查该消息是否已经被处理过,如果已经处理过,则跳过该消息。这样可以有效地避免重复消费问题。

4、使用消息唯一标识符

在每条消息中添加一个唯一标识符,并在应用程序中记录已经处理的标识符。在消费消息前,先检查该消息的唯一标识符是否已经存在于已处理的记录中,如果存在则跳过该消息。这样可以保证即使消息被重复发送,也可以通过唯一标识符进行识别和处理。

5、设计幂等性的生产者

在消息的生产端实现幂等性,确保相同的消息重复发送时不会引起重复消费。可以通过为每条消息分配唯一的标识符或使用幂等性的消息发送策略来实现。这样可以保证即使生产者发送了重复的消息,也不会导致重复消费问题的出现。

6、优化Kafka配置和消费者参数

通过优化Kafka的配置和消费者参数,可以提高Kafka的性能和可靠性,从而减少重复消费问题的出现。例如,可以增加Kafka的分区数和提高消费者的消费速度,或者调整消费者的配置参数来提高其可靠性和稳定性。

7、监控和告警

通过监控Kafka的性能指标和告警机制,可以及时发现和处理重复消费问题。例如,可以监控消费者的消费速度、偏移量提交情况、Kafka队列大小等指标,并根据实际情况设置告警阈值。当达到告警阈值时,可以通过短信、邮件等方式及时通知相关人员进行处理。这样可以及时发现和解决问题,避免重复消费问题的扩大化。

综上所述,解决Kafka重复消费问题需要综合考虑多种措施,包括处理消费者故障、使用幂等性处理、消息去重技术、使用消息唯一标识符、设计幂等性的生产者、优化Kafka配置和消费者参数以及监控和告警等。需要根据实际情况选择合适的方法来解决重复消费问题,并持续监控和优化以提高整体性能和可靠性。

以上是kafka重复消费问题怎么解决的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何使用PHP和Kafka实现实时股票分析

Jun 28, 2023 am 10:04 AM

如何使用PHP和Kafka实现实时股票分析

Jun 28, 2023 am 10:04 AM

随着互联网和科技的发展,数字化投资已成为人们越来越关注的话题。很多投资者不断探索和研究投资策略,希望能够获得更高的投资回报率。股票交易中,实时的股票分析对决策非常重要,其中使用Kafka实时消息队列和PHP技术实现更是一种高效且实用的手段。一、Kafka介绍Kafka是由LinkedIn公司开发的一个高吞吐量的分布式发布、订阅消息系统。Kafka的主要特点是

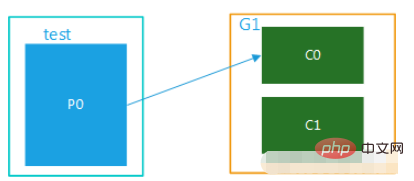

springboot+kafka中@KafkaListener动态指定多个topic怎么实现

May 20, 2023 pm 08:58 PM

springboot+kafka中@KafkaListener动态指定多个topic怎么实现

May 20, 2023 pm 08:58 PM

说明本项目为springboot+kafak的整合项目,故其用了springboot中对kafak的消费注解@KafkaListener首先,application.properties中配置用逗号隔开的多个topic。方法:利用Spring的SpEl表达式,将topics配置为:@KafkaListener(topics=“#{’${topics}’.split(’,’)}”)运行程序,console打印的效果如下

SpringBoot怎么集成Kafka配置工具类

May 12, 2023 pm 09:58 PM

SpringBoot怎么集成Kafka配置工具类

May 12, 2023 pm 09:58 PM

spring-kafka是基于java版的kafkaclient与spring的集成,提供了KafkaTemplate,封装了各种方法,方便操作,它封装了apache的kafka-client,不需要再导入client依赖org.springframework.kafkaspring-kafkaYML配置kafka:#bootstrap-servers:server1:9092,server2:9093#kafka开发地址,#生产者配置producer:#Kafka提供的序列化和反序列化类key

如何利用React和Apache Kafka构建实时数据处理应用

Sep 27, 2023 pm 02:25 PM

如何利用React和Apache Kafka构建实时数据处理应用

Sep 27, 2023 pm 02:25 PM

如何利用React和ApacheKafka构建实时数据处理应用引言:随着大数据与实时数据处理的兴起,构建实时数据处理应用成为了很多开发者的追求。React作为一个流行的前端框架,与ApacheKafka作为一个高性能的分布式消息传递系统的结合,可以帮助我们搭建实时数据处理应用。本文将介绍如何利用React和ApacheKafka构建实时数据处理应用,并

五种选择的可视化工具,用于探索Kafka

Feb 01, 2024 am 08:03 AM

五种选择的可视化工具,用于探索Kafka

Feb 01, 2024 am 08:03 AM

Kafka可视化工具的五种选择ApacheKafka是一个分布式流处理平台,能够处理大量实时数据。它广泛用于构建实时数据管道、消息队列和事件驱动的应用程序。Kafka的可视化工具可以帮助用户监控和管理Kafka集群,并更好地理解Kafka数据流。以下是对五种流行的Kafka可视化工具的介绍:ConfluentControlCenterConfluent

kafka可视化工具对比分析:如何选择最合适的工具?

Jan 05, 2024 pm 12:15 PM

kafka可视化工具对比分析:如何选择最合适的工具?

Jan 05, 2024 pm 12:15 PM

如何选择合适的Kafka可视化工具?五款工具对比分析引言:Kafka是一种高性能、高吞吐量的分布式消息队列系统,被广泛应用于大数据领域。随着Kafka的流行,越来越多的企业和开发者需要一个可视化工具来方便地监控和管理Kafka集群。本文将介绍五款常用的Kafka可视化工具,并对比它们的特点和功能,帮助读者选择适合自己需求的工具。一、KafkaManager

springboot项目配置多个kafka的示例代码

May 14, 2023 pm 12:28 PM

springboot项目配置多个kafka的示例代码

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2.配置文件相关信息kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#可以并发消费的线程数(通常与partition数量一致)kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

go-zero与Kafka+Avro的实践:构建高性能的交互式数据处理系统

Jun 23, 2023 am 09:04 AM

go-zero与Kafka+Avro的实践:构建高性能的交互式数据处理系统

Jun 23, 2023 am 09:04 AM

近年来,随着大数据的兴起和活跃的开源社区,越来越多的企业开始寻找高性能的交互式数据处理系统来满足日益增长的数据需求。在这场技术升级的浪潮中,go-zero和Kafka+Avro被越来越多的企业所关注和采用。go-zero是一款基于Golang语言开发的微服务框架,具有高性能、易用、易扩展、易维护等特点,旨在帮助企业快速构建高效的微服务应用系统。它的快速成长得