回顾NeurIPS 2023: 清华ToT推动大型模型成为焦点

近日,作为美国前十的科技博客,Latent Space对于刚刚过去的NeurIPS 2023大会进行了精选回顾总结。

在NeurIPS会议中,共有3586篇论文被接受,其中6篇获奖。虽然这些获奖论文备受关注,但其他论文同样具备出色的质量和潜力。实际上,这些论文甚至可能预示着AI领域的下一个重大突破。

那就让我们来一起看看吧!

论文题目:QLoRA: Efficient Finetuning of Quantized LLMs

论文地址:https://openreview.net/pdf?id=OUIFPHEgJU

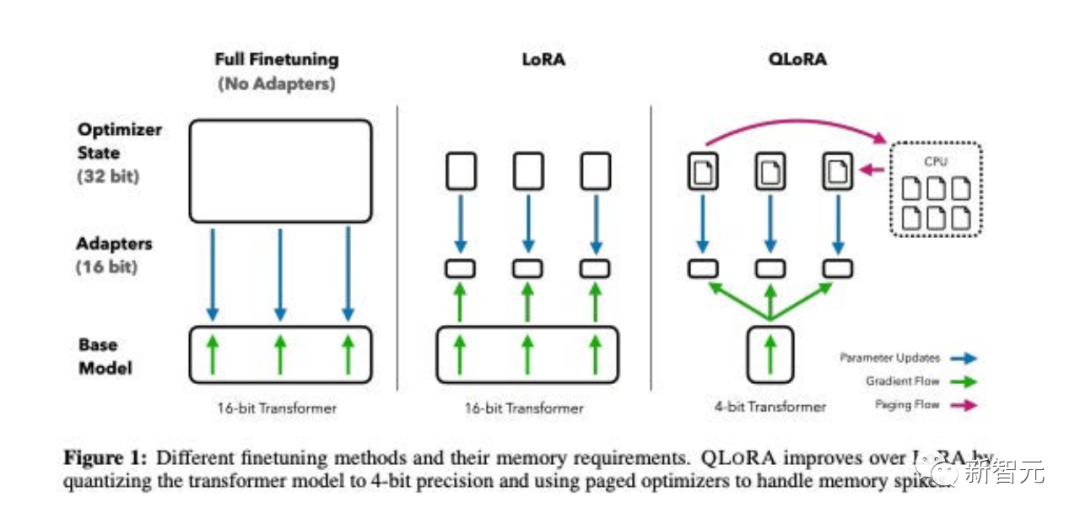

这篇论文提出了QLoRA,这是LoRA的一种更省内存但速度较慢的版本,它使用了几种优化技巧来节省内存。

总体而言,QLoRA使得在对大型语言模型进行微调时可以使用更少的GPU内存。

他们对一个新模型进行了微调,命名为Guanaco,仅用一个GPU进行了为期24小时的训练,结果在Vicuna基准测试中表现优于之前的模型。

与此同时,研究人员还开发了其他方法,如4-bit LoRA量化,其效果相似。

论文题目:DataComp: In search of the next generation of multimodal datasets

论文地址:https://openreview.net/pdf?id=dVaWCDMBof

多模态数据集在最近的突破中扮演着关键角色,如CLIP、Stable Diffusion和GPT-4,但与模型架构或训练算法相比,它们的设计并没有得到同等的研究关注。

为了解决这一机器学习生态系统中的不足,研究人员引入了DataComp,这是一个围绕Common Crawl的新候选池中的128亿个图文对进行数据集实验的测试平台。

使用者可以通过DataComp进行实验,设计新的过滤技术或精心策划新的数据源,并通过运行标准化的CLIP训练代码,以及在38个下游测试集上测试生成的模型,来评估他们的新数据集。

结果显示,最佳基准DataComp-1B,允许从头开始训练一个CLIP ViT-L/14模型,其在ImageNet上的零样本准确度达到了79.2%,比OpenAI的CLIP ViT-L/14模型高出3.7个百分点,以此证明DataComp工作流程可以产生更好的训练集。

论文题目:Visual Instruction Tuning

论文地址:https://www.php.cn/link/c0db7643410e1a667d5e01868827a9af

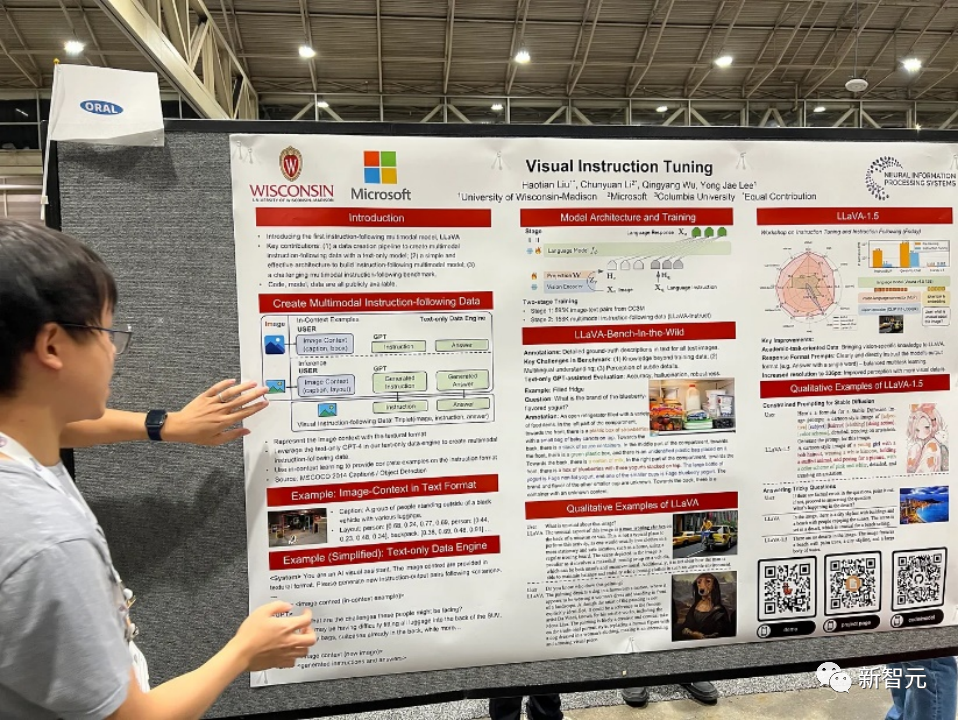

在这篇论文中,研究人员提出了首次尝试使用仅依赖语言的GPT-4生成多模态语言-图像指令跟随数据的方法。

通过在这种生成的数据上进行指令调整,引入了LLaVA:Large Language and Vision Assistant,这是一个端到端训练的大型多模态模型,连接了一个视觉编码器和LLM,用于通用的视觉和语言理解。

早期实验证明LLaVA展示了令人印象深刻的多模态聊天能力,有时展现出多模态GPT-4在未见过的图像/指令上的行为,并在合成的多模态指令跟随数据集上与GPT-4相比取得了85.1%的相对分数。

在对科学问答进行微调时,LLaVA和GPT-4的协同作用实现了92.53%的新的最先进准确性。

论文题目:Tree of Thoughts: Deliberate Problem Solving with Large Language Models

论文地址:https://arxiv.org/pdf/2305.10601.pdf

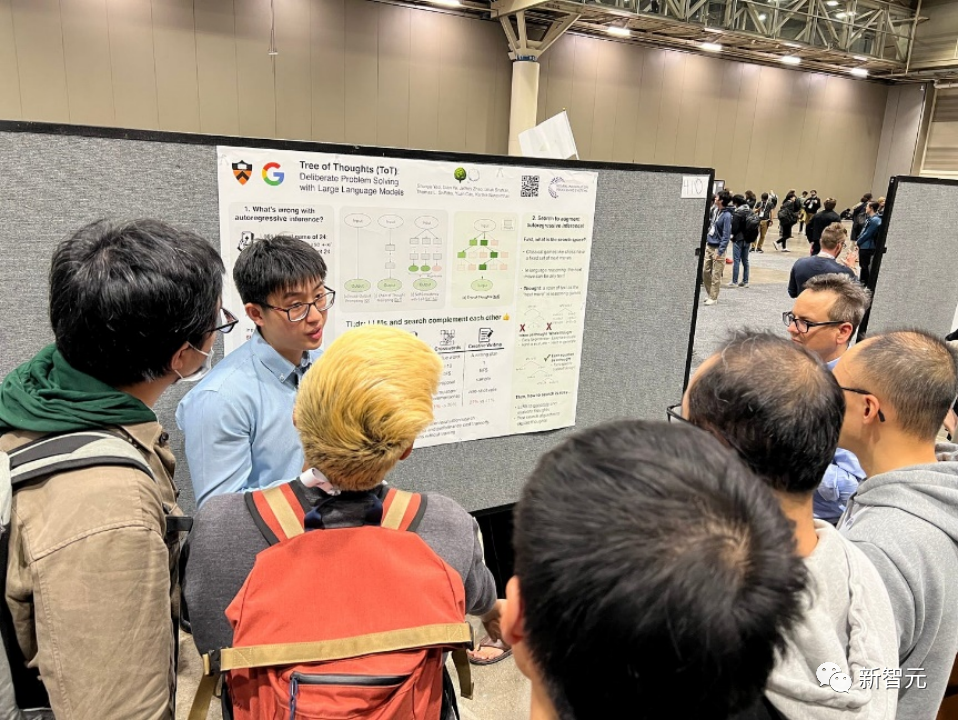

语言模型越来越多地被用于广泛的任务中进行一般性问题解决,但在推理过程中仍受限于标记级别、从左到右的决策过程。这意味着它们在需要探索、战略前瞻或初始决策起关键作用的任务中可能表现不佳。

为了克服这些挑战,研究人员引入了一种新的语言模型推理框架,Tree of Thoughts(ToT),它在促使语言模型方面推广了流行的Chain of Thought方法,并允许在一致的文本单元(思想)上进行探索,这些单元作为解决问题的中间步骤。

ToT使语言模型能够通过考虑多条不同的推理路径和自我评估选择来做出刻意的决策,以决定下一步行动,并在必要时展望或回溯以做出全局性的选择。

实验证明,ToT显著提高了语言模型在需要非平凡规划或搜索的三个新任务上的问题解决能力:24点游戏、创意写作和迷你填字游戏。例如,在24点游戏中,虽然使用Chain of Thought提示的GPT-4只解决了4%的任务,但ToT实现了74%的成功率。

论文题目:Toolformer: Language Models Can Teach Themselves to Use Tools

论文地址:https://arxiv.org/pdf/2302.04761.pdf

语言模型表现出在从少量示例或文本指令中解决新任务方面的显著能力,尤其是在大规模情境下。然而,令人矛盾的是,它们在基本功能方面(如算术或事实查找),相较于更简单且规模较小的专门模型,却表现出困难。

在这篇论文中,研究人员展示了语言模型可以通过简单的API自学使用外部工具,并实现两者的最佳结合。

他们引入了Toolformer,这个模型经过训练能够决定调用哪些API、何时调用它们、传递什么参数以及如何最佳地将结果合并到未来的token预测中。

这是以自监督的方式完成的,每个API只需要少量演示即可。他们整合了各种工具,包括计算器、问答系统、搜索引擎、翻译系统和日历等。

Toolformer在与更大模型竞争的时候,在各种下游任务中取得了明显改善的零样本性能,而不会牺牲其核心语言建模能力。

论文题目:Voyager: An Open-Ended Embodied Agent with Large Language Models

论文地址:https://arxiv.org/pdf/2305.16291.pdf

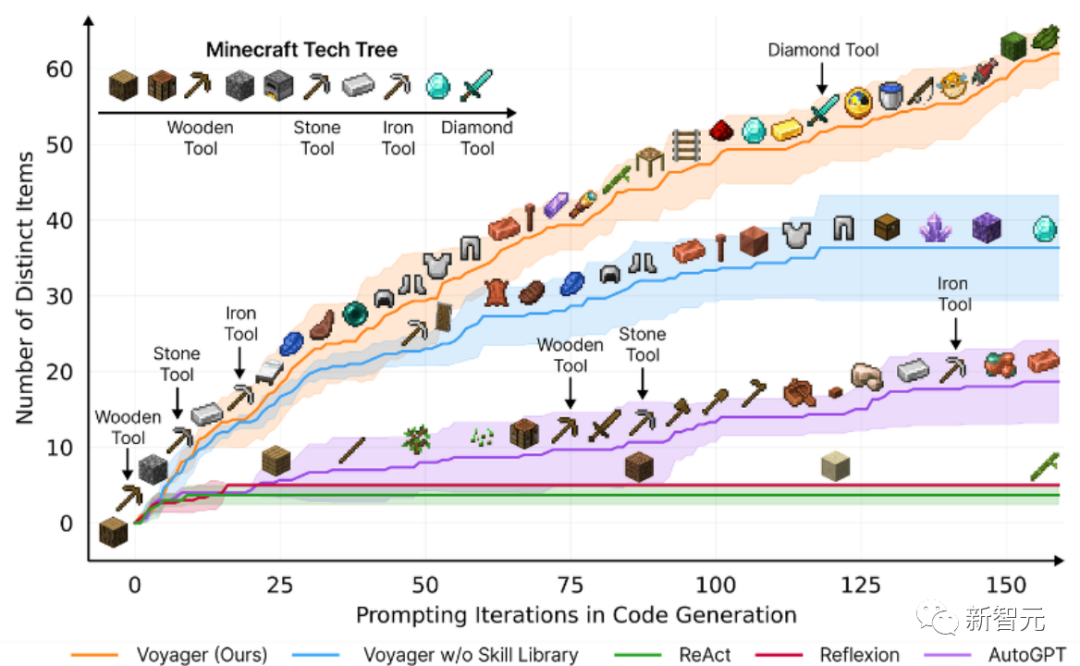

该论文介绍了Voyager,这是第一个由大型语言模型(LLM)驱动的,可以在Minecraft中连续探索世界、获取多样化技能并进行独立发现的learning agent。

Voyager包含三个关键组成部分:

自动课程,旨在最大程度地推动探索,

不断增长的可执行代码技能库,用于存储和检索复杂行为,

新的迭代提示机制,整合了环境反馈、执行错误和自我验证以改进程序。

Voyager通过黑盒查询与GPT-4进行交互,避免了对模型参数进行微调的需求。

根据实证研究,Voyager展现出强大的环境上下文中的终身学习能力,并在玩Minecraft方面表现出卓越的熟练度。

它获得了比先前技术水平高出3.3倍的独特物品,行进距离更长2.3倍,并且解锁关键技术树里程碑的速度比先前技术水平快15.3倍。

不过,虽然Voyager能够在新的Minecraft世界中利用学到的技能库从零开始解决新颖任务,但其他技术则难以泛化。

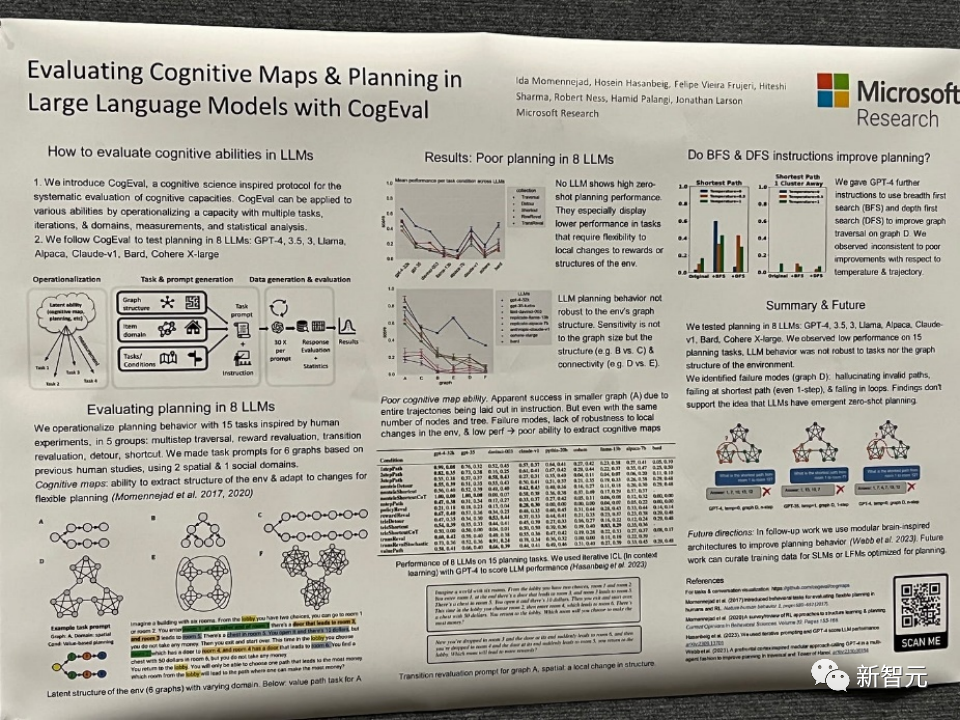

论文题目:Evaluating Cognitive Maps and Planning in Large Language Models with CogEval

论文地址:https://openreview.net/pdf?id=VtkGvGcGe3

该论文首先提出了CogEval,这是一个受认知科学启发的系统评估大型语言模型认知能力的协议。

其次,论文使用CogEval系统评估了八个LLMs(OpenAI GPT-4、GPT-3.5-turbo-175B、davinci-003-175B、Google Bard、Cohere-xlarge-52.4B、Anthropic Claude-1-52B、LLaMA-13B和Alpaca-7B)的认知地图和规划能力。任务提示基于人类实验,并且不在LLM训练集中存在。

研究发现,虽然LLMs在一些结构较简单的规划任务中显示出明显的能力,但一旦任务变得复杂,LLMs就会陷入盲区,包括对无效轨迹的幻觉和陷入循环。

这些发现不支持LLMs具有即插即用的规划能力的观点。可能是因为LLMs不理解规划问题背后的潜在关系结构,即认知地图,并在根据基础结构展开目标导向轨迹时出现问题。

论文题目:Mamba: Linear-Time Sequence Modeling with Selective State Spaces

论文地址:https://openreview.net/pdf?id=AL1fq05o7H

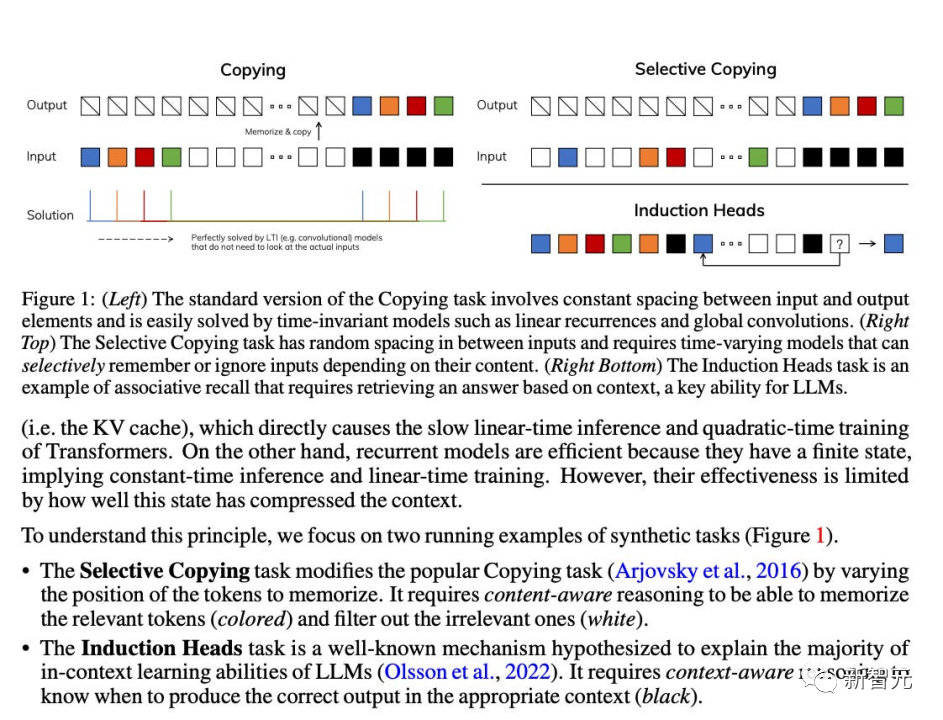

作者指出了目前许多次线性时间架构,如线性注意力、门控卷积和循环模型,以及结构化状态空间模型(SSMs),旨在解决Transformer在处理长序列时的计算效率低下问题。然而,这些模型在重要的语言等领域上并没有像注意力模型那样表现出色。作者认为这些

型的一个关键弱点是它们无法进行基于内容的推理,并进行了一些改进。

首先,简单地让 SSM 参数作为输入的函数,可以解决其离散模态的弱点,允许模型根据当前标记选择性地沿序列长度维度传播或忘记信息。

其次,尽管这种变化阻止了高效卷积的使用,但作者在循环模式下设计了一种硬件感知的并行算法。将这些选择性 SSM 集成到简化的端到端神经网络架构中,无需注意力机制,甚至不需要 MLP 模块 (Mamba)。

Mamba在推理速度上表现出色(比Transformers高5倍),并且在序列长度上呈线性缩放,在真实数据上的性能提高了,达到了百万长度序列。

作为一种通用的序列模型骨干,Mamba在语言、音频和基因组学等多个领域取得了最先进的性能。在语言建模方面,Mamba-1.4B模型在预训练和下游评估中均优于相同大小的Transformers模型,与其两倍大小的Transformers模型相匹敌。

虽然这些论文在2023年没有获得奖项,但比如Mamba,作为一种能够革新语言模型架构的技术模型,评估其影响还为时过早。

明年NeurIPS会如何走向,2024的人工智能和神经信息系统领域又会如何发展,虽然目前众说纷纭,但又有谁能打包票呢?让我们拭目以待。

以上是回顾NeurIPS 2023: 清华ToT推动大型模型成为焦点的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

0.这篇文章干了啥?提出了DepthFM:一个多功能且快速的最先进的生成式单目深度估计模型。除了传统的深度估计任务外,DepthFM还展示了在深度修复等下游任务中的最先进能力。DepthFM效率高,可以在少数推理步骤内合成深度图。下面一起来阅读一下这项工作~1.论文信息标题:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

DDREASE是一种用于从文件或块设备(如硬盘、SSD、RAM磁盘、CD、DVD和USB存储设备)恢复数据的工具。它将数据从一个块设备复制到另一个块设备,留下损坏的数据块,只移动好的数据块。ddreasue是一种强大的恢复工具,完全自动化,因为它在恢复操作期间不需要任何干扰。此外,由于有了ddasue地图文件,它可以随时停止和恢复。DDREASE的其他主要功能如下:它不会覆盖恢复的数据,但会在迭代恢复的情况下填补空白。但是,如果指示工具显式执行此操作,则可以将其截断。将数据从多个文件或块恢复到单

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基准测试中性能已经超过Pytorch和TensorFlow,7项指标排名第一。而且测试并不是在JAX性能表现最好的TPU上完成的。虽然现在在开发者中,Pytorch依然比Tensorflow更受欢迎。但未来,也许有更多的大模型会基于JAX平台进行训练和运行。模型最近,Keras团队为三个后端(TensorFlow、JAX、PyTorch)与原生PyTorch实现以及搭配TensorFlow的Keras2进行了基准测试。首先,他们为生成式和非生成式人工智能任务选择了一组主流

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

iPhone上的蜂窝数据互联网速度慢:修复

May 03, 2024 pm 09:01 PM

iPhone上的蜂窝数据互联网速度慢:修复

May 03, 2024 pm 09:01 PM

在iPhone上面临滞后,缓慢的移动数据连接?通常,手机上蜂窝互联网的强度取决于几个因素,例如区域、蜂窝网络类型、漫游类型等。您可以采取一些措施来获得更快、更可靠的蜂窝互联网连接。修复1–强制重启iPhone有时,强制重启设备只会重置许多内容,包括蜂窝网络连接。步骤1–只需按一次音量调高键并松开即可。接下来,按降低音量键并再次释放它。步骤2–该过程的下一部分是按住右侧的按钮。让iPhone完成重启。启用蜂窝数据并检查网络速度。再次检查修复2–更改数据模式虽然5G提供了更好的网络速度,但在信号较弱

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

阿里7B多模态文档理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模态文档理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模态文档理解能力新SOTA!阿里mPLUG团队发布最新开源工作mPLUG-DocOwl1.5,针对高分辨率图片文字识别、通用文档结构理解、指令遵循、外部知识引入四大挑战,提出了一系列解决方案。话不多说,先来看效果。复杂结构的图表一键识别转换为Markdown格式:不同样式的图表都可以:更细节的文字识别和定位也能轻松搞定:还能对文档理解给出详细解释:要知道,“文档理解”目前是大语言模型实现落地的一个重要场景,市面上有很多辅助文档阅读的产品,有的主要通过OCR系统进行文字识别,配合LLM进行文字理

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

什么?疯狂动物城被国产AI搬进现实了?与视频一同曝光的,是一款名为「可灵」全新国产视频生成大模型。Sora利用了相似的技术路线,结合多项自研技术创新,生产的视频不仅运动幅度大且合理,还能模拟物理世界特性,具备强大的概念组合能力和想象力。数据上看,可灵支持生成长达2分钟的30fps的超长视频,分辨率高达1080p,且支持多种宽高比。另外再划个重点,可灵不是实验室放出的Demo或者视频结果演示,而是短视频领域头部玩家快手推出的产品级应用。而且主打一个务实,不开空头支票、发布即上线,可灵大模型已在快影