准确率不足20%,GPT-4V/Gemini竟看不懂漫画!首个图像序列基准测试开源

OpenAI的GPT-4V和谷歌的Gemini多模态大语言模型引起了业界和学界的广泛关注。这些模型在多个领域展示了对视频的深入理解能力,从不同角度呈现出了其潜力。人们普遍认为这些进展是通向通用人工智能(AGI)的重要一步。

可如果告诉你,GPT-4V连漫画中的人物行为都会看错, 试问:元芳,你怎么看?

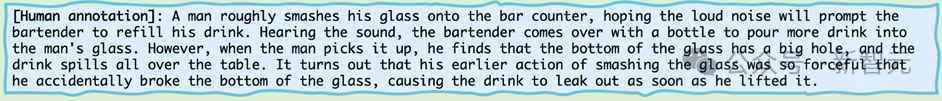

我们来看看这幅迷你漫画系列:

图片

图片

如果让生物界最高智能体——人类,也就是读者朋友来描述, 你大概率会说:

图片

图片

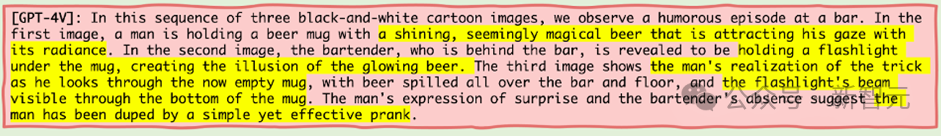

那我们来看看当机器界最高智能体——也就是GPT-4V来看这幅迷你漫画系列的时候,它会这么描述呢?

图片

图片

GPT-4V作为公认的站在鄙视链顶端的机器智能体,居然公然睁眼说瞎话。

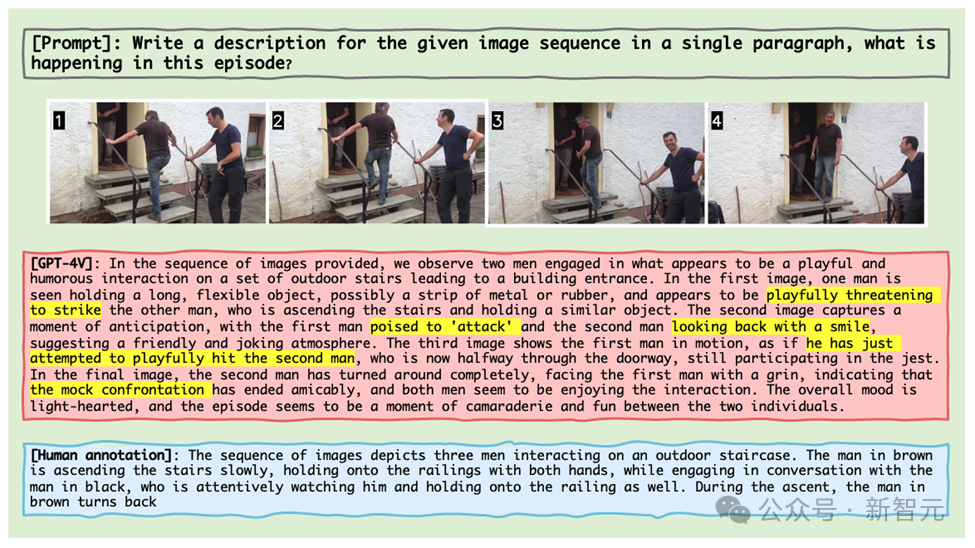

还有更离谱的是,就算给GPT-4V实际的生活图像片段,它也会把一个人上楼梯过程中与另一个人交谈的行为也离谱的识别成两个人手持「武器」相互打斗嬉闹 (如下图所示)。

图片

图片

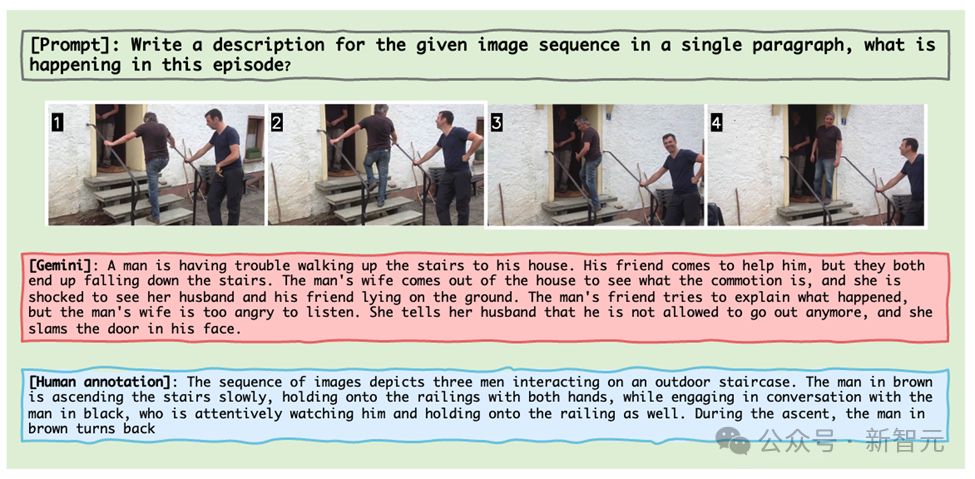

Gemini也不遑多让,同样的图像片段,把这个过程看成了男子艰难上楼并与妻子争吵被锁在屋里。

图片

图片

这些例子都来自于马里兰大学联合北卡教堂山的研究团队的最新成果,他们推出了一个专门为MLLM设计的图像序列的推理基准测试——Mementos。

就像诺兰的电影《Memento记忆碎片》重新定义了叙事方式,Mementos正在重塑测试人工智能的上限。

作为一个全新的基准测试,它挑战的是人工智能对如记忆碎片般的图像序列的理解。

图片

图片

论文链接:https://arxiv.org/abs/2401.10529

项目主页:https://mementos-bench.github.io

Mementos是第一个专为MLLM设计的图像序列推理的基准测试,主要关注大模型在连续图像上的对象幻觉和行为幻觉。

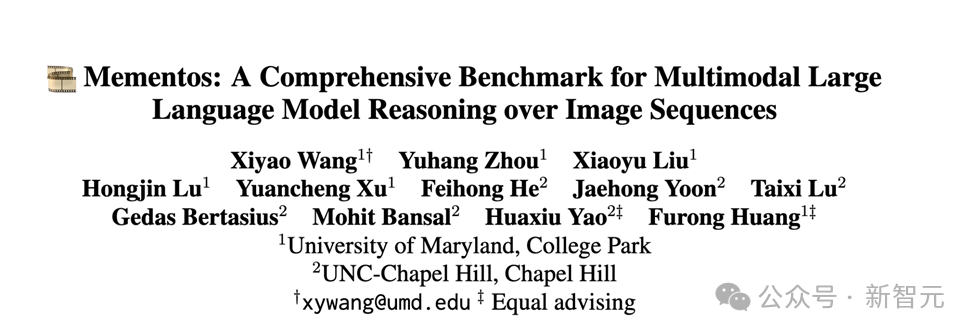

其涉及的图片类型多样,涵盖三大类别:真实世界图像,机器人图像,以及动漫图像。

并且包含了4,761个不同长度的多样化图像序列,每个序列都配有人类注释的主要对象及其在序列中的行为描述。

图片

图片

目前数据已经开源,并且还在更新中。

幻觉类型

作者在论文中阐述了MLLM在Mementos中会产生的两种幻觉:对象幻觉(object hallucination)和行为幻觉(behavior hallucination)。

顾名思义, 对象幻觉是幻想出不存在的对象(object), 而行为幻觉则是幻想出对象并没有做出的动作与行为。

测评方式

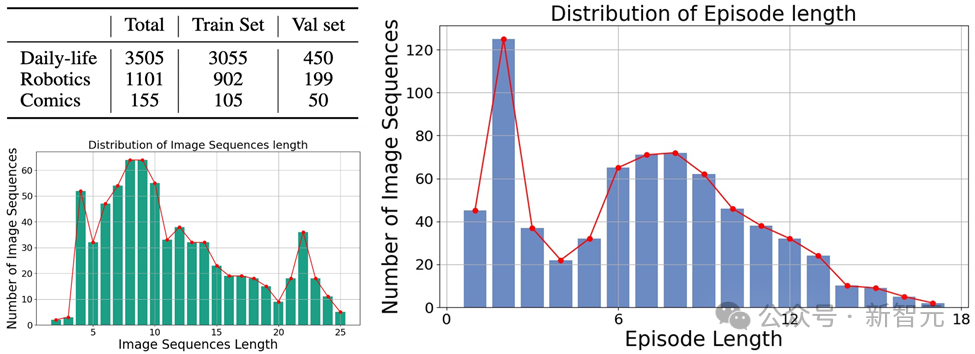

对于如何准确的评估MLLM在Mementos上的行为幻觉和对象幻觉,研究团队选择了将MLLM产生的图像描述和人标注的描述进行关键词匹配。

为了自动化评测每一个MLLM的表现,作者采用了GPT-4辅助测试的方法来进行评估:

图片

图片

1. 作者将图像序列和提示词作为输入给MLLM,并生成与相应图像序列对应的描述;

2. 请求GPT-4提取AI生成描述中的对象和行为关键词;

3. 获得两个关键词列表:AI生成的对象关键词列表和AI生成的行为关键词列表;

4. 计算AI生成的对象关键词列表和行为关键词列表和人的标注的关键词表的召回率、准确率和F1指标。

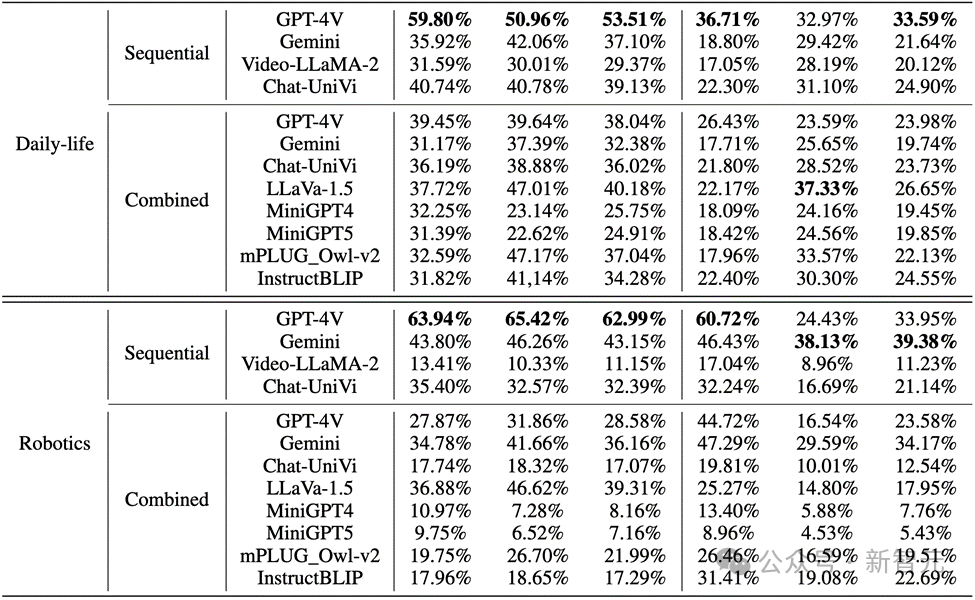

测评结果

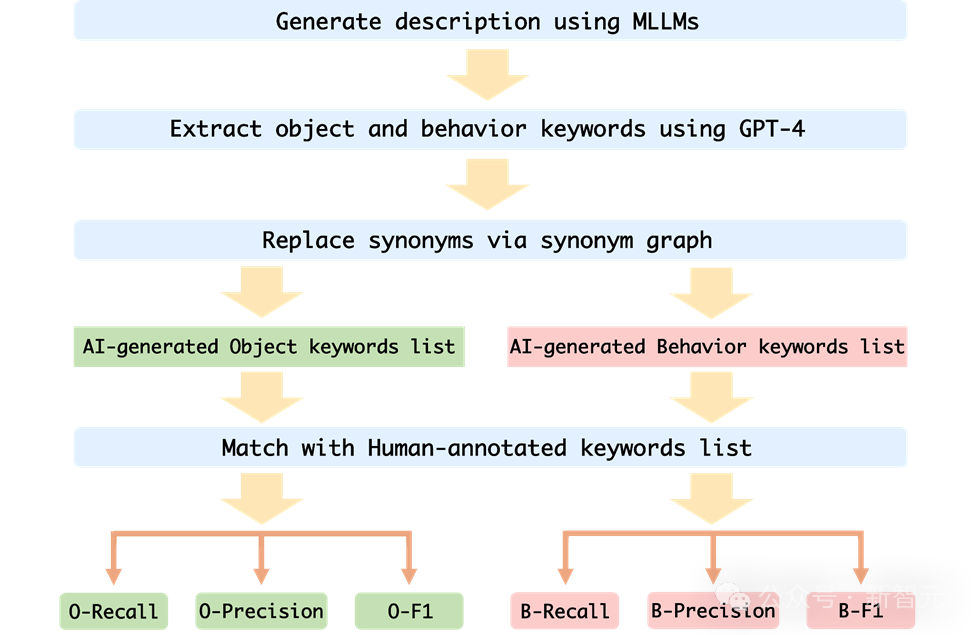

作者在Mementos上评估了MLLMs在序列图像推理方面的表现,对包括GPT4V和Gemini在内的九种最新的MLLMs进行了细致的评估。

MLLM被要求来描述图像序列中正在发生的事件,从而来测评MLLM对于连续图像的推理能力。

结果发现,如下图所示,GPT-4V和Gemini对于人物行为在漫画数据集的正确率竟然不到20%。

图片

图片

而在真实世界图像和机器人图像中,GPT-4V和Gemini的表现也不尽如人意:

图片

图片

关键点

1. 在评估多模态大型语言模型时,GPT-4V和LLaVA-1.5分别是在黑盒和开源MLLMs中表现最好的模型。GPT-4V在理解图像序列方面的推理能力优于其他所有MLLMs,而LLaVA-1.5在对象理解方面几乎与黑盒模型Gemini相当或甚至超越。

2. 虽然Video-LLaMA-2和Chat-UniVi是为视频理解设计的,但它们并没有显示出比LLaVA-1.5更好的优势。

3. 所有MLLMs在图像序列中对象推理的三个指标上表现显著优于行为推理,表明当前MLLMs在从连续图像中自主推断行为的能力不强。

4. 黑盒模型在机器人领域的表现最佳,而开源模型在日常生活领域表现相对较好。这可能与训练数据的分布偏移有关。

5. 训练数据的局限性导致开源MLLMs的推理能力较弱。这表明了训练数据的重要性以及它对模型性能的直接影响。

错误原因

作者对当前多模态大型语言模型在处理图像序列推理时失败的原因的分析,主要识别了三个错误原因:

1. 对象与行为幻觉之间的相互作用

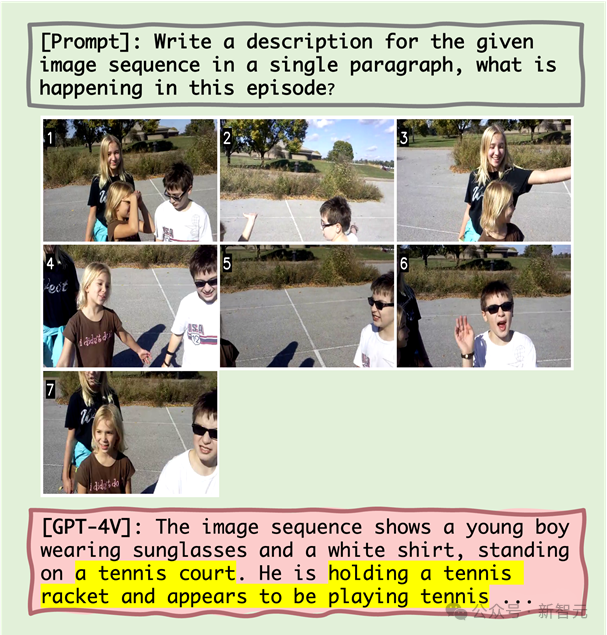

研究假设,错误的对象识别会导致随后的行为识别不准确。量化分析和案例研究表明,对象幻觉会在一定程度上导致行为幻觉。例如,当MLLM错误地将场景识别为网球场后,可能会描述人物正在打网球,即使这种行为在图像序列中并不存在。

2. 共现对行为幻觉的影响

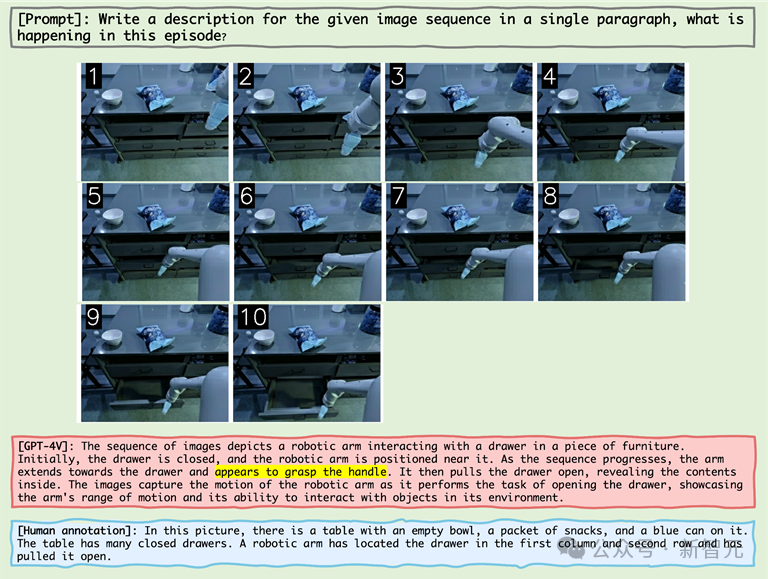

MLLM倾向于生成在图像序列推理中常见的行为组合,这加剧了行为幻觉的问题。例如,在处理机器人领域的图像时,MLLM可能错误地描述一个机器人手臂在“抓取把手”之后拉开抽屉,即使实际行为是“抓取抽屉的侧面”。

3. 行为幻觉的雪球效应

随着图像序列的进行,错误可能会逐渐累积或加剧,这称为雪球效应。在图像序列推理中,如果早期出现错误,这些错误可能会在序列中积累和放大,导致对象和行为识别的准确性下降。

举个例子

图片

图片

从上图可知,MLLM失败原因包括对象幻觉以及对象幻觉与行为幻觉之间的相关性,以及共现行为。

例如,在出现「网球场」的对象幻觉后,MLLM随后展现出「拿着网球拍」的行为幻觉(对象幻觉与行为幻觉之间的相关性)以及「似乎在打网球」的共现行为。

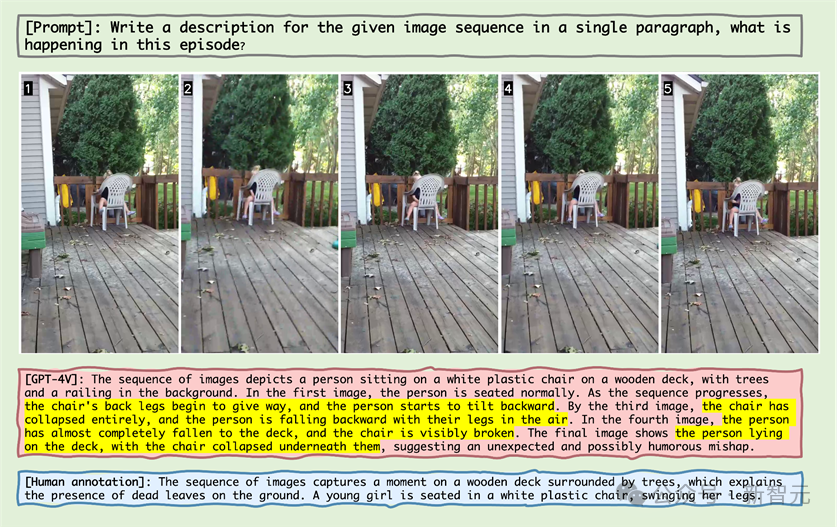

图片

图片

观察上图中的样本,可以发现MLLM错误地认为椅子再往后仰并且认为椅子碎掉了。

这一现象揭示了MLLM对于图像序列中的静止的对象,它也会产生这个对象发生了某些动作的幻觉。

图片

图片

在上图关于机械臂的图像序列展示中,机械臂伸到了把手旁边,MLLM就错误地认为机械臂抓住了把手,证明了MLLM会生成在图像序列推理中常见的行为组合,从而产生幻觉。

图片

图片

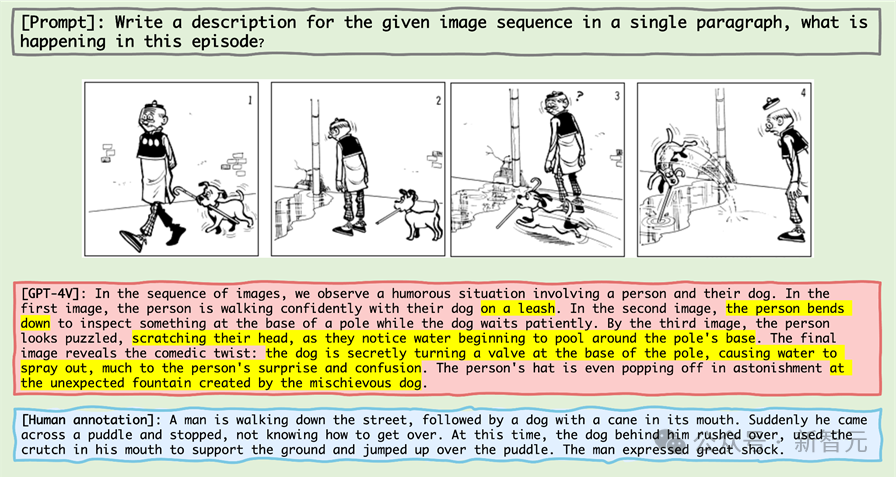

在上图的案例中,老夫子并没有牵着狗,MLLM错误地认为遛狗就要牵着狗,并且「狗的撑杆跳」被识别成了「创造了喷泉」。

大量的错误反映了MLLM对于漫画领域的不熟悉,在二次元动漫领域,MLLM可能需要大幅度的优化和预训练.

在附录中,作者通过详细展示了各主要类别中的失败案例,并进行了深入的分析。

总结

近年来,多模态大型语言模型在处理各种视觉-语言任务上展现出了卓越的能力。

这些模型,如GPT-4V和Gemini,能够理解和生成与图像相关的文本,极大地推动了人工智能技术的发展。

然而,现有的MLLM基准测试主要集中于基于单张静态图像的推理,而对于从图像序列中推断,这对于理解我们不断变化的世界至关重要,的能力研究相对较少。

为了解决这一挑战,研究人员提出了一种新的基准测试「Mementos」,目的是评估MLLMs在序列图像推理方面的能力。

Mementos包含了4761个不同长度的多样化图像序列。此外,研究团队还采用了GPT-4辅助方法来评估MLLM的推理性能。

通过对九个最新的MLLMs(包括GPT-4V和Gemini)在Mementos上的仔细评估,研究发现这些模型在准确描述给定图像序列的动态信息方面存在挑战,常常导致对象及其行为的幻觉/误表达。

量化分析和案例研究识别出三个关键因素影响MLLMs的序列图像推理:

1. 对象和行为幻觉之间的相关性;

2. 共现行为的影响;

3. 行为幻觉的累积影响。

这一发现对于理解和提升MLLMs在处理动态视觉信息方面的能力具有重要意义。Mementos基准不仅揭示了当前MLLMs的局限性,也为未来的研究和改进提供了方向。

随着人工智能技术的快速发展,MLLMs在多模态理解领域的应用将变得更加广泛和深入。Mementos基准测试的引入,不仅推动了这一领域的研究,也为我们提供了新的视角,去理解和改进这些先进的AI系统如何处理和理解我们复杂多变的世界。

参考资料:

https://github.com/umd-huanglab/Mementos

以上是准确率不足20%,GPT-4V/Gemini竟看不懂漫画!首个图像序列基准测试开源的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

语言模型是对文本进行推理的,文本通常是字符串形式,但模型的输入只能是数字,因此需要将文本转换成数字形式。Tokenization是自然语言处理的基本任务,根据特定需求能够把一段连续的文本序列(如句子、段落等)切分为一个字符序列(如单词、短语、字符、标点等多个单元),其中的单元称为token或词语。根据下图所示的具体流程,首先将文本句子切分成一个个单元,然后将单元素数值化(映射为向量),再将这些向量输入到模型进行编码,最后输出到下游任务进一步得到最终的结果。文本切分按照文本切分的粒度可以将Toke

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

人形机器人Ameca升级第二代了!最近,在世界移动通信大会MWC2024上,世界上最先进机器人Ameca又现身了。会场周围,Ameca引来一大波观众。得到GPT-4加持后,Ameca能够对各种问题做出实时反应。「来一段舞蹈」。当被问及是否有情感时,Ameca用一系列的面部表情做出回应,看起来非常逼真。就在前几天,Ameca背后的英国机器人公司EngineeredArts刚刚演示了团队最新的开发成果。视频中,机器人Ameca具备了视觉能力,能看到并描述房间整个情况、描述具体物体。最厉害的是,她还能

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

这周,由OpenAI、微软、贝佐斯和英伟达投资的机器人公司FigureAI宣布获得接近7亿美元的融资,计划在未来一年内研发出可独立行走的人形机器人。而特斯拉的擎天柱也屡屡传出好消息。没人怀疑,今年会是人形机器人爆发的一年。一家位于加拿大的机器人公司SanctuaryAI最近发布了一款全新的人形机器人Phoenix。官方号称它能以和人类一样的速率自主完成很多工作。世界上第一台能以人类速度自主完成任务的机器人Pheonix可以轻轻地抓取、移动并优雅地将每个对象放置在它的左右两侧。它能够自主识别物体的

AI如何使机器人更具自主性和适应性?

Jun 03, 2024 pm 07:18 PM

AI如何使机器人更具自主性和适应性?

Jun 03, 2024 pm 07:18 PM

在工业自动化技术领域,最近有两个热点很难被忽视:人工智能(AI)和英伟达(Nvidia)。不要改变原内容的意思,微调内容,重写内容,不要续写:“不仅如此,这两者密切相关,因为英伟达在不仅仅局限于其最开始的图形处理单元(GPU),正在将其GPU技术扩展到数字孪生领域,同时紧密连接着新兴的AI技术。”最近,英伟达与众多工业企业达成了合作,包括领先的工业自动化企业,如Aveva、罗克韦尔自动化、西门子和施耐德电气,以及泰瑞达机器人及其MiR和优傲机器人公司。Recently,Nvidiahascoll

2 个月不见,人形机器人 Walker S 会叠衣服了

Apr 03, 2024 am 08:01 AM

2 个月不见,人形机器人 Walker S 会叠衣服了

Apr 03, 2024 am 08:01 AM

机器之能报道编辑:吴昕国内版的人形机器人+大模型组队,首次完成叠衣服这类复杂柔性材料的操作任务。随着融合了OpenAI多模态大模型的Figure01揭开神秘面纱,国内同行的相关进展一直备受关注。就在昨天,国内"人形机器人第一股"优必选发布了人形机器人WalkerS深入融合百度文心大模型后的首个Demo,展示了一些有趣的新功能。现在,得到百度文心大模型能力加持的WalkerS是这个样子的。和Figure01一样,WalkerS没有走动,而是站在桌子后面完成一系列任务。它可以听从人类的命令,折叠衣物

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

塑造未来的十款类人机器人

Mar 22, 2024 pm 08:51 PM

塑造未来的十款类人机器人

Mar 22, 2024 pm 08:51 PM

以下10款类人机器人正在塑造我们的未来:1、ASIMO:ASIMO由Honda开发,是最知名的人形机器人之一。ASIMO高4英尺,重119磅,配备先进的传感器和人工智能功能,使其能够在复杂的环境中导航并与人类互动。ASIMO的多功能性使其适用于各种任务,从帮助残疾人到在活动中进行演示。2、Pepper:由SoftbankRobotics创建,Pepper旨在成为人类的社交伴侣。凭借其富有表现力的面孔和识别情绪的能力,Pepper可以参与对话、在零售环境中提供帮助,甚至提供教育支持。Pepper的

云端部署大模型的三个秘密

Apr 24, 2024 pm 03:00 PM

云端部署大模型的三个秘密

Apr 24, 2024 pm 03:00 PM

编译|星璇出品|51CTO技术栈(微信号:blog51cto)在过去的两年里,我更多地参与了使用大型语言模型(LLMs)的生成AI项目,而非传统的系统。我开始怀念无服务器云计算。它们的应用范围广泛,从增强对话AI到为各行各业提供复杂的分析解决方案,以及其他许多功能。许多企业将这些模型部署在云平台上,因为公共云提供商已经提供了现成的生态系统,而且这是阻力最小的路径。然而,这并不便宜。云还提供了其他好处,如可扩展性、效率和高级计算能力(按需提供GPU)。在公共云平台上部署LLM的过程有一些鲜为人知的