UCLA华人提出全新自我对弈机制!LLM自己训自己,效果碾压GPT-4专家指导

合成数据已经成为了大语言模型进化之路上最重要的一块基石了。

去年底,有网友曝出前OpenAI首席科学家Ilya多次表示LLM的发展没有数据瓶颈,合成数据可以解决大部分问题。

图片

图片

英伟达高级科学家Jim Fan在研究了最新一批论文后得出结论,他认为将合成数据与传统游戏和图像生成技术相结合,可以让LLM实现巨大的自我进化。

图片

图片

而正式提出这个方法的论文,是由来自UCLA的华人团队。

图片

图片

论文地址:https://www.php.cn/link/236522d75c8164f90a85448456e1d1aa

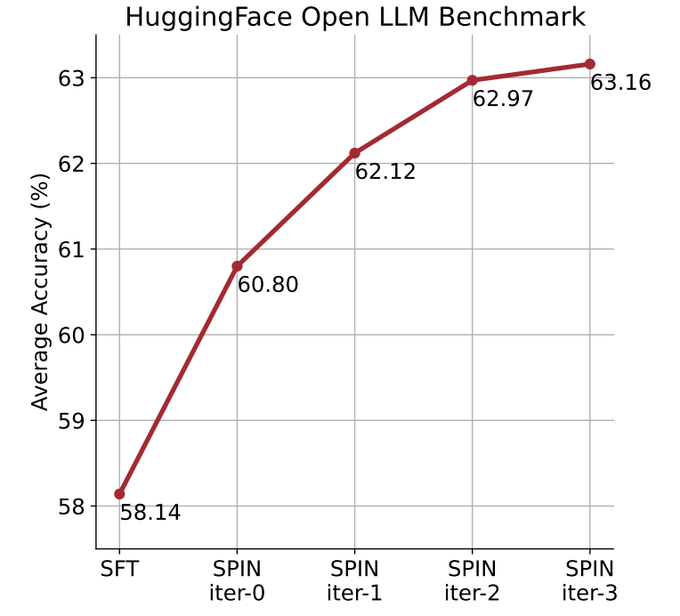

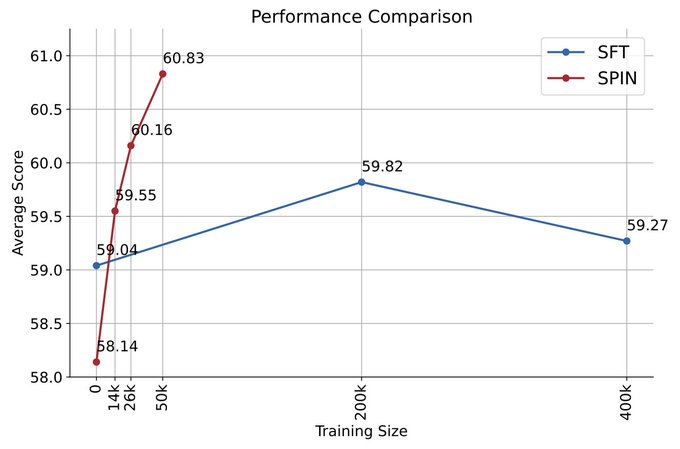

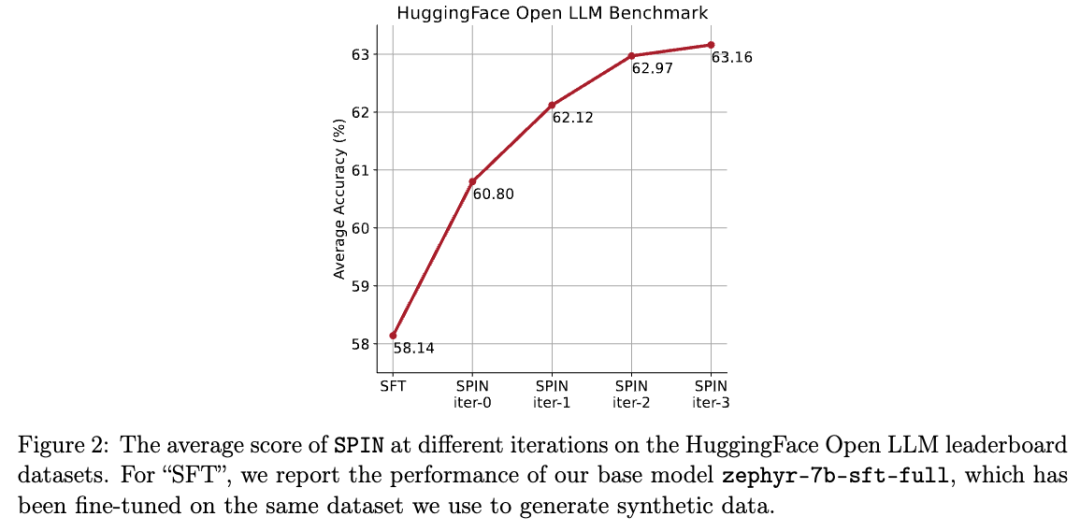

他们使用自我对弈机制(SPIN)生成合成数据,并通过自我微调的方法,不依赖新的数据集,将性能较弱的LLM在Open LLM Leaderboard Benchmark上的平均分从58.14提升至63.16。

研究人员提出了一种名为SPIN的自我微调的方法,通过自我对弈的方式——LLM与其前一轮迭代版本进行对抗,从而逐步提升语言模型的性能。

图片

图片

这样就无需额外的人类标注数据或更高级语言模型的反馈,也能完成模型的自我进化。

主模型和对手模型的参数完全一致。用两个不同的版本进行自我对弈。

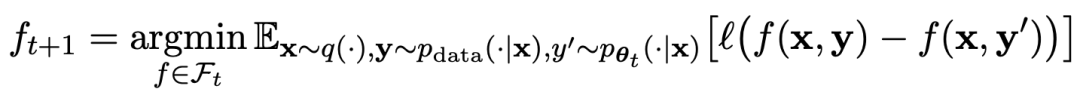

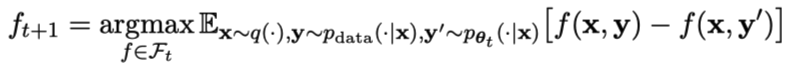

对弈过程用公式可以概括为:

图片

图片

自我对弈的训练方式,总结起来思路大概是这样:

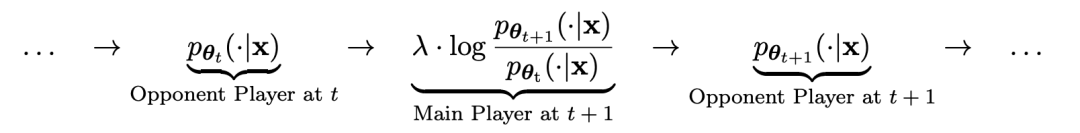

通过训练主模型来区分对手模型生成的响应和人类目标响应,对手模型是轮迭代获得的语言模型,目标是生成尽可能难以区分的响应。

假设第t轮迭代得到的语言模型参数为θt,则在第t+1轮迭代中,使用θt作为对手玩家,针对监督微调数据集中每个prompt x,使用θt生成响应y'。

然后优化新语言模型参数θt+1,使其可以区分y'和监督微调数据集中人类响应y。如此可以形成一个渐进的过程,逐步逼近目标响应分布。

这里,主模型的损失函数采用对数损失,考虑y和y'的函数值差。

对手模型加入KL散度正则化,防止模型参数偏离太多。

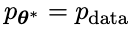

具体的对抗博弈训练目标如公式4.7所示。从理论分析可以看出,当语言模型的响应分布等于目标响应分布时,优化过程收敛。

如果使用对弈之后生成的合成数据进行训练,再使用SPIN进行自我微调,能有效提高LLM的性能。

图片

图片

但之后在初始的微调数据上再次简单地微调却又会导致性能下降。

而SPIN仅需要初始模型本身和现有的微调数据集,就能使得LLM通过SPIN获得自我提升。

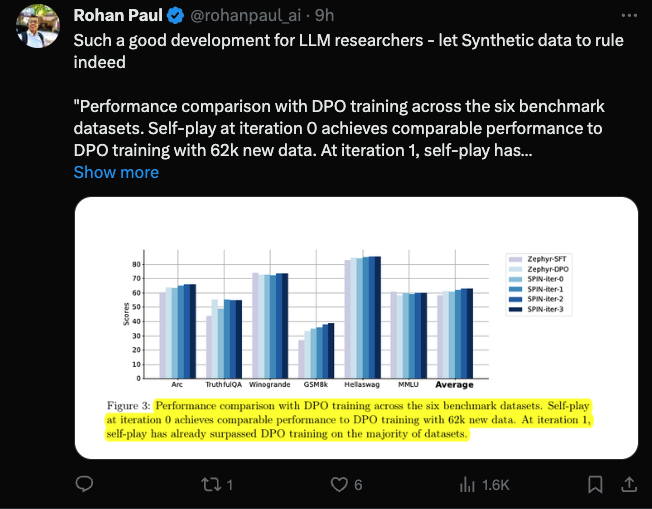

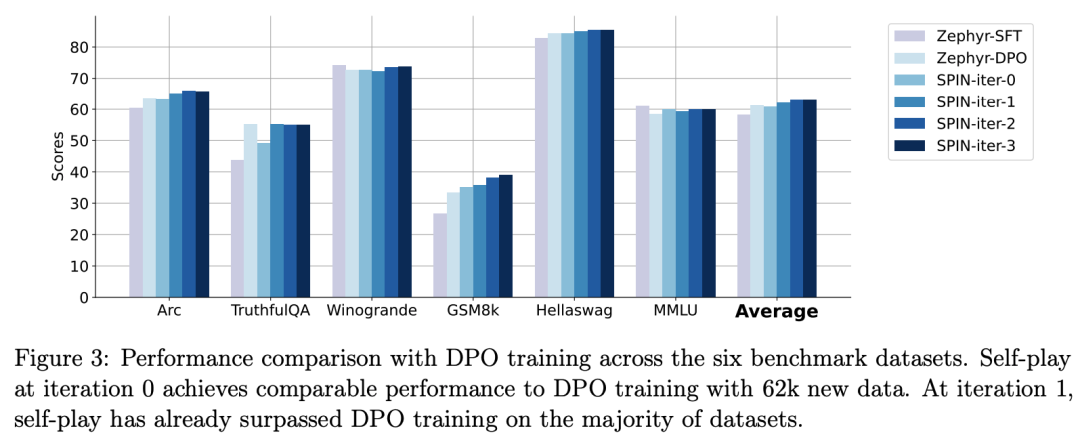

特别是,SPIN甚至超越了通过DPO使用额外的GPT-4偏好数据训练的模型。

图片

图片

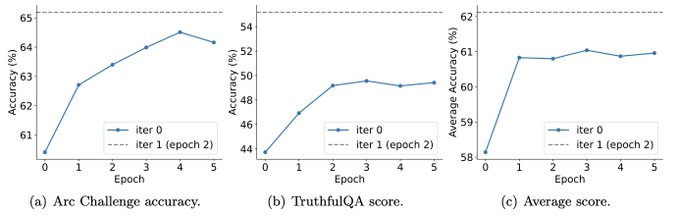

而且实验还表明,迭代训练比更多epoch的训练能更加有效地提升模型性能。

图片

图片

延长单次迭代的训练持续时间不会降低SPIN的性能,但会达到极限。

迭代次数越多,SPIN的效果的就越明显。

网友在看完这篇论文之后感叹:

合成数据将主宰大语言模型的发展,对于大语言模型的研究者来说将会是非常好的消息!

图片

图片

自我对弈让LLM能不断提高

具体来说,研究人员开发的SPIN系统,是由两个相互影响的模型相互促进的系统。

用 表示的前一次迭代t的LLM,研究人员使用它来生成对人工注释的SFT数据集中的提示x的响应y。

表示的前一次迭代t的LLM,研究人员使用它来生成对人工注释的SFT数据集中的提示x的响应y。

接下来的目标是找到一个新的LLM ,能够区分

,能够区分 生成的响应y和人类生成的响应y'。

生成的响应y和人类生成的响应y'。

这个过程可以看作是一个两人游戏:

主要玩家或新的LLM 试图辨别对手玩家的响应和人类生成的响应,而对手或旧的LLM

试图辨别对手玩家的响应和人类生成的响应,而对手或旧的LLM 生成响应与人工注释的SFT数据集中的数据尽可能相似。

生成响应与人工注释的SFT数据集中的数据尽可能相似。

通过对旧的 进行微调而获得的新LLM

进行微调而获得的新LLM 更喜欢

更喜欢 的响应,从而产生与

的响应,从而产生与 更一致的分布

更一致的分布 。

。

在下一次迭代中,新获得的LLM 成为响应生成的对手,自我对弈过程的目标是LLM最终收敛到

成为响应生成的对手,自我对弈过程的目标是LLM最终收敛到 ,使得最强的LLM不再能够区分其先前生成的响应版本和人类生成的版本。

,使得最强的LLM不再能够区分其先前生成的响应版本和人类生成的版本。

如何使用SPIN提升模型性能

研究人员设计了个两人游戏,其中主要模型的目标是区分LLM生成的响应和人类生成的响应。与此同时,对手的作用是产生与人类的反应无法区分的反应。研究人员的方法的核心是训练主要模型。

首先说明如何训练主要模型来区分LLM的回复和人类的回复。

研究人员方法的核心是自我博弈机制,其中主玩家和对手都是相同的LLM,但来自不同的迭代。

更具体地说,对手是上一次迭代中的旧LLM,而主玩家是当前迭代中要学习的新LLM。在迭代t+1时包括以下两个步骤:(1)训练主模型,(2)更新对手模型。

训练主模型

首先,研究人员将说明如何训练主玩家区分LLM反应和人类反应。受积分概率度量(IPM)的启发,研究人员制定了目标函数:

图片

图片

更新对手模型

对手模型的目标是找到更好的LLM,使其产生的响应与主模型的p数据无异。

实验

SPIN有效提升基准性能

研究人员使用HuggingFace Open LLM Leaderboard作为广泛的评估来证明 SPIN的有效性。

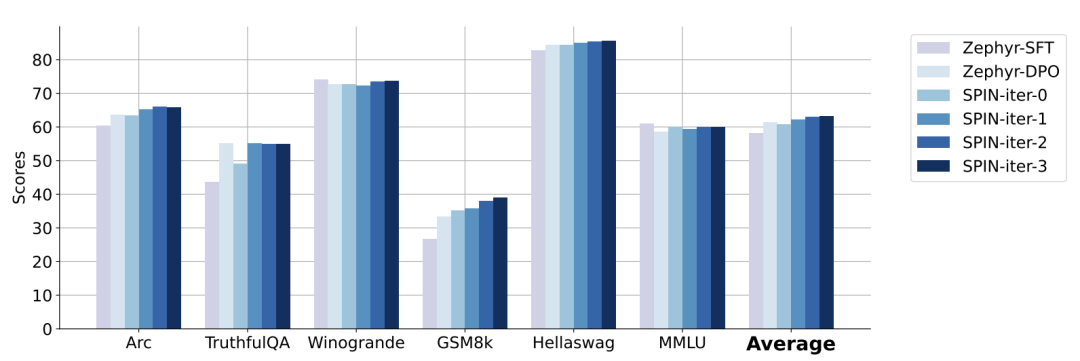

在下图中,研究人员将经过0到3次迭代后通过SPIN微调的模型与基本模型zephyr-7b-sft-full的性能进行了比较。

研究人员可以观察到,SPIN通过进一步利用SFT数据集,在提高模型性能方面表现出了显着的效果,而基础模型已经在该数据集上进行了充分的微调。

在第0次迭代中,模型响应是从zephyr-7b-sft-full生成的,研究人员观察到平均得分总体提高了2.66%。

在TruthfulQA和GSM8k基准测试中,这一改进尤其显着,分别提高了超过5%和10%。

在迭代1中,研究人员采用迭代0中的LLM模型来生成SPIN的新响应,遵循算法1中概述的过程。

此迭代平均产生1.32%的进一步增强,在Arc Challenge和TruthfulQA基准测试中尤其显着。

随后的迭代延续了各种任务增量改进的趋势。同时,迭代t+1时的改进自然更小

图片

图片

zephyr-7b-beta是从zephyr-7b-sft-full衍生出来的模型,使用DPO在大约62k个偏好数据上训练而成。

研究人员注意到,DPO需要人工输入或高级语言模型反馈来确定偏好,因此数据生成是一个相当昂贵的过程。

相比之下,研究人员的SPIN只需要初始模型本身就可以。

此外,与需要新数据源的DPO不同,研究人员的方法完全利用现有的SFT数据集。

下图显示了SPIN在迭代0和1(采用50k SFT数据)与DPO训练的性能比较。

图片

图片

研究人员可以观察到,虽然DPO利用了更多新来源的数据,但基于现有SFT数据的SPIN从迭代1开始,SPIN甚至超过了DPO的性能、SPIN在排行榜基准测试中的表现甚至超过了DPO。

参考资料:

以上是UCLA华人提出全新自我对弈机制!LLM自己训自己,效果碾压GPT-4专家指导的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

本地使用Groq Llama 3 70B的逐步指南

Jun 10, 2024 am 09:16 AM

本地使用Groq Llama 3 70B的逐步指南

Jun 10, 2024 am 09:16 AM

译者|布加迪审校|重楼本文介绍了如何使用GroqLPU推理引擎在JanAI和VSCode中生成超快速响应。每个人都致力于构建更好的大语言模型(LLM),例如Groq专注于AI的基础设施方面。这些大模型的快速响应是确保这些大模型更快捷地响应的关键。本教程将介绍GroqLPU解析引擎以及如何在笔记本电脑上使用API和JanAI本地访问它。本文还将把它整合到VSCode中,以帮助我们生成代码、重构代码、输入文档并生成测试单元。本文将免费创建我们自己的人工智能编程助手。GroqLPU推理引擎简介Groq

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

加州理工华人用AI颠覆数学证明!提速5倍震惊陶哲轩,80%数学步骤全自动化

Apr 23, 2024 pm 03:01 PM

加州理工华人用AI颠覆数学证明!提速5倍震惊陶哲轩,80%数学步骤全自动化

Apr 23, 2024 pm 03:01 PM

LeanCopilot,让陶哲轩等众多数学家赞不绝口的这个形式化数学工具,又有超强进化了?就在刚刚,加州理工教授AnimaAnandkumar宣布,团队发布了LeanCopilot论文的扩展版本,并且更新了代码库。图片论文地址:https://arxiv.org/pdf/2404.12534.pdf最新实验表明,这个Copilot工具,可以自动化80%以上的数学证明步骤了!这个纪录,比以前的基线aesop还要好2.3倍。并且,和以前一样,它在MIT许可下是开源的。图片他是一位华人小哥宋沛洋,他是

从“人+RPA”到“人+生成式AI+RPA”,LLM如何影响RPA人机交互?

Jun 05, 2023 pm 12:30 PM

从“人+RPA”到“人+生成式AI+RPA”,LLM如何影响RPA人机交互?

Jun 05, 2023 pm 12:30 PM

图片来源@视觉中国文|王吉伟从“人+RPA”到“人+生成式AI+RPA”,LLM如何影响RPA人机交互?换个角度,从人机交互看LLM如何影响RPA?影响程序开发与流程自动化人机交互的RPA,现在也要被LLM改变了?LLM如何影响人机交互?生成式AI怎么改变RPA人机交互?一文看明白:大模型时代来临,基于LLM的生成式AI正在快速变革RPA人机交互;生成式AI重新定义人机交互,LLM正在影响RPA软件架构变迁。如果问RPA对程序开发以及自动化有哪些贡献,其中一个答案便是它改变了人机交互(HCI,h

Plaud 推出 NotePin AI 可穿戴录音机,售价 169 美元

Aug 29, 2024 pm 02:37 PM

Plaud 推出 NotePin AI 可穿戴录音机,售价 169 美元

Aug 29, 2024 pm 02:37 PM

Plaud Note AI 录音机(亚马逊有售,售价 159 美元)背后的公司 Plaud 宣布推出一款新产品。该设备被称为 NotePin,被描述为人工智能记忆胶囊,与 Humane AI Pin 一样,它是可穿戴的。 NotePin 是

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

人形机器人Ameca升级第二代了!最近,在世界移动通信大会MWC2024上,世界上最先进机器人Ameca又现身了。会场周围,Ameca引来一大波观众。得到GPT-4加持后,Ameca能够对各种问题做出实时反应。「来一段舞蹈」。当被问及是否有情感时,Ameca用一系列的面部表情做出回应,看起来非常逼真。就在前几天,Ameca背后的英国机器人公司EngineeredArts刚刚演示了团队最新的开发成果。视频中,机器人Ameca具备了视觉能力,能看到并描述房间整个情况、描述具体物体。最厉害的是,她还能

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

关于Llama3,又有测试结果新鲜出炉——大模型评测社区LMSYS发布了一份大模型排行榜单,Llama3位列第五,英文单项与GPT-4并列第一。图片不同于其他Benchmark,这份榜单的依据是模型一对一battle,由全网测评者自行命题并打分。最终,Llama3取得了榜单中的第五名,排在前面的是GPT-4的三个不同版本,以及Claude3超大杯Opus。而在英文单项榜单中,Llama3反超了Claude,与GPT-4打成了平手。对于这一结果,Meta的首席科学家LeCun十分高兴,转发了推文并