在2GB DAYU200上本地部署大语言模型

实现思路和步骤

将轻量级LLM模型推理框架InferLLM移植到OpenHarmony标准系统,并编译出可以在OpenHarmony上运行的二进制文件。这个推理框架是一个简单高效的LLM CPU推理框架,可以在本地部署LLM中的量化模型。

使用OpenHarmony NDK来编译OpenHarmony上的InferLLM可执行文件(具体使用OpenHarmony lycium 交叉编译框架,然后编写一些脚本。然后把其存放在tpc_c_cplusplusSIG仓库。)

在DAYU200上本地部署大语言模型

编译获取InferLLM三方库编译产物

下载OpenHarmony sdk,下载地址:

http://ci.openharmony.cn/workbench/cicd/dailybuild/dailyList

下载本仓库

git clone https://gitee.com/openharmony-sig/tpc_c_cplusplus.git --depth=1

# 设置环境变量export OHOS_SDK=解压目录/ohos-sdk/linux# 请替换为你自己的解压目录 cd lycium./build.sh InferLLM

获取InferLLM三方库头文件及生成的库

在tpc_c_cplusplus/thirdparty/InferLLM/目录下会生成InferLLM-405d866e4c11b884a8072b4b30659c63555be41d目录,该目录下存在已编译完成的32位和64位三方库。(相关编译结果不会被打包进入lycium目录下的usr目录)。

InferLLM-405d866e4c11b884a8072b4b30659c63555be41d/arm64-v8a-buildInferLLM-405d866e4c11b884a8072b4b30659c63555be41d/armeabi-v7a-build

将编译产物和模型文件推送至开发板运行

- 下载模型文件:https://huggingface.co/kewin4933/InferLLM-Model/tree/main

- 将编译InferLLM生成的llama可执行文件、OpenHarmony sdk中的libc++_shared.so、下载好的模型文件chinese-alpaca-7b-q4.bin 打包成文件夹 llama_file

# 将llama_file文件夹发送到开发板data目录hdc file send llama_file /data

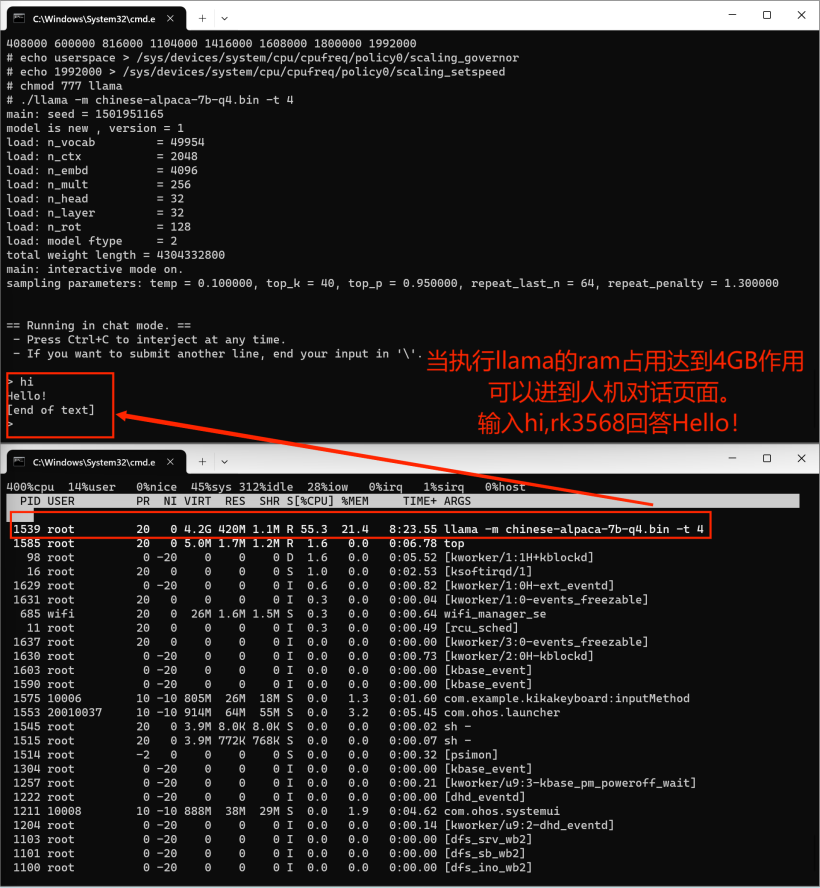

# hdc shell 进入开发板执行cd data/llama_file# 在2GB的dayu200上加swap交换空间# 新建一个空的ram_ohos文件touch ram_ohos# 创建一个用于交换空间的文件(8GB大小的交换文件)fallocate -l 8G /data/ram_ohos# 设置文件权限,以确保所有用户可以读写该文件:chmod 777 /data/ram_ohos# 将文件设置为交换空间:mkswap /data/ram_ohos# 启用交换空间:swapon /data/ram_ohos# 设置库搜索路径export LD_LIBRARY_PATH=/data/llama_file:$LD_LIBRARY_PATH# 提升rk3568cpu频率# 查看 CPU 频率cat /sys/devices/system/cpu/cpu*/cpufreq/cpuinfo_cur_freq# 查看 CPU 可用频率(不同平台显示的可用频率会有所不同)cat /sys/devices/system/cpu/cpufreq/policy0/scaling_available_frequencies# 将 CPU 调频模式切换为用户空间模式,这意味着用户程序可以手动控制 CPU 的工作频率,而不是由系统自动管理。这样可以提供更大的灵活性和定制性,但需要注意合理调整频率以保持系统稳定性和性能。echo userspace > /sys/devices/system/cpu/cpufreq/policy0/scaling_governor# 设置rk3568 CPU 频率为1.9GHzecho 1992000 > /sys/devices/system/cpu/cpufreq/policy0/scaling_setspeed# 执行大语言模型chmod 777 llama./llama -m chinese-alpaca-7b-q4.bin -t 4

移植InferLLM三方库在OpenHarmmony设备rk3568上部署大语言模型实现人机对话。最后运行效果有些慢,跳出人机对话框也有些慢,请耐心等待。

以上是在2GB DAYU200上本地部署大语言模型的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

本地使用Groq Llama 3 70B的逐步指南

Jun 10, 2024 am 09:16 AM

本地使用Groq Llama 3 70B的逐步指南

Jun 10, 2024 am 09:16 AM

译者|布加迪审校|重楼本文介绍了如何使用GroqLPU推理引擎在JanAI和VSCode中生成超快速响应。每个人都致力于构建更好的大语言模型(LLM),例如Groq专注于AI的基础设施方面。这些大模型的快速响应是确保这些大模型更快捷地响应的关键。本教程将介绍GroqLPU解析引擎以及如何在笔记本电脑上使用API和JanAI本地访问它。本文还将把它整合到VSCode中,以帮助我们生成代码、重构代码、输入文档并生成测试单元。本文将免费创建我们自己的人工智能编程助手。GroqLPU推理引擎简介Groq

余承东卸任华为终端BG CEO,何刚将接任

May 02, 2024 pm 04:01 PM

余承东卸任华为终端BG CEO,何刚将接任

May 02, 2024 pm 04:01 PM

根据多家媒体报道,华为于4月30日下午内部发布人事调整文件,宣布余承东将卸任华为终端BGCEO一职。余承东将仍保留终端BG董事长职位。原华为终端BG、首席运营官何刚将接任华为终端BGCEO职位。据透露,除了上述个人事变动调整外,该文件并无更多信息。关于这次重大人事变动的背景和余承东卸任终端BGCEO之后新的业务重心,也未有进一步的说明。有消息源表示,此次调整属于常规的业务架构调整,可让余承东有更多精力为消费者打造精品。余承东出生于1969年,本科毕业于西北工业大学自动控制系,硕士毕业于清华大学,

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

HarmonyOS NEXT 原生智能开启 AI 大模型时代的 OS 新体验!华为小艺变身智能体

Jun 22, 2024 am 02:30 AM

HarmonyOS NEXT 原生智能开启 AI 大模型时代的 OS 新体验!华为小艺变身智能体

Jun 22, 2024 am 02:30 AM

AI大模型已经成为当下科技圈炙手可热的话题,越来越多的企业开始布局大模型能力,越来越多的产品开始强调AI。但是从目前的体验来看,市场上涌入的大部分AI产品,往往只是在应用层面简单地集成了大模型应用,并未从底层实现系统性的AI技术变革。在HDC2024上,伴随着HarmonyOSNEXT面向开发者和先锋用户开放Beta,华为向业界展示了什么是真正的“原生智能”——拥有系统级AI能力,AI不再仅仅是手机的附加品,而是与操作系统深度融合,成为系统级的核心能力。据介绍,通过软硬芯云整合,HarmonyO

小艺升级为智能体!HarmonyOS NEXT鸿蒙原生智能开启全新AI时代

Jun 22, 2024 am 01:56 AM

小艺升级为智能体!HarmonyOS NEXT鸿蒙原生智能开启全新AI时代

Jun 22, 2024 am 01:56 AM

6月21日,华为开发者大会2024(HDC2024)再聚东莞松山湖。本届大会上,最令人关注的莫过于HarmonyOSNEXT正式面向开发者和先锋用户启动Beta,并全方位展示了HarmonyOSNEXT全场景、原生智能和原生安全三大“王炸”级创新特性。HarmonyOSNEXT原生智能:开启全新AI时代放弃安卓框架之后,HarmonyOSNEXT成为真正独立于安卓、iOS的操作系统,堪称是一场史无前例的脱胎换骨。在其众多新特性中,原生智能无疑是最能带给用户直观感受和体验升级的新特性

在OpenHarmony本地部署大语言模型

Jun 07, 2024 am 10:02 AM

在OpenHarmony本地部署大语言模型

Jun 07, 2024 am 10:02 AM

本文将第二届OpenHarmony技术大会上展示的《在OpenHarmony本地部署大语言模型》成果开源,开源地址:https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty/InferLLM/docs/hap_integrate.md。实现思路和步骤移植轻量级LLM模型推理框架InferLLM到OpenHarmony标准系统,编译出能在OpenHarmony运行的二进制产物。InferLLM是一个简单高效的L

鸿蒙智行享界S9及全场景新品发布会,多款重磅新品齐发

Aug 08, 2024 am 07:02 AM

鸿蒙智行享界S9及全场景新品发布会,多款重磅新品齐发

Aug 08, 2024 am 07:02 AM

今天下午,鸿蒙智行正式迎来了新品牌与新车。 8月6日,华为举行鸿蒙智行享界S9及华为全场景新品发布会,带来了全景智慧旗舰轿车享界S9、问界新M7Pro和华为novaFlip、MatePadPro12.2英寸、全新MatePadAir、华为毕升激光打印机X1系列、FreeBuds6i、WATCHFIT3和智慧屏S5Pro等多款全场景智慧新品,从智慧出行、智慧办公到智能穿戴,华为全场景智慧生态持续构建,为消费者带来万物互联的智慧体验。鸿蒙智行:深度赋能,推动智能汽车产业升级华为联合中国汽车产业伙伴,为

华为Pura70怎么使用AI云增强功能_华为AI云增强使用教程

Apr 26, 2024 pm 02:20 PM

华为Pura70怎么使用AI云增强功能_华为AI云增强使用教程

Apr 26, 2024 pm 02:20 PM

华为AI云增强功能是一种通过人工智能技术优化照片画质的实用功能。那么华为Pura70如何使用AI云增强功能呢?有需要的小伙伴一起来下文看看吧。一、升级最新版本:1、下载并安装最新版本:鸿蒙OS4.0.0.126。2、等待安装完成,即可使用云增强新功能。二、开启云增强服务:1、打开相册,点击右上角四个点,点击设置。2、开启AI云增强功能。三、使用云增强功能:1、在相册中找到需要AI云增强的照片,点击右上角的魔棒图标。2、点击同意。3、完成AI云增强后,相册就会自动多出一张照片。在右下角即可查看到魔