谷歌Gemini1.5火速上线:MoE架构,100万上下文

今天,谷歌宣布推出 Gemini 1.5。

Gemini 1.5是在谷歌基础模型和基础设施的研究与工程创新基础上开发的。这个版本引入了新的专家混合(MoE)架构,以提高Gemini 1.5的训练和服务的效率。

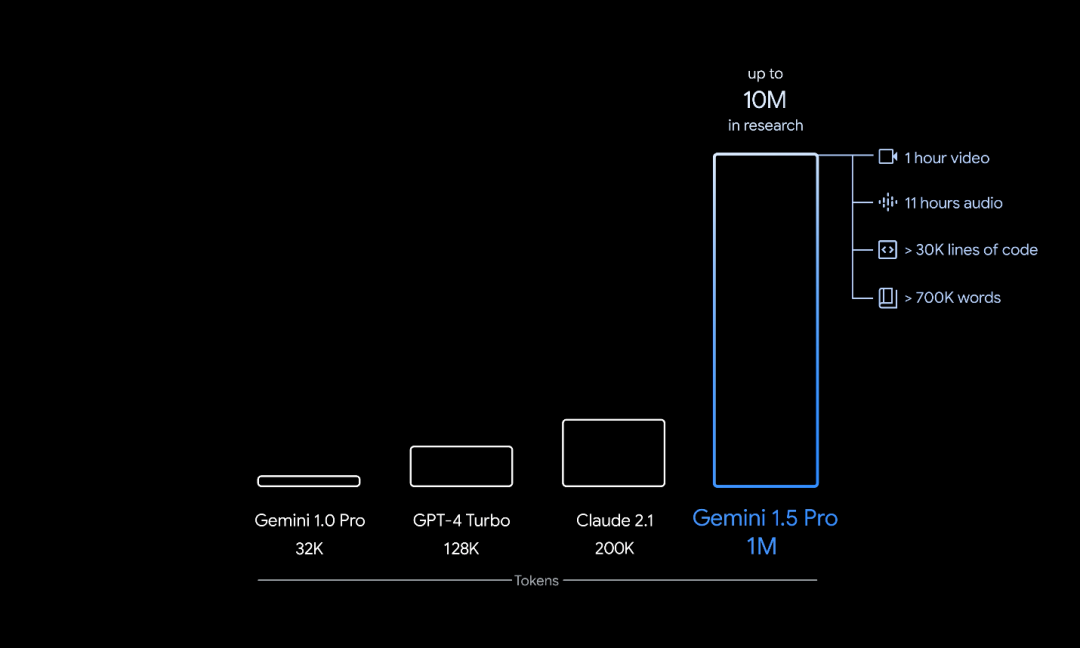

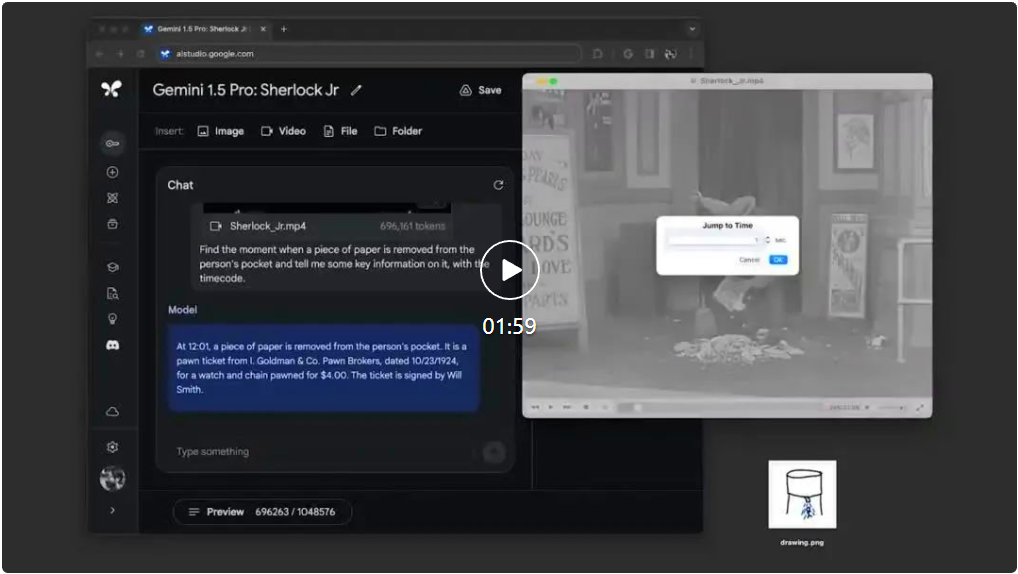

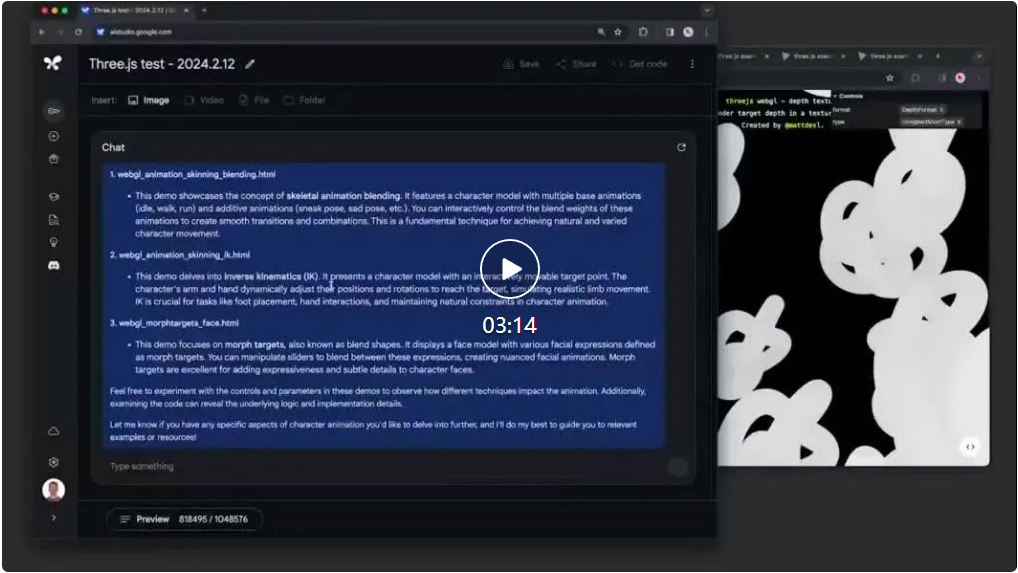

谷歌推出的是用于早期测试的Gemini 1.5的第一个版本,即Gemini 1.5 Pro。它是一种中型多模态模型,主要针对多种任务进行了扩展优化。与谷歌最大的模型1.0 Ultra相比,Gemini 1.5 Pro的性能水平相似,并引入了突破性的实验特征,能够更好地理解长上下文。

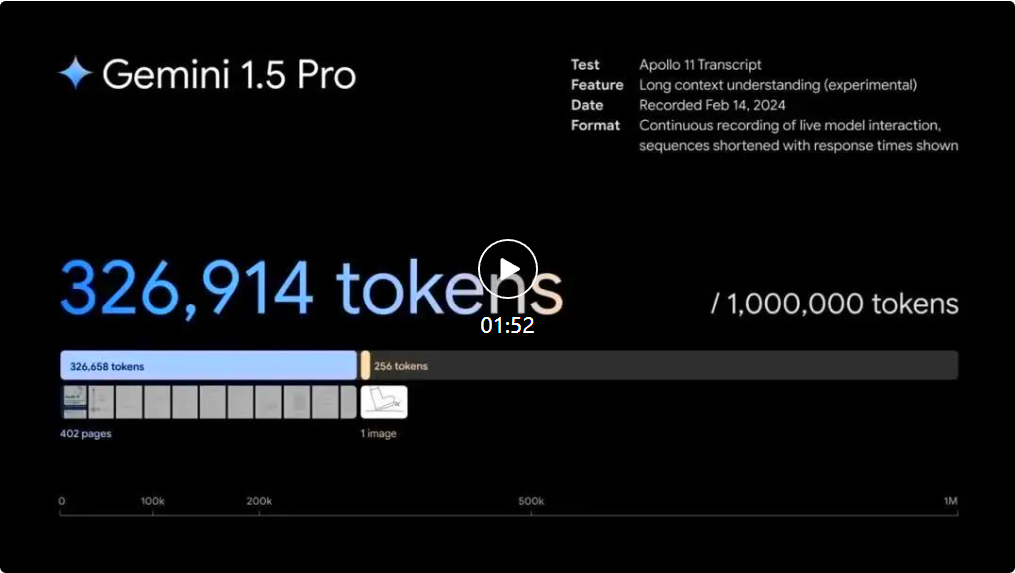

Gemini 1.5 Pro的token上下文窗口数量为128,000个。然而,谷歌从今天开始,为少数开发人员和企业客户提供了AI Studio和Vertex AI的私人预览版,允许他们在最多1,000,000个token的上下文窗口中进行尝试。此外,谷歌还进行了一些优化,旨在改善延迟、减少计算要求并提升用户体验。

谷歌 CEO Sundar Pichai 和谷歌 DeepMind CEO Demis Hassabis 对新模型进行了专门介绍。

以上是谷歌Gemini1.5火速上线:MoE架构,100万上下文的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

2025币圈交易所平台哪个好 十大热门货币交易app最新推荐

Mar 25, 2025 pm 06:18 PM

2025币圈交易所平台哪个好 十大热门货币交易app最新推荐

Mar 25, 2025 pm 06:18 PM

2025币圈交易所平台排名:1. OKX,2. Binance,3. Gate.io,4. Coinbase,5. Kraken,6. Huobi Global,7. Crypto.com,8. KuCoin,9. Gemini,10. Bitstamp。这些平台在安全措施、用户评价和市场表现方面表现优异,适合用户选择进行数字货币交易。

欧易okex账号怎么注册、使用、注销教程

Mar 31, 2025 pm 04:21 PM

欧易okex账号怎么注册、使用、注销教程

Mar 31, 2025 pm 04:21 PM

本文详细介绍了欧易OKEx账号的注册、使用和注销流程。注册需下载APP,输入手机号或邮箱注册,完成实名认证。使用方面涵盖登录、充值提现、交易以及安全设置等操作步骤。而注销账号则需要联系欧易OKEx客服,提供必要信息并等待处理,最终获得账号注销确认。 通过本文,用户可以轻松掌握欧易OKEx账号的完整生命周期管理,安全便捷地进行数字资产交易。

2025年安全好用的虚拟币交易平台榜单汇总

Mar 25, 2025 pm 06:15 PM

2025年安全好用的虚拟币交易平台榜单汇总

Mar 25, 2025 pm 06:15 PM

2025年安全好用的虚拟币交易平台推荐,本文汇总了Binance、OKX、火币、Gate.io、Coinbase、Kraken、KuCoin、Bitfinex、Crypto.com和Gemini等十个全球主流虚拟货币交易平台。它们在交易对数量、24小时成交额、安全性、用户体验等方面各有优势,例如Binance交易速度快,OKX期货交易热门,Coinbase适合新手,Kraken则以安全性着称。 但需注意,虚拟货币交易风险极高,投资需谨慎,中国大陆地区不受法律保护。选择平台前请务必仔细评估自身风

2025数字货币交易所APP哪个好 十大虚拟币app交易所排行

Mar 25, 2025 pm 06:06 PM

2025数字货币交易所APP哪个好 十大虚拟币app交易所排行

Mar 25, 2025 pm 06:06 PM

2025年安全的数字货币App交易所排名:1. OKX,2. Binance,3. Gate.io,4. Coinbase,5. Kraken,6. Huobi Global,7. Crypto.com,8. KuCoin,9. Gemini,10. Bitstamp。这些平台在安全措施、用户评价和市场表现方面表现优异,适合用户选择进行数字货币交易。

以太坊正规交易平台最新汇总2025

Mar 26, 2025 pm 04:45 PM

以太坊正规交易平台最新汇总2025

Mar 26, 2025 pm 04:45 PM

2025年,选择“正规”的以太坊交易平台意味着安全、合规、透明。 持牌经营、资金安全、透明运营、AML/KYC、数据保护和公平交易是关键。 Coinbase、Kraken、Gemini 等合规交易所值得关注。 币安和欧易有机会通过加强合规性成为正规平台。 DeFi 是一个选择,但也存在风险。 务必关注安全性、合规性、费用,分散风险,备份私钥,并进行自己的研究 。

2025全球十大加密货币交易所最新排名

Mar 26, 2025 pm 05:09 PM

2025全球十大加密货币交易所最新排名

Mar 26, 2025 pm 05:09 PM

要预测2025年加密货币交易所的排名很困难,因为市场变化迅速。重要的不是具体的排名,而是要了解影响排名的因素:监管合规、机构投资、DeFi整合、用户体验、安全性和全球化。 Binance、Coinbase、Kraken等都有望进入前十,但也可能出现黑天鹅事件。 关注市场趋势和交易所的动态,不要盲信排名,投资前做好调研。

如何优化jieba分词以改善景区评论的关键词提取效果?

Apr 01, 2025 pm 06:24 PM

如何优化jieba分词以改善景区评论的关键词提取效果?

Apr 01, 2025 pm 06:24 PM

如何优化jieba分词以改善景区评论的关键词提取?在使用jieba分词处理景区评论数据时,如果发现分词结果不理�...

十大虚拟数字货币交易所 最新货币交易平台app排行2025年

Mar 25, 2025 pm 06:30 PM

十大虚拟数字货币交易所 最新货币交易平台app排行2025年

Mar 25, 2025 pm 06:30 PM

2025年安全的数字货币App交易所排名:1. OKX,2. Binance,3. Gate.io,4. Coinbase,5. Kraken,6. Huobi Global,7. Crypto.com,8. KuCoin,9. Gemini,10. Bitstamp。这些平台在安全措施、用户评价和市场表现方面表现优异,适合用户选择进行数字货币交易。