用Vision Pro实时训练机器狗!MIT博士生开源项目火了

Vision Pro又现火爆新玩法,这回还和具身智能联动了~

就像这样,MIT小哥利用Vision Pro的手部追踪功能,成功实现了对机器狗的实时控制。

不仅开门这样的动作能精准get:

也几乎没什么延时。

Demo一出,不仅网友们大赞鹅妹子嘤,各路具身智能研究人员也嗨了。

比如这位准清华叉院博士生:

还有人大胆预测:这就是我们与下一代机器互动的方式。

项目如何实现,作者小哥朴英孝(Younghyo Park)已经在GitHub上开源。相关App可以直接在Vision Pro的App Store上下载。

用Vision Pro训练机器狗

具体来看看作者小哥开发的App——Tracking Steamer。

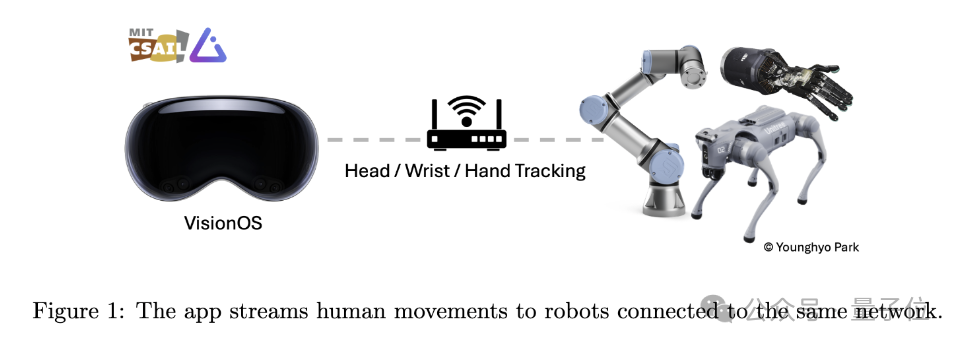

顾名思义,这个应用程序旨在利用Vision Pro追踪人类动作,并将这些动作数据实时传输到同一WiFi下的其他机器人设备上。

动作追踪的部分,主要依靠苹果的ARKit库来实现。

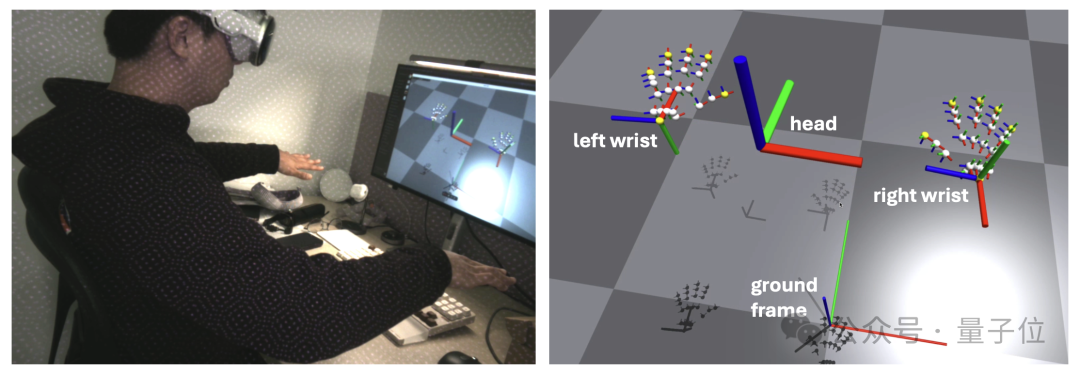

其中头部追踪调用的是queryDeviceAnchor。用户可以通过长按数字表冠来重置头部框架到当前位置。

手腕和手指追踪则通过HandTrackingProvider实现。它能够追踪左右手腕相对于地面框架的位置和方向,以及每只手25个手指关节相对于手腕框架的姿态。

网络通信方面,这个App使用gRPC作为网络通信协议来流式传输数据。这使得数据能被更多设备订阅,包括Linux、Mac和Windows设备。

另外,为了方便数据传输,作者小哥还准备了一个Python API,让开发者能够通过编程方式订阅和接收从Vision Pro流式传输的追踪数据。

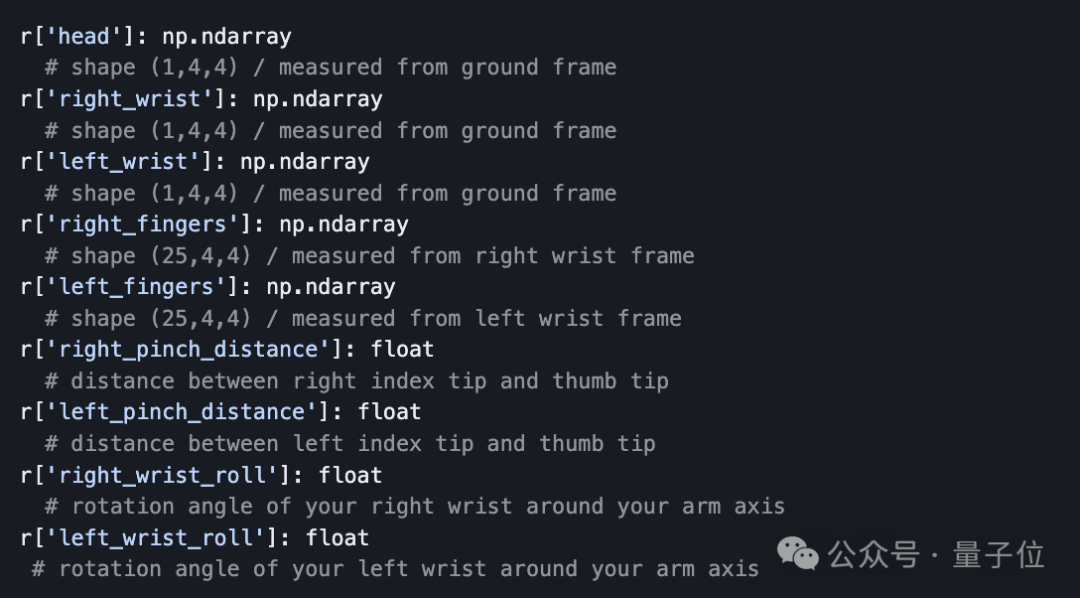

API返回的数据是字典形式,包含头部、手腕、手指的SE(3)姿态信息,即三维位置和方向。开发者可以直接在Python中处理这些数据,用于对机器人的进一步分析和控制。

就像不少专业人士所指出的那样,别看机器狗的动作还是由人类控制,事实上,相比于“操控”本身,结合模仿学习算法,人类在这个过程中,更像是机器人的教练。

而Vision Pro通过追踪用户的动作,提供了一种直观、简单的交互方式,使得非专业人员也能够为机器人提供精准的训练数据。

作者本人也在论文中写道:

在不久的将来,人们可能会像日常戴眼镜一样佩戴Vision Pro这样的设备,想象一下我们可以从这个过程中收集多少数据!

这是一个充满前景的数据源,机器人可以从中学习到,人类是如何与现实世界交互的。

最后,提醒一下,如果你想上手试一试这个开源项目,那么除了必备一台Vision Pro之外,还需要准备:

- 苹果开发者账户

- Vision Pro开发者配件(Developer Strap,售价299美元)

- 安装了Xcode的Mac电脑

嗯,看样子还是得先让苹果赚一笔了(doge)。

项目链接:https://github.com/Improbable-AI/VisionProTeleop?tab=readme-ov-file

以上是用Vision Pro实时训练机器狗!MIT博士生开源项目火了的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

抛弃编码器-解码器架构,用扩散模型做边缘检测效果更好,国防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

抛弃编码器-解码器架构,用扩散模型做边缘检测效果更好,国防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

当前的深度边缘检测网络通常采用编码器-解码器架构,其中包含上下采样模块,以更好地提取多层次的特征。然而,这种结构限制了网络输出准确且细致的边缘检测结果。针对这一问题,一篇AAAI2024上的论文给出了新的解决方案。论文题目:DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection作者:叶云帆(国防科技大学),徐凯(国防科技大学),黄雨行(国防科技大学),易任娇(国防科技大学),蔡志平(国防科技大学)论文链接:https://ar

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

0.这篇文章干了啥?提出了DepthFM:一个多功能且快速的最先进的生成式单目深度估计模型。除了传统的深度估计任务外,DepthFM还展示了在深度修复等下游任务中的最先进能力。DepthFM效率高,可以在少数推理步骤内合成深度图。下面一起来阅读一下这项工作~1.论文信息标题:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

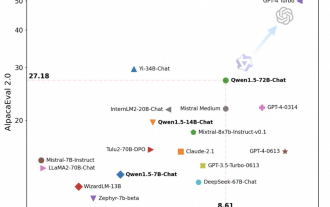

通义千问再开源,Qwen1.5带来六种体量模型,性能超越GPT3.5

Feb 07, 2024 pm 10:15 PM

通义千问再开源,Qwen1.5带来六种体量模型,性能超越GPT3.5

Feb 07, 2024 pm 10:15 PM

赶在春节前,通义千问大模型(Qwen)的1.5版上线了。今天上午,新版本的消息引发了AI社区关注。新版大模型包括六个型号尺寸:0.5B、1.8B、4B、7B、14B和72B。其中,最强版本的性能超越了GPT3.5和Mistral-Medium。该版本包含Base模型和Chat模型,并提供多语言支持。阿里通义千问团队表示,相关技术也已经上线到了通义千问官网和通义千问App。除此以外,今天Qwen1.5的发布还有如下一些重点:支持32K上下文长度;开放了Base+Chat模型的checkpoint;

大模型也能切片,微软SliceGPT让LLAMA-2计算效率大增

Jan 31, 2024 am 11:39 AM

大模型也能切片,微软SliceGPT让LLAMA-2计算效率大增

Jan 31, 2024 am 11:39 AM

大型语言模型(LLM)通常拥有数十亿参数,经过数万亿token的数据训练。然而,这样的模型训练和部署成本都非常昂贵。为了降低计算需求,人们常常采用各种模型压缩技术。这些模型压缩技术一般可以分为四类:蒸馏、张量分解(包括低秩因式分解)、剪枝和量化。剪枝方法已经存在一段时间,但许多方法需要在剪枝后进行恢复微调(RFT)以保持性能,这使得整个过程成本高且难以扩展。苏黎世联邦理工学院和微软的研究者提出了一个解决此问题的方法,名为SliceGPT。该方法的核心思想是通过删除权重矩阵中的行和列来降低网络的嵌

更新版 Point Transformer:更高效、更快速、更强大!

Jan 17, 2024 am 08:27 AM

更新版 Point Transformer:更高效、更快速、更强大!

Jan 17, 2024 am 08:27 AM

原标题:PointTransformerV3:Simpler,Faster,Stronger论文链接:https://arxiv.org/pdf/2312.10035.pdf代码链接:https://github.com/Pointcept/PointTransformerV3作者单位:HKUSHAILabMPIPKUMIT论文思路:本文无意在注意力机制内寻求创新。相反,它侧重于利用规模(scale)的力量,克服点云处理背景下准确性和效率之间现有的权衡。从3D大规模表示学习的最新进展中汲取灵感,

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

什么?疯狂动物城被国产AI搬进现实了?与视频一同曝光的,是一款名为「可灵」全新国产视频生成大模型。Sora利用了相似的技术路线,结合多项自研技术创新,生产的视频不仅运动幅度大且合理,还能模拟物理世界特性,具备强大的概念组合能力和想象力。数据上看,可灵支持生成长达2分钟的30fps的超长视频,分辨率高达1080p,且支持多种宽高比。另外再划个重点,可灵不是实验室放出的Demo或者视频结果演示,而是短视频领域头部玩家快手推出的产品级应用。而且主打一个务实,不开空头支票、发布即上线,可灵大模型已在快影

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂炼大模型,一互联网的数据不够用,根本不够用。训练模型搞得跟《饥饿游戏》似的,全球AI研究者,都在苦恼怎么才能喂饱这群数据大胃王。尤其在多模态任务中,这一问题尤为突出。一筹莫展之际,来自人大系的初创团队,用自家的新模型,率先在国内把“模型生成数据自己喂自己”变成了现实。而且还是理解侧和生成侧双管齐下,两侧都能生成高质量、多模态的新数据,对模型本身进行数据反哺。模型是啥?中关村论坛上刚刚露面的多模态大模型Awaker1.0。团队是谁?智子引擎。由人大高瓴人工智能学院博士生高一钊创立,高