Vision Pro 又现火爆新玩法,这回还和具身智能联动了 ~

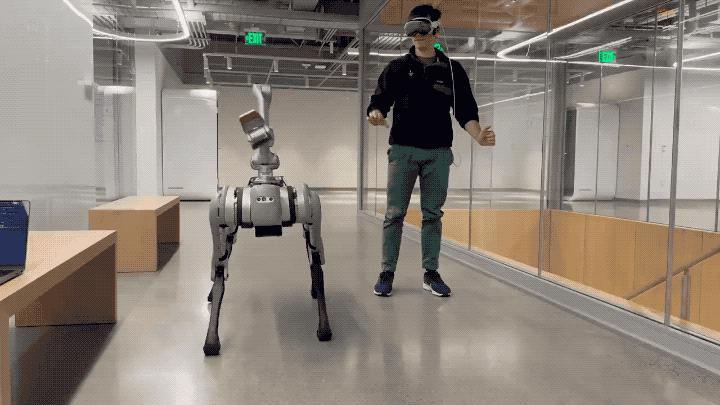

就像这样,MIT 小哥利用 Vision Pro 的手部追踪功能,成功实现了对机器狗的实时控制。

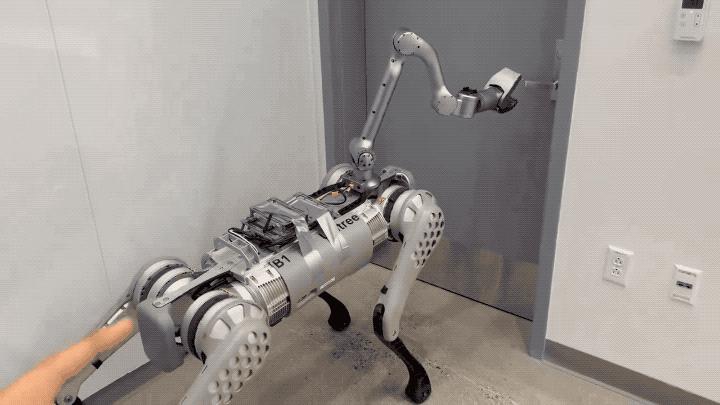

不仅开门这样的动作能精准 get:

也几乎没什么延时。

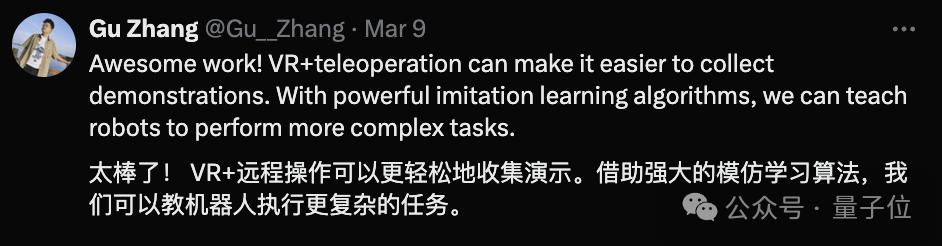

Demo 一出,不仅网友们大赞鹅妹子嘤,各路具身智能研究人员也嗨了。

比如这位准清华叉院博士生:

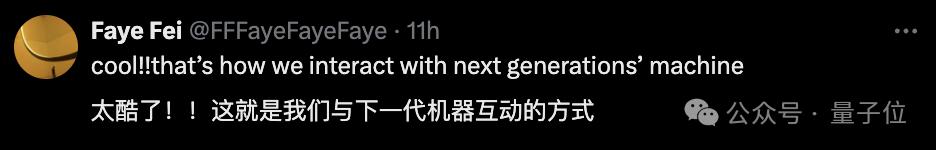

还有人大胆预测:这就是我们与下一代机器互动的方式。

具体来看看作者小哥开发的 App ——Tracking Steamer。

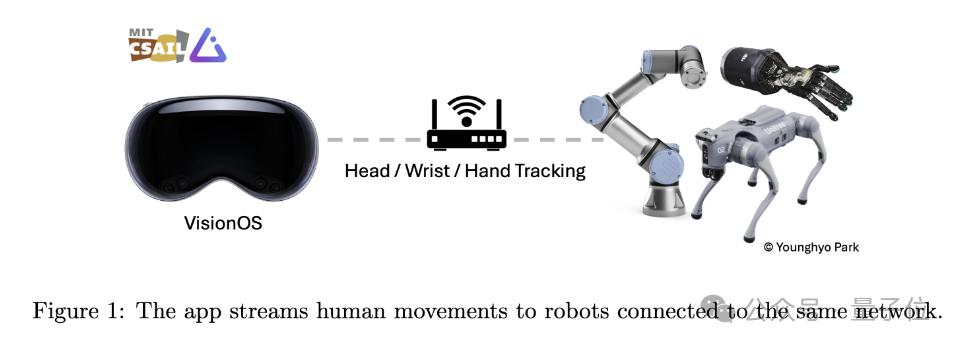

顾名思义,这个应用程序旨在利用 Vision Pro 追踪人类动作,并将这些动作数据实时传输到同一 WiFi 下的其他机器人设备上。

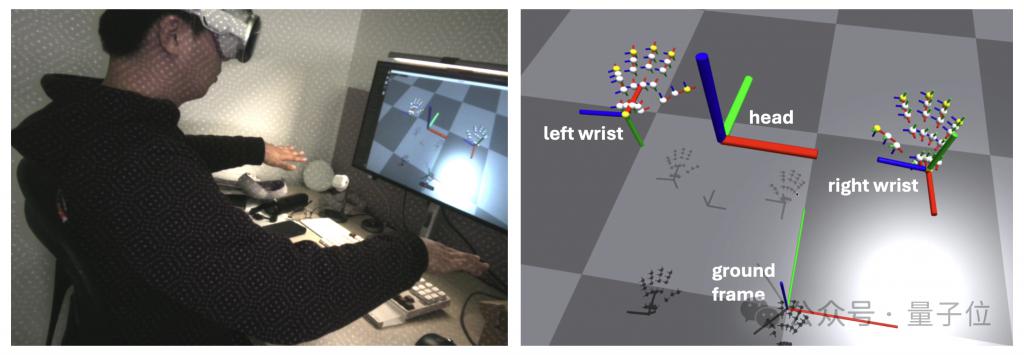

动作追踪的部分,主要依靠苹果的 ARKit 库来实现。

其中头部追踪调用的是 queryDeviceAnchor。用户可以通过长按数字表冠来重置头部框架到当前位置。

手腕和手指追踪则通过 HandTrackingProvider 实现。它能够追踪左右手腕相对于地面框架的位置和方向,以及每只手 25 个手指关节相对于手腕框架的姿态。

网络通信方面,这个 App 使用 gRPC 作为网络通信协议来流式传输数据。这使得数据能被更多设备订阅,包括 Linux、Mac 和 Windows 设备。

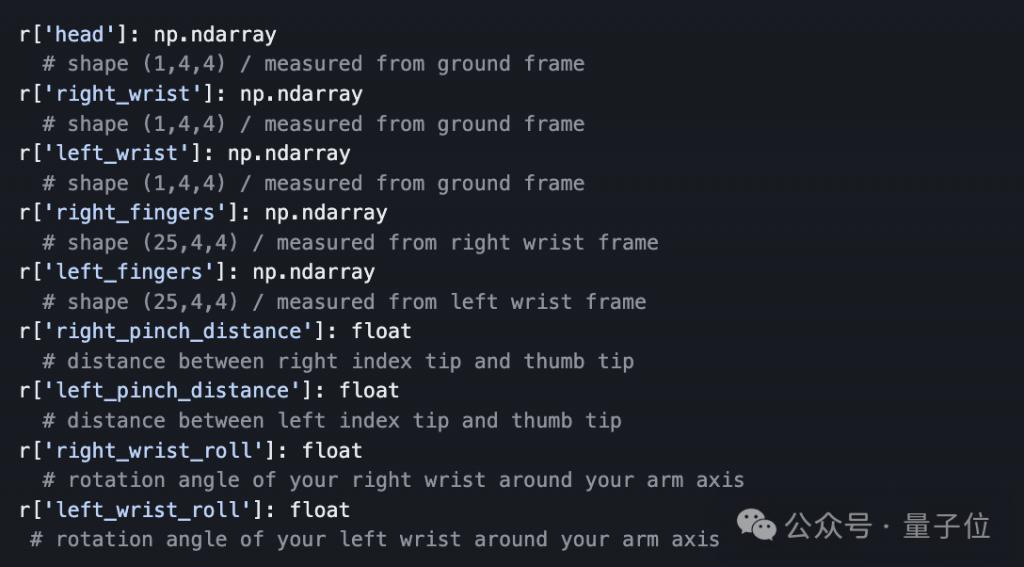

另外,为了方便数据传输,作者小哥还准备了一个 Python API,让开发者能够通过编程方式订阅和接收从 Vision Pro 流式传输的追踪数据。

API 返回的数据是字典形式,包含头部、手腕、手指的 SE ( 3 ) 姿态信息,即三维位置和方向。开发者可以直接在 Python 中处理这些数据,用于对机器人的进一步分析和控制。

就像不少专业人士所指出的那样,别看机器狗的动作还是由人类控制,事实上,相比于 " 操控 " 本身,结合模仿学习算法,人类在这个过程中,更像是机器人的教练。

而 Vision Pro 通过追踪用户的动作,提供了一种直观、简单的交互方式,使得非专业人员也能够为机器人提供精准的训练数据。

作者本人也在论文中写道:

在不久的将来,人们可能会像日常戴眼镜一样佩戴 Vision Pro 这样的设备,想象一下我们可以从这个过程中收集多少数据!

这是一个充满前景的数据源,机器人可以从中学习到,人类是如何与现实世界交互的。

最后,提醒一下,如果你想上手试一试这个开源项目,那么除了必备一台 Vision Pro 之外,还需要准备:

苹果开发者账户

Vision Pro 开发者配件(Developer Strap,售价 299 美元)

安装了 Xcode 的 Mac 电脑

嗯,看样子还是得先让苹果赚一笔了(doge)。

项目链接:

https://github.com/Improbable-AI/VisionProTeleop?tab=readme-ov-file

参考链接:

https://twitter.com/younghyo_park/status/1766274298422161830

以上是用 Vision Pro 实时训练机器狗!MIT 博士生开源项目火了的详细内容。更多信息请关注PHP中文网其他相关文章!