问题排查太烦心,试试GPT的超能力

使用 Kubernetes 时难免会遇到集群中的问题,需要进行调试和修复,以确保 Pod 和服务能够正常运行。无论你是初学者还是处理复杂环境的专家,调试集群内的进程并不总是易事,可能会变得耗时且繁琐。 在 Kubernetes 中,诊断问题的关键是了解各个组件之间的关系,以及它们如何相互作用。日志记录和监控工具是解决问题的关键,可以帮助你快速定位并解决故障。另外,深入了解 Kubernetes 资源配置和调度机制也是解决问题的重要一环。 当面对问题时,首先要确保你的集群和应用程序的配置是正确的。随后,通过查看日志、监控指标和事件,来定位问题的根源。有时候问题可能涉及到网络配置、存储问题或者是应用程序本身的 bug,需要仔

在云原生环境中,有多种调试解决方案可供选择,可以帮助您轻松访问集群内的信息。但需要注意的是,大部分解决方案并未提供完整的上下文信息。

在这篇博文中,我将向你介绍K8sGPT,这个项目旨在为所有人提供 Kubernetes 的超能力。

K8sGPT 的应用场景

K8sGPT 的应用场景

概述

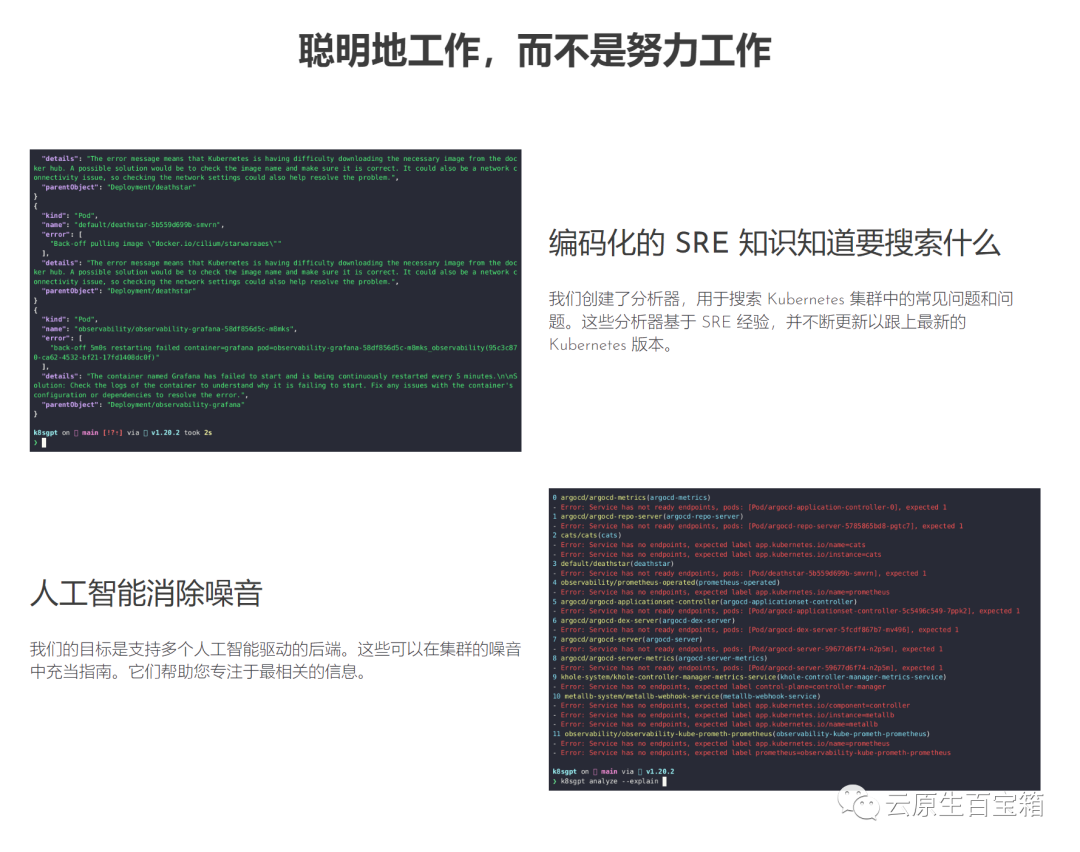

K8sGPT是一项完全开源的项目,由一群经验丰富的云原生生态系统工程师于2023年4月发起。该项目的核心理念是利用人工智能模型,为Kubernetes错误消息和集群洞见提供详尽且情境化的解释。

图片

图片

此项目已被两个组织采用并申请成为 CNCF 沙箱项目。该项目的远景是为 Kubernetes 打造面向任务的机器学习模型。

该项目已经支持多种安装选项和不同的人工智能后端。在这篇文章中,我将向您介绍如何安装和开始使用 K8sGPT、CLI 工具和 Operator,以及 K8sGPT 如何支持其他集成。

安装

根据你的偏好和操作系统,有多种安装选项可用。你可以在K8sGPT文档的安装部分找到不同的选项。

如下所述安装 K8sGPT 的先决条件是在 Mac 上安装Homebrew或在 Windows 计算机上安装 WSL。

接下来,你可以运行以下命令:

brew tap k8sgpt-ai/k8sgptbrew install k8sgpt

其他安装选项

基于 RPM 的安装 (RedHat/CentOS/Fedora)

32位:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.rpmsudo rpm -ivh k8sgpt_386.rpm

64 位:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.rpmsudo rpm -ivh -i k8sgpt_amd64.rpm

基于 DEB 的安装 (Ubuntu/Debian)

32位:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.debsudo dpkg -i k8sgpt_386.deb

64 位:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.debsudo dpkg -i k8sgpt_amd64.deb

要验证 K8sGPT 是否安装正确,你可以检查安装的版本:

k8sgpt versionk8sgpt: 0.3.6 (9c0efe6), built at: unknown

K8sGPT CLI

要查看 K8sGPT 提供的所有命令,请使用 --help 标志:

k8sgpt --help

接下来,我们必须授权AI后端。在本文中,我们将使用 OpenAI。

先决条件

遵循下一节的先决条件是拥有一个OpneAI 帐户和一个正在运行的 Kubernetes 集群,例如 microk8s 或 minikube 就足够了。

拥有 OpneAI 帐户后,你需要访问这个地址https://platform.openai.com/account/api-keys生成新的 API 密钥

或者,你可以运行以下命令,K8sGPT 将在默认浏览器中打开同一地址:

k8sgpt generate

K8sGPT 与 OpenAI 交互需要此密钥。使用新创建的 API 密钥/令牌授权 K8sGPT:

k8sgpt auth add openaiEnter openai Key: openai added to the AI backend provider list

你可以使用以下命令列出你的后端:

k8sgpt auth listDefault:> openaiActive:> openaiUnused:> localai> azureopenai> noopai

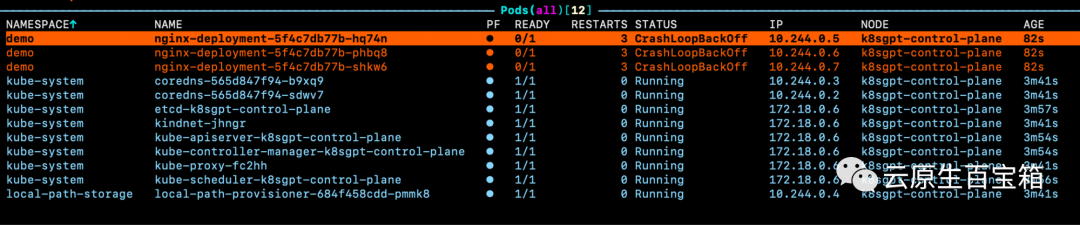

接下来,我们将在 Kubernetes 集群中部署一个异常的Deployment,Pod 将成为CrashLoopBackOff状态。以下是 YAML:

apiVersion: apps/v1kind: Deploymentmetadata:name: nginx-deploymentlabels:app: nginxspec:replicas: 3selector:matchLabels:app: nginxtemplate:metadata:labels:app: nginxspec:containers:- name: nginximage: nginx:1.14.2ports:- containerPort: 80securityContext:readOnlyRootFilesystem: true

接下来,我们将为示例应用程序创建demo命名空间并安装部署:

kubectl create ns demonamespace/demo createdkubectl apply -f ./deployment.yaml -n demodeployment.apps/nginx-deployment created

现在你将看到我们的演示命名空间中的 Pod 抛出错误:

图片

图片

如果我们查看其中一个 pod 的事件,但是我们不知道具体问题原因:

WarningBackOff 3s (x8 over 87s)kubelet Back-off restarting failed container

因此,我们可以运行 K8sGPT 命令来访问有关这些 pod 出错原因的更多详细信息:

k8sgpt analyse

这将向我们展示 k8sGPT 在集群中发现的问题:

AI Provider: openai0 demo/nginx-deployment-5f4c7db77b-hq74n(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-hq74n_demo(7854b793-21b7-4f81-86e5-dbb4113f64f4)1 demo/nginx-deployment-5f4c7db77b-phbq8(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-phbq8_demo(74038531-e362-45a6-a436-cf1a6ea46d8a)2 demo/nginx-deployment-5f4c7db77b-shkw6(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-shkw6_demo(2603f332-3e1c-45da-8080-e34dd6d956ad)

要接收更多信息以及有关如何解决问题的建议,我们可以使用以下--explain标志:

k8sgpt analyse --explain

附加功能

根据你的集群大小和 K8sGPT 在集群中识别的问题数量,你还可以按特定命名空间和工作负载类型进行过滤。

此外,如果你或你的组织担心 OpenAI 或其他后端接收有关你的工作负载的敏感信息,你可以使用--anonymize规避应用的敏感信息。

与其他工具的集成

云原生生态系统中大多数工具的价值源于它们与其他工具的集成程度。

在撰写本文时,K8sGPT 提供了与 Gafana 和 Prometheus 等可观察性工具的轻松集成。此外,还可以为 K8sGPT 编写插件。维护者提供的第一个插件是Trivy,一个一体化的云原生安全扫描器。

你可以使用以下命令列出所有可用的集成:

k8sgpt integration listActive:Unused:> trivy

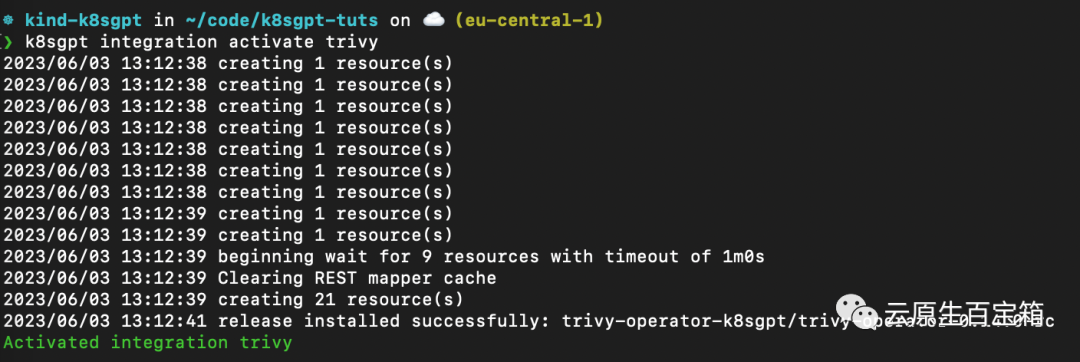

接下来,我们要激活 Trivy 集成:

k8sgpt integration activate trivy

这将在集群内安装 Trivy Operator(如果尚未安装):

图片

图片

激活集成后,我们可以通过 k8sgpt 过滤器,使用 Trivy 创建的漏洞报告作为 K8sGPT 分析的一部分:

❯ k8sgpt filters listActive:> Pod> VulnerabilityReport (integration)Unused:> Deployment> ReplicaSet> Node> Service> Ingress> StatefulSet> CronJob> PersistentVolumeClaim> HorizontalPodAutoScaler> PodDisruptionBudget> NetworkPolicy

过滤器对应于 k8sgpt 代码中的特定分析器。分析器仅查看相关信息,例如最关键的漏洞。

要使用 VulnerabilityReport 过滤器,请使用以下命令:

k8sgpt analyse --filter=VulnerabilityReport

(FIXME)与之前类似,我们也可以要求 K8sGPT 对扫描提供进一步的解释:

k8sgpt analyse --filter=VulnerabilityReport --explain

K8sGPT Operator

虽然 CLI 工具为集群管理员提供了对其基础设施和工作负载执行即席扫描的功能,但 K8sGPT Operator 在集群中全天候 (24/7) 运行。它是 Kubernetes 原生的,这意味着它作为 Kubernetes 自定义资源运行,并生成作为 YAML 清单存储在集群中的报告。

要安装 Operator,请按照以下命令进行操作:

helm repo add k8sgpt https://charts.k8sgpt.ai/helm repo updatehelm install release k8sgpt/k8sgpt-operator -n k8sgpt-operator-system --create-namespace

如果你想将 K8sGPT 与 Prometheus 和 Grafana 集成,你可以通过向上面的安装提供values.yaml 清单来使用略有不同的安装:

serviceMonitor:enabled: trueGrafanaDashboard:enabled: true

然后安装 Operator 或更新现有安装:

helm install release k8sgpt/k8sgpt-operator -n k8sgpt-operator-system --create-namespace --values values.yaml

在本例中,我们告诉 K8sGPT 还安装一个 ServiceMonitor,它将扫描报告中的指标发送到 Prometheus,并为 K8sGPT 创建一个仪表板。如果你使用了此安装,则还需要安装 kube-prometheus-stack Helm Chart 才能访问 Grafana 和 Prometheus。这可以通过以下命令来完成:

helm repo add prometheus-community https://prometheus-community.github.io/helm-chartshelm repo updatehelm install prom prometheus-community/kube-prometheus-stack -n k8sgpt-operator-system --set prometheus.prometheusSpec.serviceMonitorSelectorNilUsesHelmValues=false

此时,你应该在集群内运行 K8sGPT Operator 和 Prometheus Stack Helm Chart(也是 Kubernetes Operator)。

与我们需要向 CLI 提供 OpenAI API 密钥的方式类似,我们需要使用 API 密钥创建 Kubernetes 密钥。为此,请使用与之前相同的密钥,或者在你的 OpenAI 帐户上生成一个新密钥。

要生成 Kubernetes 密钥,请将你的 OpenAI 密钥粘贴到以下命令中:

export OPENAI_TOKEN=<your api key here>kubectl create secret generic k8sgpt-sample-secret --from-literal=openai-api-key=$OPENAI_TOKEN -n k8sgpt-operator-system</your>

然后,我们需要配置 K8sGPT Operator 以了解要使用哪个版本的 K8sGPT 以及哪个 AI 后端:

apiVersion: core.k8sgpt.ai/v1alpha1kind: K8sGPTmetadata:name: k8sgpt-samplespec:model: gpt-3.5-turbobackend: openainoCache: falseversion: v0.3.2enableAI: truesecret:name: k8sgpt-sample-secretkey: openai-api-key

现在,我们需要将此文件应用到我们的 K8sGPT 集群命名空间:

kubectl apply -f k8sgpt-resource.yaml -n k8sgpt-operator-system

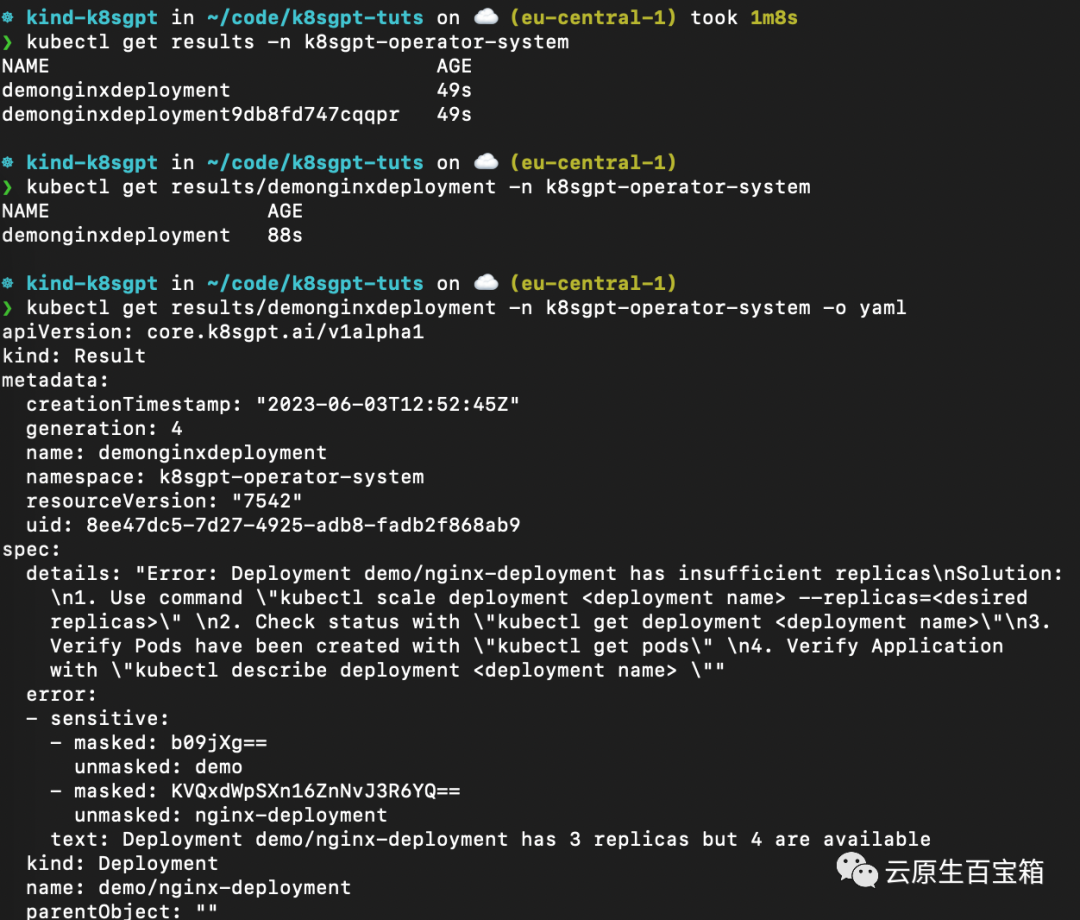

几秒钟内,Operator 将创建新结果:

kubectl get results -n k8sgpt-operator-system

以下是不同命令的屏幕截图,你可以按照这些命令从 K8sGPT Operator 查看结果报告:

从 K8sGPT Operator 查看结果报告

从 K8sGPT Operator 查看结果报告

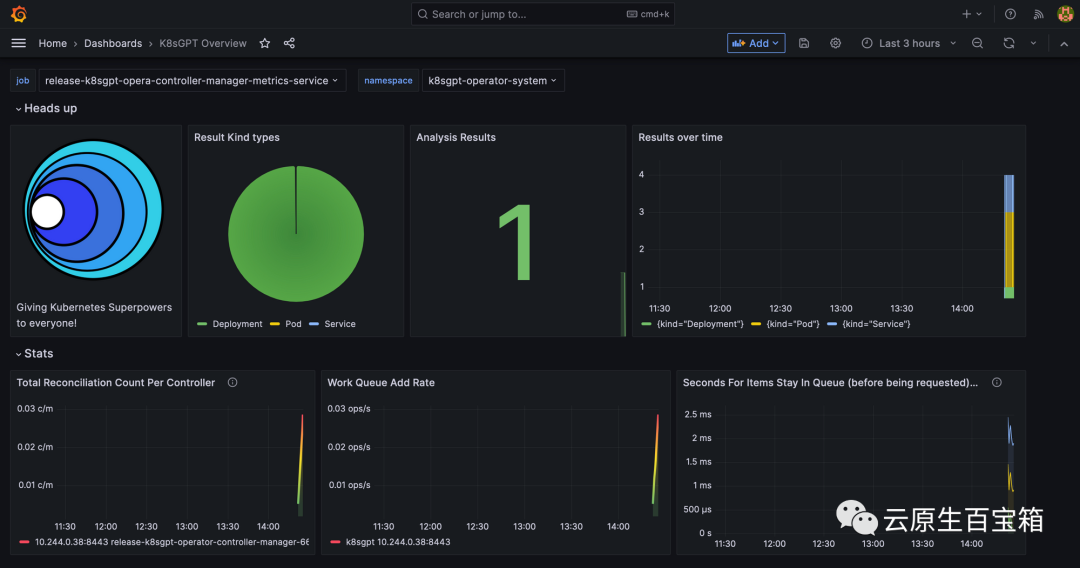

最后,我们将看一下 Grafana 仪表板。端口转发 Grafana 服务以通过 localhost 访问它:

kubectl port-forward service/prom-grafana -n prom 3000:80

打开 localhost:3000,然后导航到 Dashboards>K8sGPT Overview,然后你将看到包含结果的仪表板:

Grafana 中的 K8sGPT 仪表板

Grafana 中的 K8sGPT 仪表板

参考

- 1. https://k8sgpt.ai/

- 2. https://docs.k8sgpt.ai/

- 3. https://github.com/k8sgpt-ai

以上是问题排查太烦心,试试GPT的超能力的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Kubernetes调试终极武器: K8sGPT

Feb 26, 2024 am 11:40 AM

Kubernetes调试终极武器: K8sGPT

Feb 26, 2024 am 11:40 AM

随着人工智能和机器学习技术的不断发展,企业和组织开始积极探索创新战略,以利用这些技术来提升竞争力。K8sGPT[2]是该领域内功能强大的工具之一,它是基于k8s的GPT模型,兼具k8s编排的优势和GPT模型出色的自然语言处理能力。什么是K8sGPT?先看一个例子:根据K8sGPT官网解释:K8sgpt是一个专为扫描、诊断和分类kubernetes集群问题而设计的工具,它整合了SRE经验到其分析引擎中,以提供最相关的信息。通过人工智能技术的应用,K8sgpt不断丰富其内容,帮助用户更快速、准确地解

win7硬盘格式应该选择MBR还是GPT?

Jan 03, 2024 pm 08:09 PM

win7硬盘格式应该选择MBR还是GPT?

Jan 03, 2024 pm 08:09 PM

我们在使用win7操作系统的时候,有的情况下可能就会遇到需要我们重装系统,为硬盘分区的情况。对于win7硬盘格式要求mbr还是gpt这种问题小编觉得,还是要根据自己系统以及硬件配置的详细情况来进行选择即可。如果按兼容性来说的话最好还是选择mbr格式。详细内容还是来看下小编是怎么做的吧~win7硬盘格式要求mbr还是gpt1.如果系统装的是Win7的话,建议还是MBR,兼容性好。2.超过3T或装win8,可以用GPT。3.虽然GPT确实比MBR先进,但兼容性方面肯定是MBR无敌。GPT和MBR的区

深入了解Win10分区格式:GPT和MBR的比较

Dec 22, 2023 am 11:58 AM

深入了解Win10分区格式:GPT和MBR的比较

Dec 22, 2023 am 11:58 AM

对自己的系统分区时由于用户使用的硬盘不同因此很多的用户也不知道win10分区格式gpt还是mbr,为此我们给大家带来了详细的介绍,帮助大家了解两者间的不同。win10分区格式gpt还是mbr:答:如果你使用的是超过3t的硬盘,可以用gpt。gpt相比mbr更加的先进,但是兼容性方面还是mbr更厉害。当然这也是完全可以根据用户的喜好来进行选择的。gpt和mbr的区别:一、支持的分区个数:1、MBR最多支持划分4个主分区。2、GPT则不受分区个数的限制。二、支持的硬盘大小:1、MBR最大仅支持2TB

如何确定电脑硬盘采用的是GPT还是MBR分区方式

Dec 25, 2023 pm 10:57 PM

如何确定电脑硬盘采用的是GPT还是MBR分区方式

Dec 25, 2023 pm 10:57 PM

何查看电脑硬盘是GPT分区还是MBR分区呢?当我们用到电脑硬盘的时候,需要进行GPT与MBR的区分,其实这个查看方法特别简单,下面跟我一起来看看吧。查看电脑硬盘是GPT还是MBR的方法1、右击桌面上的'计算机“点击”管理2、在”管理“中找得”磁盘管理“3、进入磁盘管理可以看到我们硬盘的一般情况,那么该如何查看我的硬盘的分区模式,右击”磁盘0“选择”属性“4、在”属性“中切换到”卷“标签,这时我们就可以看到”磁盘分区形式“可以看到为MBR分区win10磁盘相关问题如何将MBR分区转换成GPT分区>

GPT大语言模型Alpaca-lora本地化部署实践

Jun 01, 2023 pm 09:04 PM

GPT大语言模型Alpaca-lora本地化部署实践

Jun 01, 2023 pm 09:04 PM

模型介绍Alpaca模型是斯坦福大学研发的LLM(LargeLanguageModel,大语言)开源模型,是一个在52K指令上从LLaMA7B(Meta公司开源的7B)模型微调而来,具有70亿的模型参数(模型参数越大,模型的推理能力越强,当然随之训练模型的成本也就越高)。LoRA,英文全称Low-RankAdaptationofLargeLanguageModels,直译为大语言模型的低阶适应,这是微软的研究人员为了解决大语言模型微调而开发的一项技术。如果想让一个预训练大语言模型能够执行特定领域

LLM的三大缺陷,你知道几个?

Nov 26, 2023 am 11:26 AM

LLM的三大缺陷,你知道几个?

Nov 26, 2023 am 11:26 AM

科学:远非是一种永远仁慈有益的实体,未来的感知通用AI很可能是一个操纵性反社会个体,它会吞噬你所有个人数据,然后在最需要它的时候就崩溃。译自3WaysLLMsCanLetYouDown,作者JoabJackson。OpenAI即将发布GPT-5,外界对它寄予厚望,最乐观的预测甚至认为它将实现通用人工智能。但与此同时,CEOSamAltman和他的团队在将其推向市场过程中面临许多严峻的障碍,他本月早些时候就已经承认了这一点。有一些最近发表的研究论文可能提供了对于Altman挑战的线索。这些论文总结

被比尔盖茨选中的GPT技术,是如何演进,又革谁的命?

May 28, 2023 pm 03:13 PM

被比尔盖茨选中的GPT技术,是如何演进,又革谁的命?

May 28, 2023 pm 03:13 PM

夕小瑶科技说原创作者|智商掉了一地、Python如果机器能够以类似于人类的方式进行理解和沟通,那会是怎样的情况?这一直是学界中备受关注的话题,而由于近些年来在自然语言处理的一系列突破,我们可能比以往任何时候都更接近实现这个目标。在这个突破的前沿领域,是GenerativePre-trainedTransformer(GPT)——专门针对自然语言处理任务设计的深度神经网络模型。它出色的表现和有效对话的能力使其成为该领域中使用最广泛且效果最好的模型之一,吸引了研究和工业界的广泛关注。在最近一篇详尽的

Crypto GPT是什么?为什么说3EX的Crypto GPT是币圈新入口

Jul 16, 2024 pm 04:51 PM

Crypto GPT是什么?为什么说3EX的Crypto GPT是币圈新入口

Jul 16, 2024 pm 04:51 PM

CryptoGPT是什么?为什么说3EX的CryptoGPT是币圈新入口?7月5日消息,3EXAI交易平台正式推出CryptoGPT,这是一个基于AI技术和大数据的创新项目,旨在为全球加密投资者提供全面、智能的信息查询和AI投资建议。CryptoGPT已收录CoinMarketCap排名前200的代币和上百个优质项目方信息,并计划持续扩展。通过CryptoGPT,用户可免费获取详尽的交易咨询报告和AI投资建议,实现信息咨询服务到智能策略创建及自动执行交易的全栈式闭环。目前,该服务已免费开放。有需