Mamba 是最近最火的模型之一,更是被业内认为可以有取代 Transformer 的潜力。今天介绍的这篇文章,探索了 Mamba 模型在时间序列预测任务上是否有效。本文首先给大家介绍 Mamba 的基础原理,再结合这篇文章探索在时间序列预测场景下 Mamba 是否有效。 Mamba 模型是一种基于深度学习的模型,它采用了自回归架构,可以在时间序列数据中捕捉到长期依赖关系。与传统的模型相比,Mamba 模型在时间序列预测任务上表现出色。 通过实验和对比分析,本文发现 Mamba 模型在时间序列预测任务上有很好的效果。它可以准确地预测未来的时间序列值,并且在长期依赖关系的捕捉上表现更好。 总结

论文标题:Is Mamba Effective for Time Series Forecasting?

下载地址:https://www.php.cn/link/f06d497659096949ed7c01894ba38694

Mamba是一种基于State Space Model的结构,但与RNN非常相似。Mamba相比Transformer,在训练阶段和inference阶段都有随序列长度线性增长的时间复杂度,运算效率取决于Transformer这种结构。

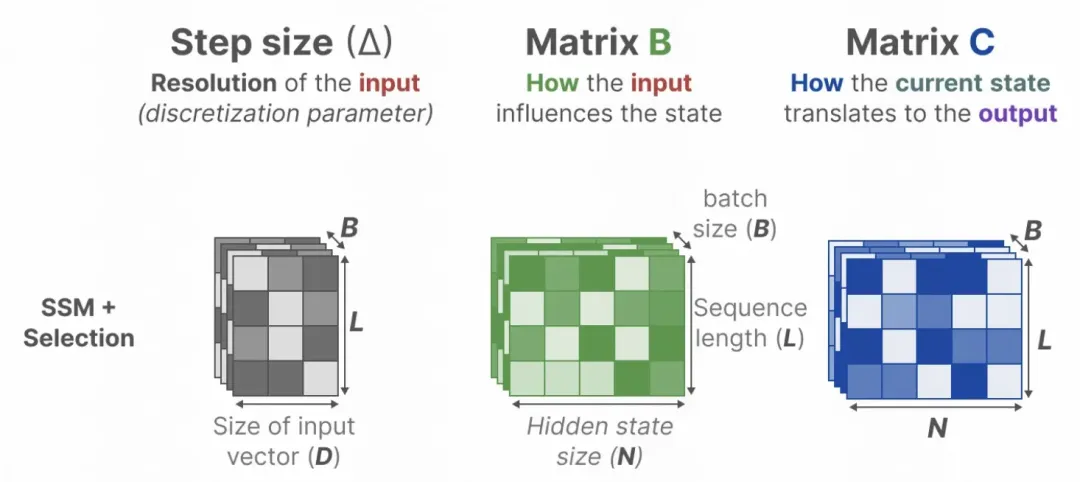

Mamba的核心可以分为以下4个部分:

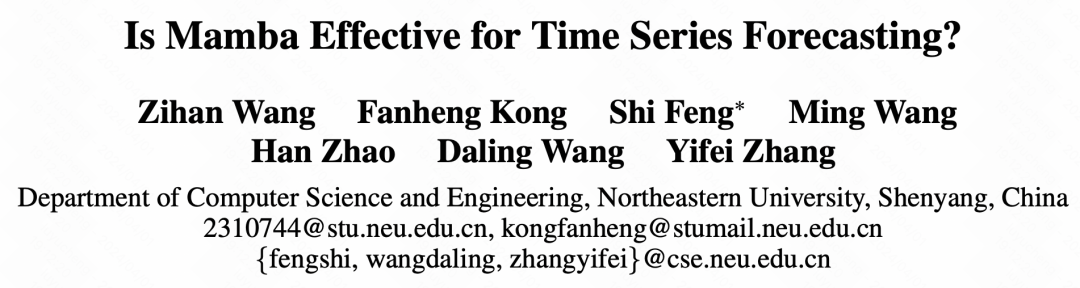

State Space Model(SSM)是一种用来刻画一个状态对当前状态的影响,以及当前状态对输出的影响的数学模型。在State Space Model中,假设上一个状态和当前时刻的输入会影响下一个状态,并且当前状态对输出的影响。SSM可以表示为如下形式,矩阵A、B、C、D为超参数。 矩阵A表示上一状态对当前状态的影响; 矩阵B表示当前时刻的输入会影响下一个状态; 矩阵C表示当前状态对输出的影响; 矩阵D表示当输入对输出的直接影响。 通过观测当前输出以及当前时刻的输入,可以推断出下一个状态的值。根据当前观测结果以及当时状态的决定的。SSM可以用于动态系统建模、状态估计和控制应用等领域。

图片

图片

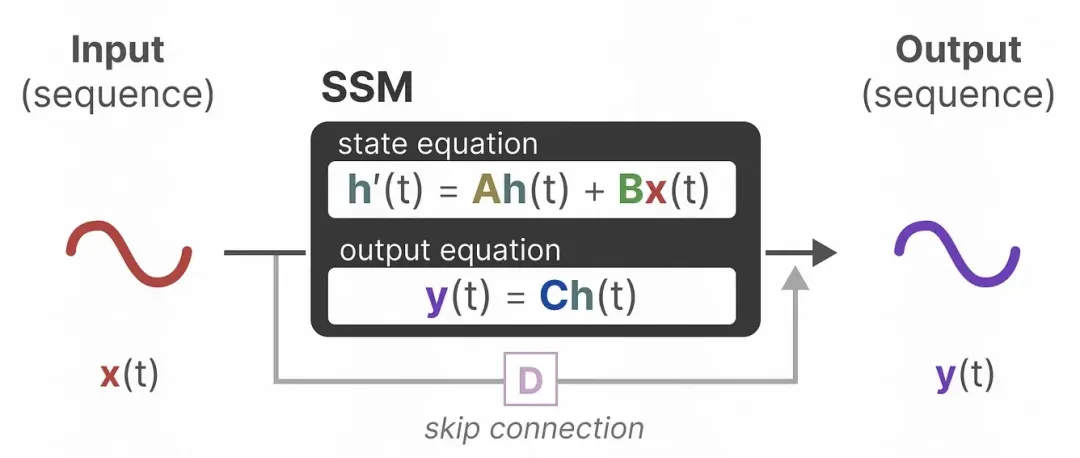

卷积表达:用卷积来表示SSM,实现训练阶段的并发计算,通过将SSM中的计算输出的公式按照时间展开,通过设计相应的卷积核到一定的形式,可以利用卷积来表达每个时刻的输出为前三个时刻输出的函数:

图片

图片

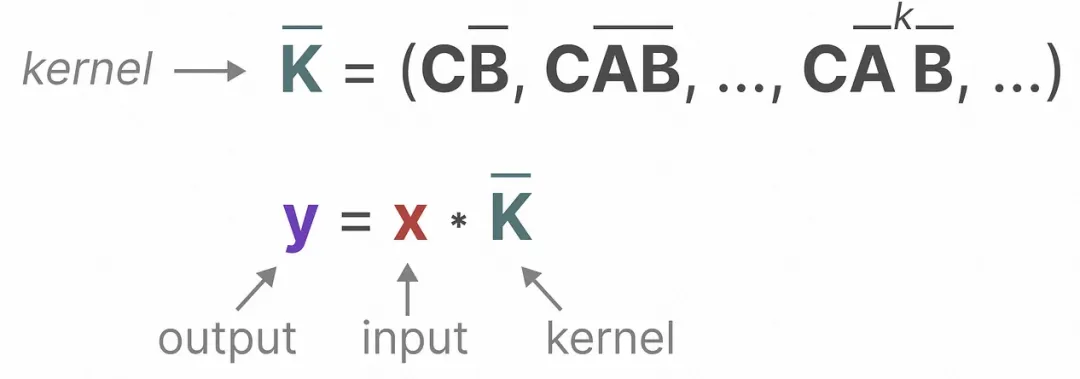

Hippo Matrix:对于参数A,引入Hippo Matrix实现对历史信息的衰减融合;

图片

图片

Selective模块:对于参数B和参数C个性化的矩阵实现对历史信息的个性化选择,将每个时刻的参数矩阵转换成关于输入的函数,实现每个时刻个性化的参数。

图片

图片

关于Mamba更详细的模型解析,以及后续的Mamba相关工作,也更新到了知识星球中,感兴趣的同学可以在星球中进一步深入学习。

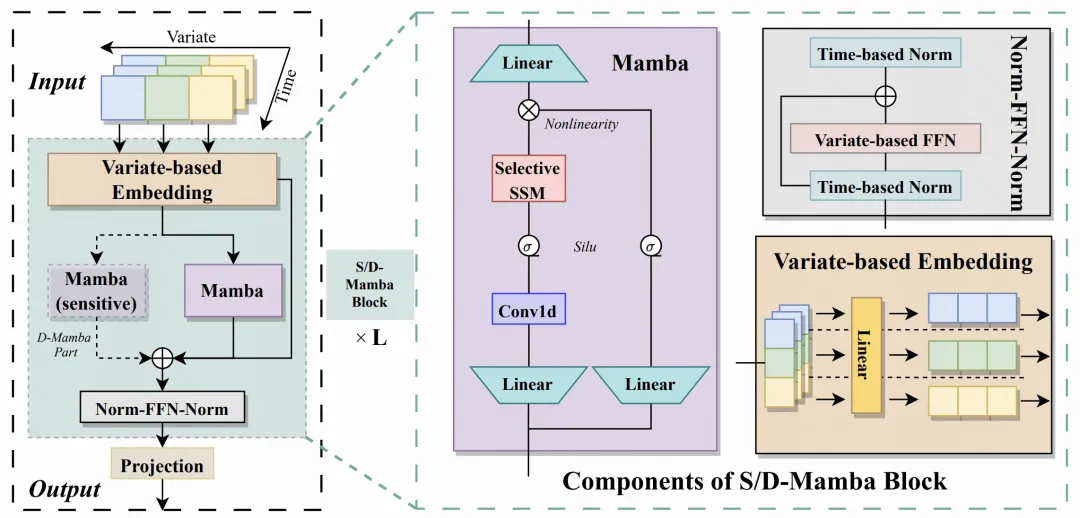

下面介绍一下这篇文章中提出的Mamba时间序列预测框架,整体基于Mamba,对时间序列数据进行适配。整体分为Embedding、S/D-Mamba layer、Norm-FFN-Norm Layer三个部分。

Embedding:类似iTransformer的处理方法,对每个变量单独进行映射,生成每个变量的embedding,再将每个变量的embedding输入到后续的Mamba中。因此本文也可以看成是对iTransformer的模型结构的一个改造,改成了Mamba结构;

S/D-Mamba layer:Embedding的输入维度为[batch_size, variable_number, dim],将其输入到Mamba中,文中探索了S和D两种Mamba层,分别表示每层用一个mamba还是两个mamba,两个mamba会将两个的输出相加得到每层的输出结果;

Norm-FFN-Norm Layer:在输出层,使用normalization层和FFN层对Mamba的输出表征进行归一化和映射,结合残差网络,提升模型收敛性和稳定性。

图片

图片

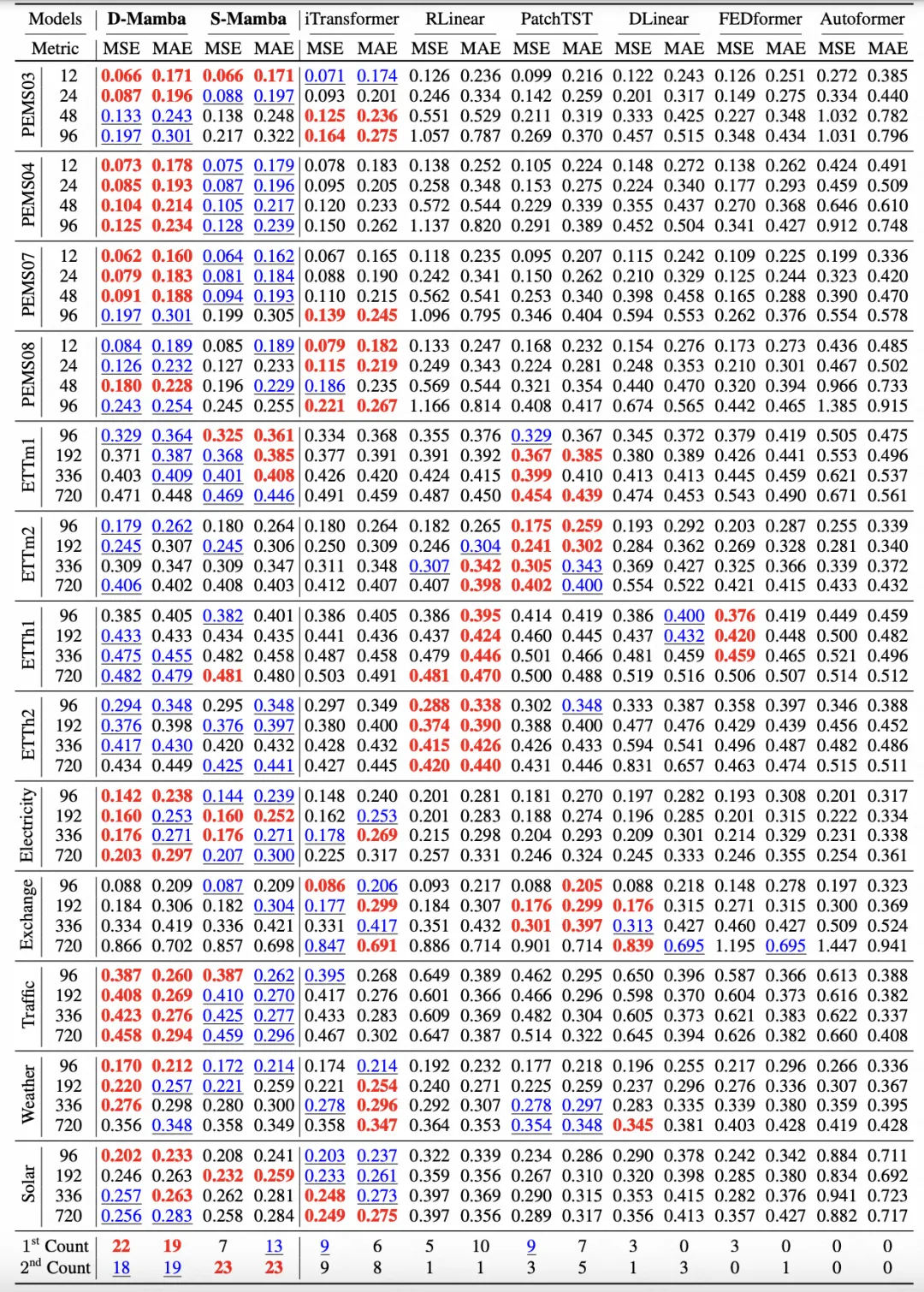

下图是文中的核心实验结果,对比了Mamba和iTransformer、PatchTST等业内主流时间序列模型的效果。文中还对不同的预测窗口、泛化性等进行了实验对比。实验表明,Mamba不仅在计算资源上有优势,在模型效果上也可以比肩Transformer相关的模型,并且在长周期的建模上也很有前景。

图片

图片

以上是比肩Transformer的Mamba在时间序列上有效吗?的详细内容。更多信息请关注PHP中文网其他相关文章!