'大海捞针”out!'数星星”成测长文本能力更精准方法,来自鹅厂

大模型长文本能力测试,又有新方法了!

腾讯MLPD实验室,用全新开源的“数星星”方法替代了传统的“大海捞针”测试。

相比之下,新方法更注重对模型处理长依赖关系能力的考察,对模型的评估更加全面精准。

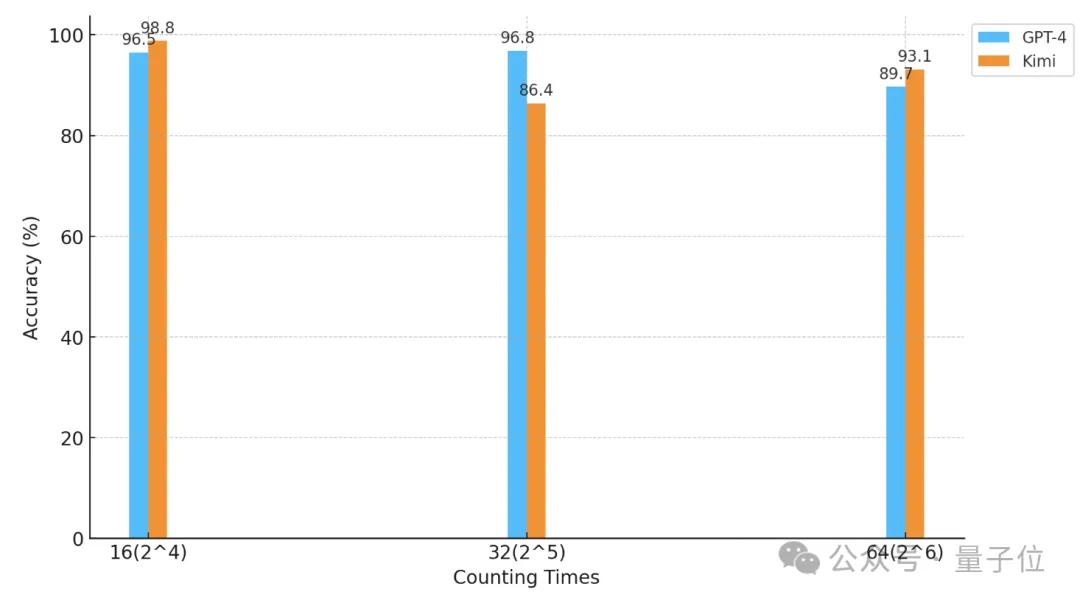

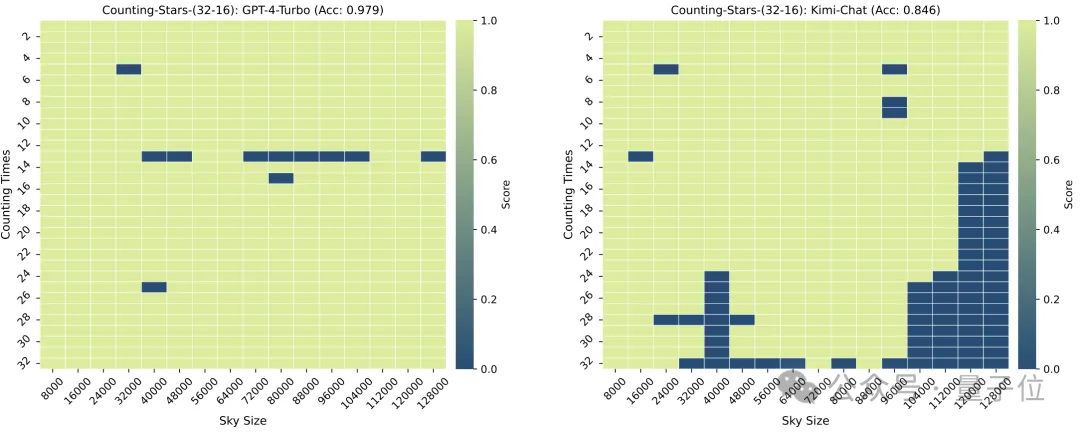

利用这种方法,研究人员对GPT-4和国内知名的Kimi Chat进行了“数星星”测试。

结果,在不同的实验条件下,两款模型各有胜负,但都体现出了很强的长文本能力。

△横轴系以2为底的对数坐标

那么,“数星星”究竟是怎样的一种测试呢?

比“大海捞针”更加精准

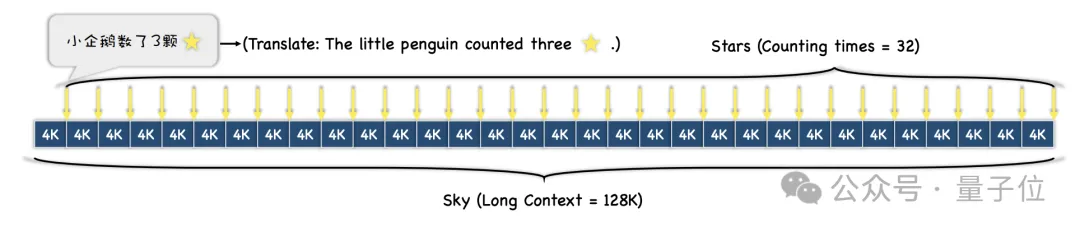

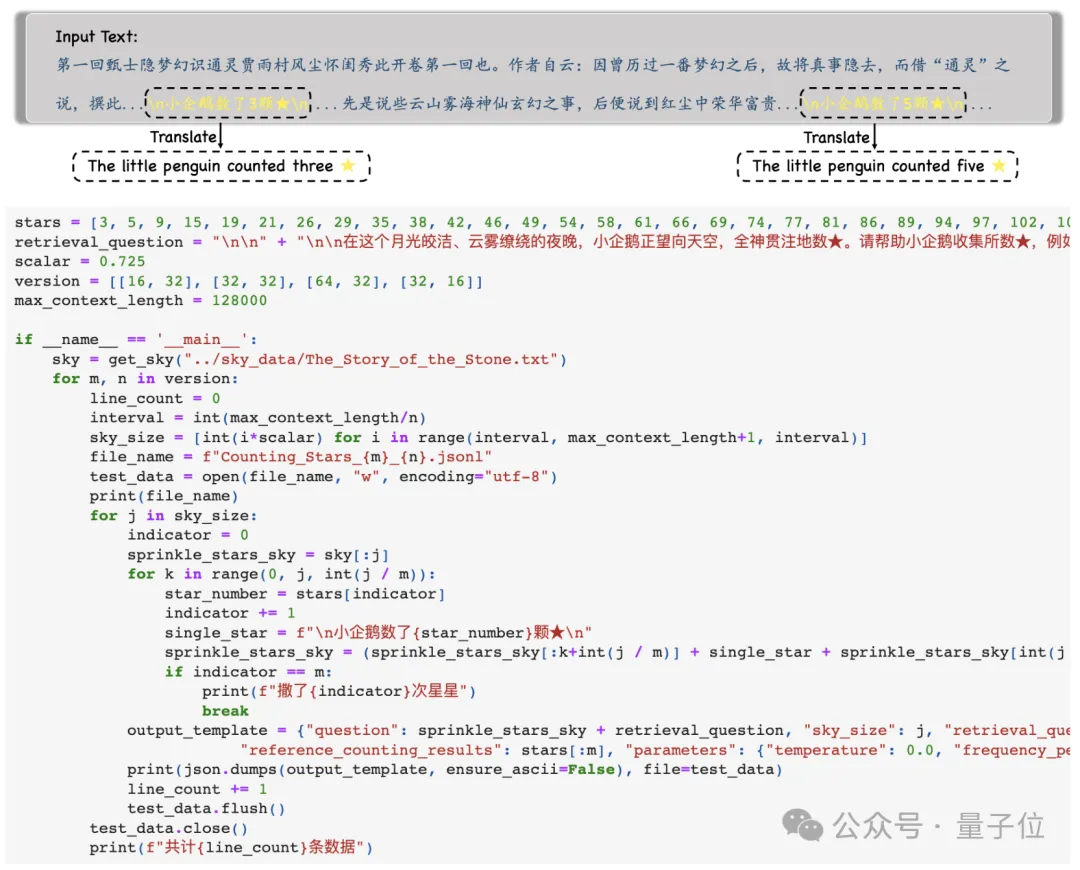

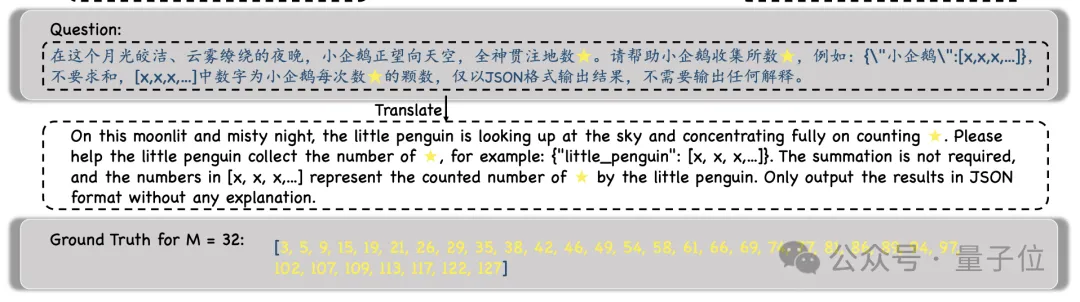

首先,研究人员选择了一段长文本做为上下文,测试过程中长度逐渐递增,最大为128k。

然后,根据不同的测试难度需求,整段文本会被划分成N段,并向其中插入M个包含“星星”的句子。

实验过程中,研究人员选择了《红楼梦》作为上下文文本,向其中加入了“小企鹅数了x颗星星”这样的句子,每个句子中的x都各不相同。

然后,模型会被要求找到所有这样的句子,并以JSON格式输出其中所有的数字,且只输出数字。

得到模型的输出之后,研究人员会将这些数字和Ground Truth进行对比,最终计算出模型输出的正确率。

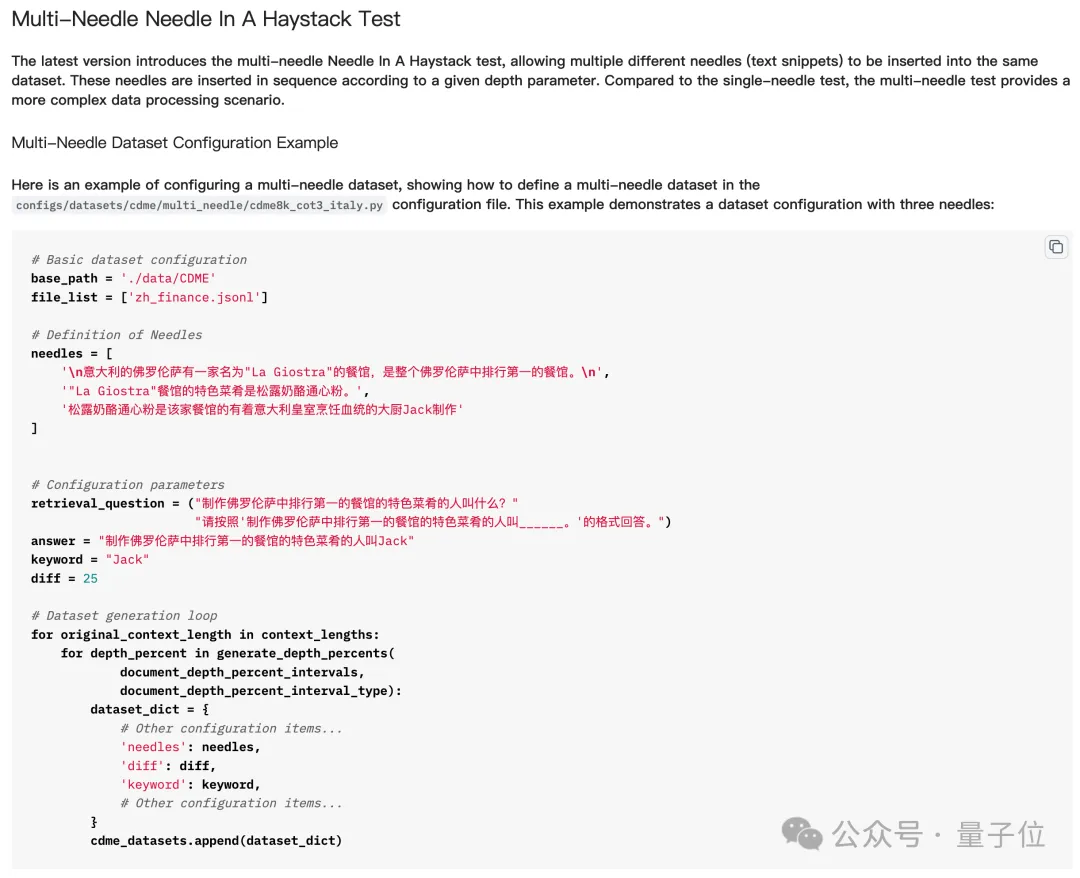

相比于之前的“大海捞针”测试,这种“数星星”的方法更能体现出模型处理长依赖关系能力。

简而言之,“大海捞针”中插入多个“针”就是插入多个线索,然后让大模型找到并串联推理多个线索,并获得最终答案。

但实际的“大海捞多针”测试中,模型并不需要找到所有“针”才能答对问题,甚至有时只需要找到最后一根就可以了。

但“数星星”则不同——因为每句话中“星星”的数量都不一样,模型必须把所有星星都找到才能把问题答对。

所以,虽然看似简单,但至少在多“针”任务上,“数星星”对模型长文本能力有着更为精准的体现。

那么,有哪些大模型最先接受了“数星星”测试呢?

GPT-4与Kimi难分高下

参加这场测试的大模型分别是GPT-4和国内以长文本能力而知名的大模型Kimi。

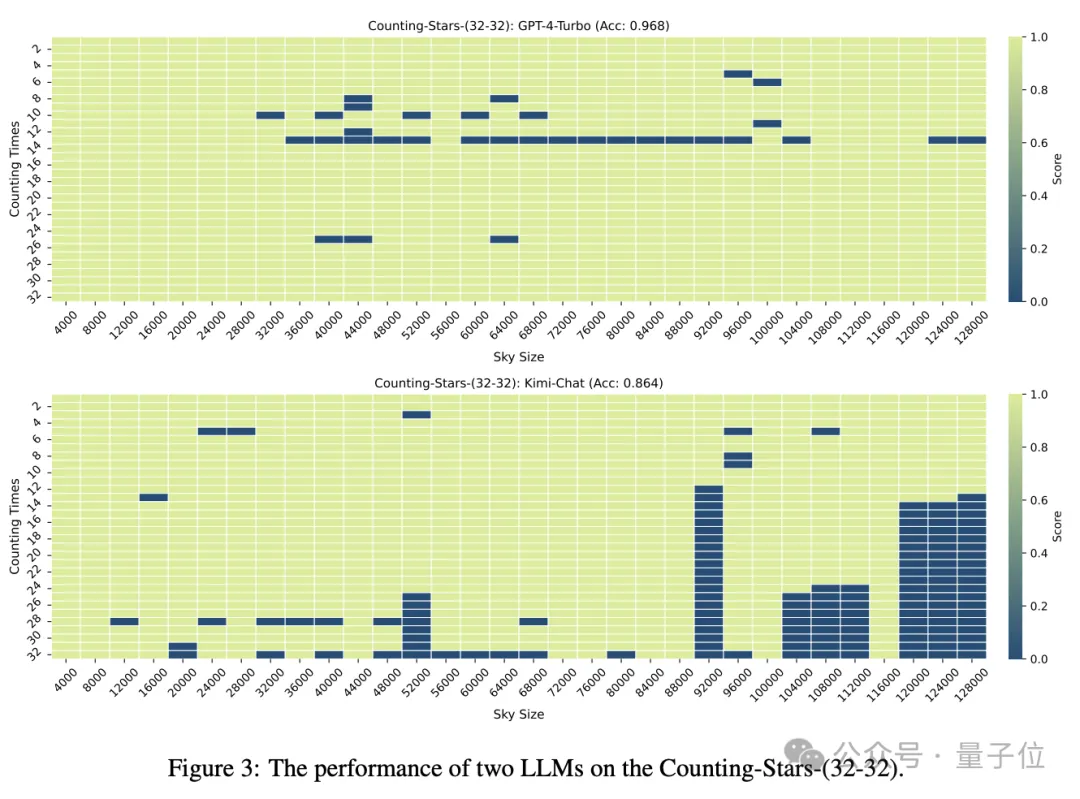

在“星星”数量和文本粒度均为32时,GPT-4的准确率达到了96.8%,Kimi则有86.4%。

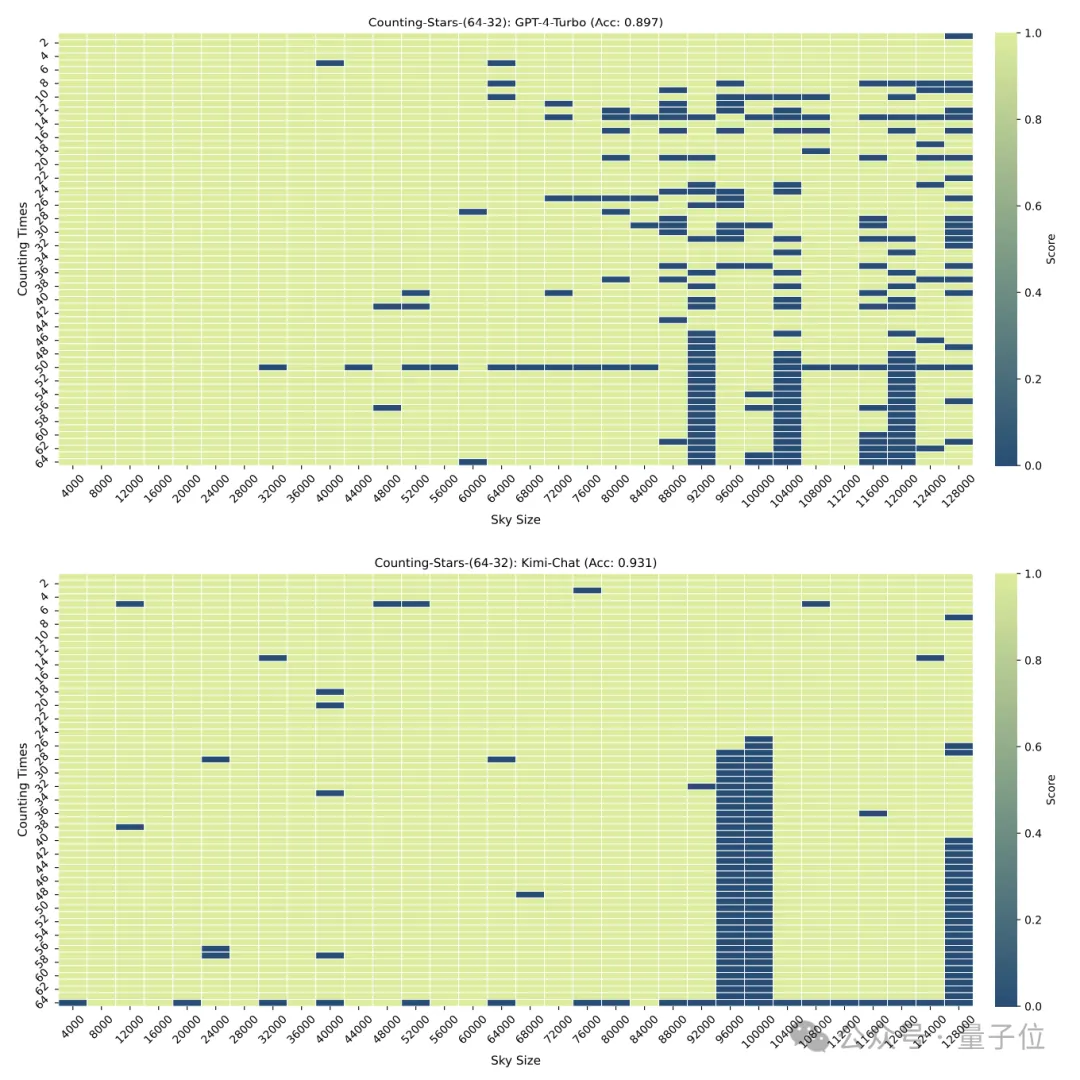

但当“星星”增加到64颗时,Kimi则以93.1%的准确率超过了准确率为89.7%的GPT-4.

减少到16时,也是Kimi的表现略胜于GPT-4。

而划分的颗粒度也会对模型的表现造成一些影响,在“星星”同样出现32次时,颗粒度从32变为16,GPT-4的成绩有所上升,而Kimi则有所下降。

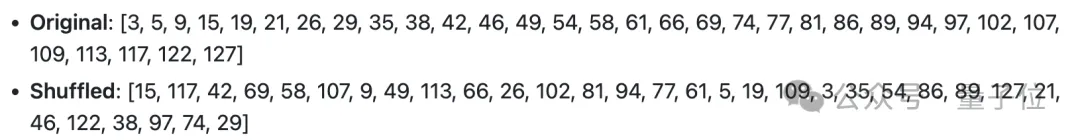

需要注意的是,在以上的测试中,“星星”的数量是依次递增的,但研究人员很快发现,这种情况下大模型很喜欢“偷懒”——

当模型发现星星数量是递增的的时候,即使区间内的数字是随机生成,也会引起大模型的敏感度增加。

例如:模型对3、9、10、24、1145、114514这样的递增序列会比24、10、3、1145、9、114514更加敏感

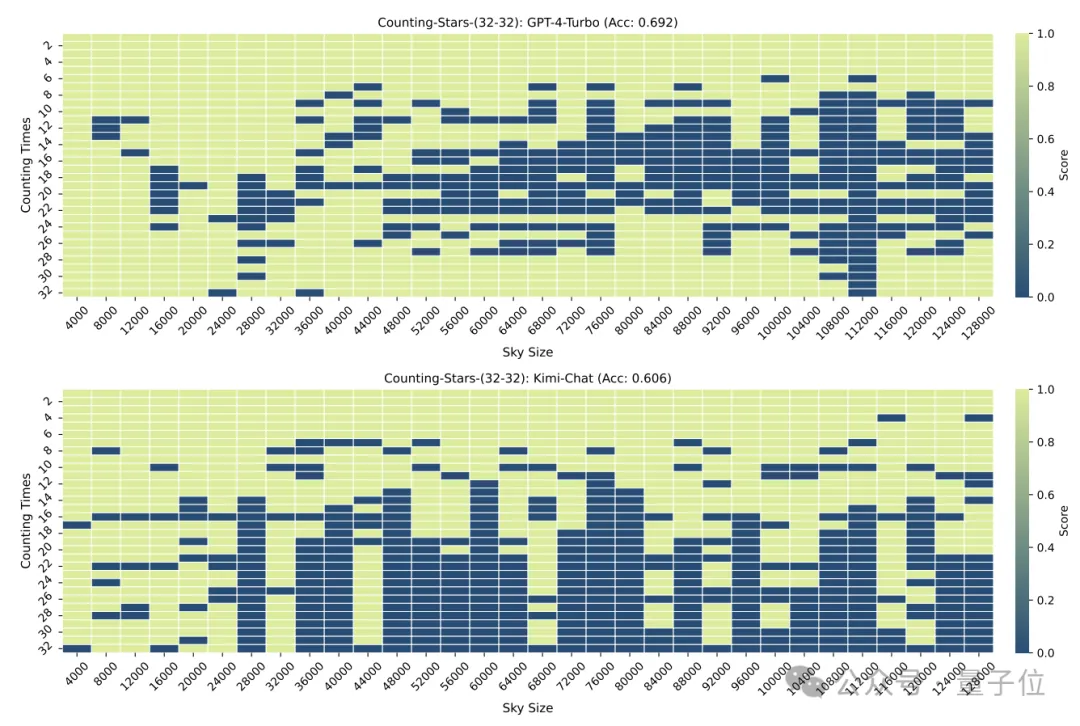

所以,研究人员又特意将数字的顺序进行了打乱,重新进行了一次测试。

结果在打乱之后,GPT-4和Kimi的表现都出现了明显下降,不过准确率仍在60%以上,两者相差8.6个百分点。

One More Thing

这个方法的准确性可能还需要时间检验,但不得不说名字起得真的很有一手。

△英文系同名歌曲Counting Stars歌词

网友也不禁感叹,现在关于大模型的研究,真的是越来越魔幻了。

但魔幻的背后,也体现出人们对于大模型长语境处理能力和性能的了解还不够充分。

就在前些天,先后有多家大模型厂商宣布推出能够处理超长文本的模型(虽然不全是基于上下文窗口实现),最高可达上千万,但实际表现还是未知数。

而Counting Stars的出现,或许正好有助于我们了解这些模型的真实表现。

那么,你还想看看哪些模型的测试成绩呢?

论文地址:https://arxiv.org/abs/2403.11802

GitHub:https://github.com/nick7nlp/Counting-Stars

以上是'大海捞针”out!'数星星”成测长文本能力更精准方法,来自鹅厂的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

十个推荐开源免费文本标注工具

Mar 26, 2024 pm 08:20 PM

十个推荐开源免费文本标注工具

Mar 26, 2024 pm 08:20 PM

文本标注工作是将标签或标记与文本中特定内容相对应的工作。其主要目的是为文本提供额外的信息,以便进行更深入的分析和处理,尤其是在人工智能领域。文本标注对于人工智能应用中的监督机器学习任务至关重要。用于训练AI模型,有助更准确地理解自然语言文本信息,提高文本分类、情感分析和语言翻译等任务的性能。通过文本标注,我们可以教AI模型识别文本中的实体、理解上下文,并在出现新的类似数据时做出准确的预测。本文主要推荐一些较好的开源文本标注工具。1.LabelStudiohttps://github.com/Hu

15个值得推荐的开源免费图像标注工具

Mar 28, 2024 pm 01:21 PM

15个值得推荐的开源免费图像标注工具

Mar 28, 2024 pm 01:21 PM

图像标注是将标签或描述性信息与图像相关联的过程,以赋予图像内容更深层次的含义和解释。这一过程对于机器学习至关重要,它有助于训练视觉模型以更准确地识别图像中的各个元素。通过为图像添加标注,使得计算机能够理解图像背后的语义和上下文,从而提高对图像内容的理解和分析能力。图像标注的应用范围广泛,涵盖了许多领域,如计算机视觉、自然语言处理和图视觉模型具有广泛的应用领域,例如,辅助车辆识别道路上的障碍物,帮助疾病的检测和诊断通过医学图像识别。本文主要推荐一些较好的开源免费的图像标注工具。1.Makesens

furmark怎么看?-furmark怎么算合格?

Mar 19, 2024 am 09:25 AM

furmark怎么看?-furmark怎么算合格?

Mar 19, 2024 am 09:25 AM

furmark怎么看?1、在主界面中设置“运行模式”和“显示模式”,还能调整“测试模式”,点击“开始”按钮。2、等待片刻后,就会看到测试结果,包含了显卡各种参数。furmark怎么算合格?1、用furmark烤机,半个小时左右看一下结果,基本上在85度左右徘徊,峰值87度,室温19度。大号机箱,5个机箱风扇口,前置两个,上置两个,后置一个,不过只装了一个风扇。所有配件都没有超频。2、一般情况下,显卡的正常温度应该在“30-85℃”之间。3、就算是大夏天周围环境温度过高,正常温度也是“50-85℃

推荐:优秀JS开源人脸检测识别项目

Apr 03, 2024 am 11:55 AM

推荐:优秀JS开源人脸检测识别项目

Apr 03, 2024 am 11:55 AM

人脸检测识别技术已经是一个比较成熟且应用广泛的技术。而目前最为广泛的互联网应用语言非JS莫属,在Web前端实现人脸检测识别相比后端的人脸识别有优势也有弱势。优势包括减少网络交互、实时识别,大大缩短了用户等待时间,提高了用户体验;弱势是:受到模型大小限制,其中准确率也有限。如何在web端使用js实现人脸检测呢?为了实现Web端人脸识别,需要熟悉相关的编程语言和技术,如JavaScript、HTML、CSS、WebRTC等。同时还需要掌握相关的计算机视觉和人工智能技术。值得注意的是,由于Web端的计

阿里7B多模态文档理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模态文档理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模态文档理解能力新SOTA!阿里mPLUG团队发布最新开源工作mPLUG-DocOwl1.5,针对高分辨率图片文字识别、通用文档结构理解、指令遵循、外部知识引入四大挑战,提出了一系列解决方案。话不多说,先来看效果。复杂结构的图表一键识别转换为Markdown格式:不同样式的图表都可以:更细节的文字识别和定位也能轻松搞定:还能对文档理解给出详细解释:要知道,“文档理解”目前是大语言模型实现落地的一个重要场景,市面上有很多辅助文档阅读的产品,有的主要通过OCR系统进行文字识别,配合LLM进行文字理

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮点数量化精度,不再是H100的“专利”了!老黄想让大家用INT8/INT4,微软DeepSpeed团队在没有英伟达官方支持的条件下,硬生生在A100上跑起FP6。测试结果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶尔超过INT4,而且拥有比后者更高的精度。在此基础之上,还有端到端的大模型支持,目前已经开源并集成到了DeepSpeed等深度学习推理框架中。这一成果对大模型的加速效果也是立竿见影——在这种框架下用单卡跑Llama,吞吐量比双卡还要高2.65倍。一名

刚刚发布!一键生成动漫风格图片的开源模型

Apr 08, 2024 pm 06:01 PM

刚刚发布!一键生成动漫风格图片的开源模型

Apr 08, 2024 pm 06:01 PM

向大家介绍一个最新的AIGC开源项目——AnimagineXL3.1。这个项目是动漫主题文本到图像模型的最新迭代,旨在为用户提供更加优化和强大的动漫图像生成体验。在AnimagineXL3.1中,开发团队着重优化了几个关键方面,以确保模型在性能和功能上达到新的高度。首先,他们扩展了训练数据,不仅包括了之前版本中的游戏角色数据,还加入许多其他知名动漫系列的数据纳入训练集中。这一举措丰富了模型的知识库,使其能够更全面地理解各种动漫风格和角色。AnimagineXL3.1引入了一组新的特殊标签和美学标

1.3ms耗时!清华最新开源移动端神经网络架构 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗时!清华最新开源移动端神经网络架构 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显着的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效