能打得过GPT-4的开源模型出现了!

大模型竞技场最新战报:

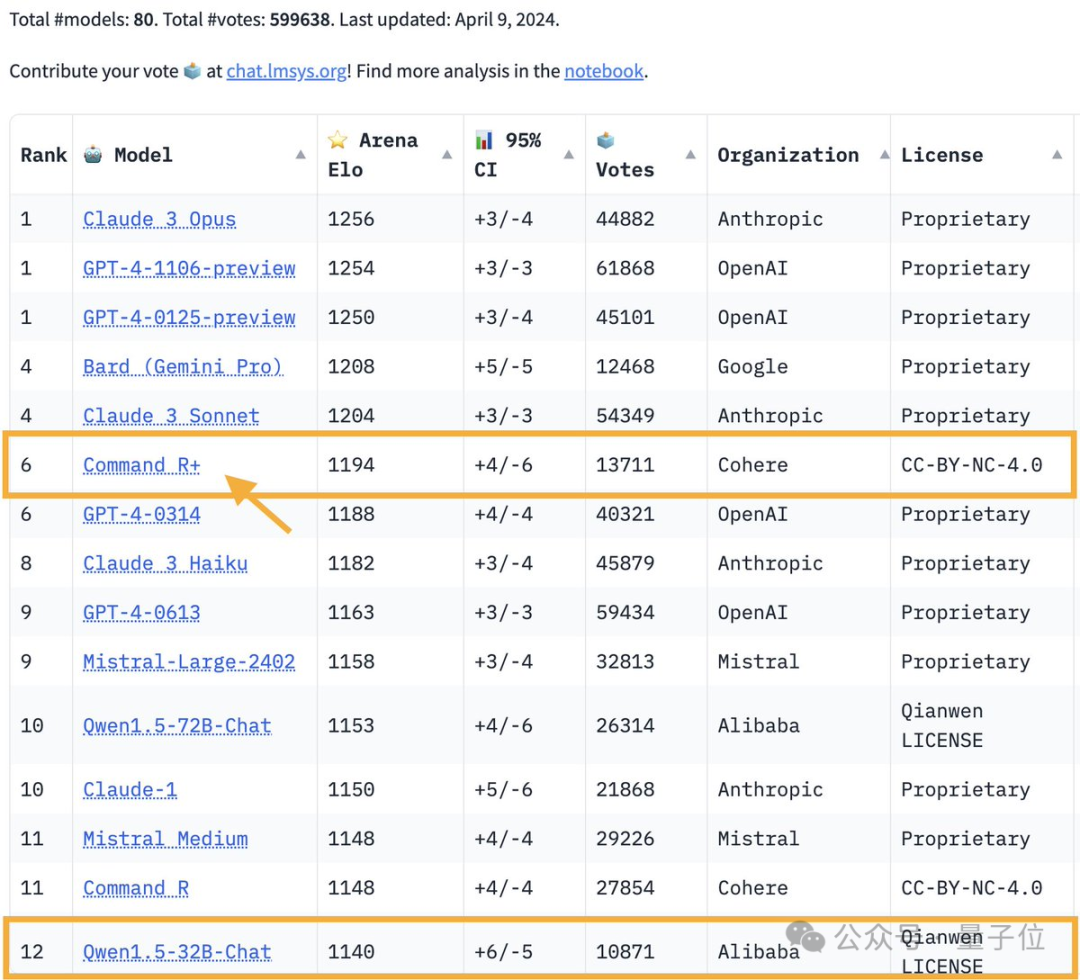

1040亿参数开源模型Command R 攀升至第6位,与GPT-4-0314打成平手,超过了GPT-4-0613。

图片

图片

这也是第一个在大模型竞技场上击败GPT-4的开放权重模型。

大模型竞技场,可是大神Karpathy口中唯二信任的测试基准之一。

图片

图片

Command R 来自AI独角兽Cohere。这家大模型创业公司的联合创始人兼CEO,正是Transformer最年轻作者Aidan Gomez(简称割麦子)。

图片

图片

这份战报一出,又掀起了一波大模型社区的热烈讨论。

大家伙儿兴奋的理由很简单:基础大模型卷了一整年,没想到在2024年格局还在不断地发展变化。

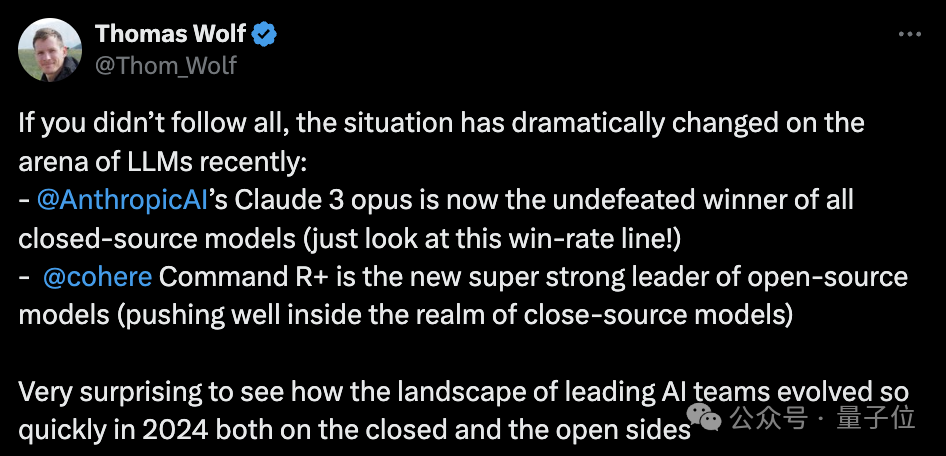

HuggingFace联合创始人Thomas Wolf就说:

最近大模型竞技场上的情况发生了巨大的变化:

Anthropic的Claude 3 opus在闭源模型中独占鳌头。

Cohere的Command R 则成为了开源模型中的最强者。

没想到,2024年在开源和闭源两条路线上,人工智能团队的发展都如此之快。

图片

图片

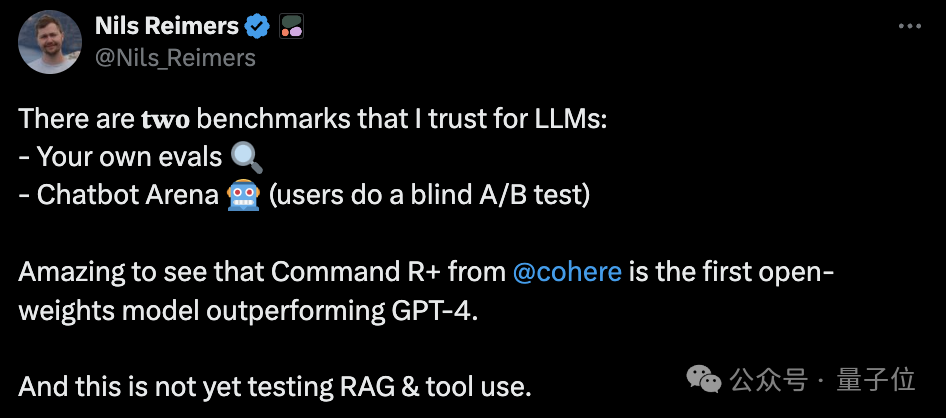

另外,Cohere机器学习总监Nils Reimers还指出了值得关注的一点:

Command R 最大的特色是对内置RAG(检索增强生成)进行了全面优化,而在大模型竞技场中,RAG这样的外挂能力并未纳入测试。

图片

图片

在Cohere官方定位中,Command R 是一个“RAG优化模型”。

就是说,这个1040亿参数的大模型主要针对检索增强生成技术进行了深度优化,以减少幻觉的产生,更适配于企业级工作负载。

和此前推出的Command R一样,Command R 的上下文窗口长度是128k。

此外,Command R 还具备以下特点:

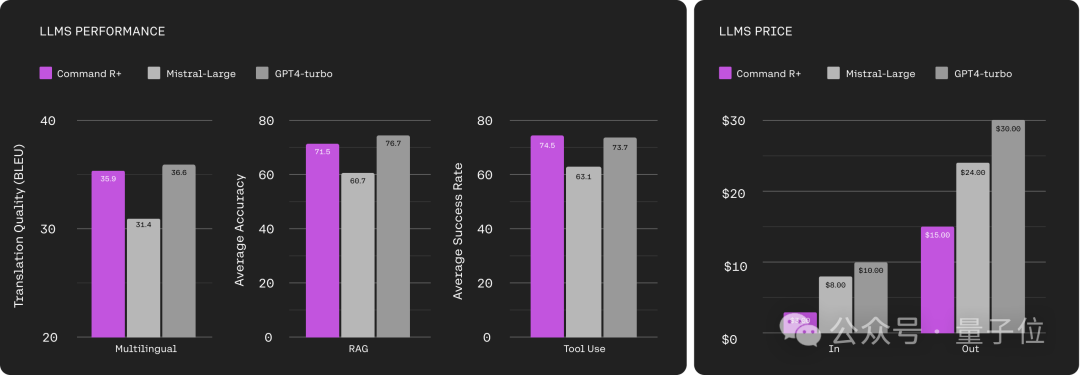

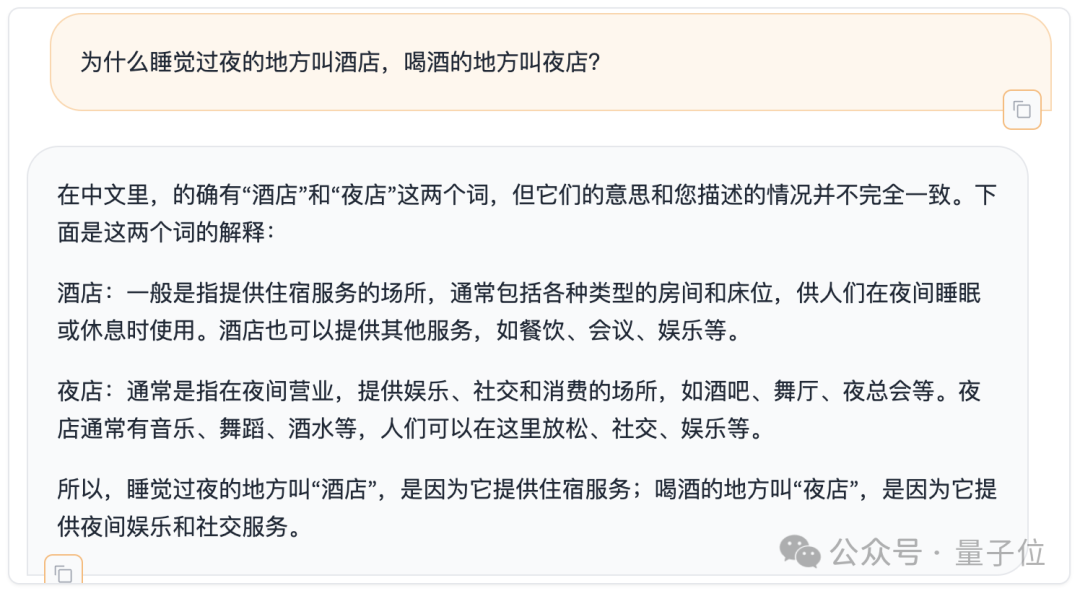

从测试结果来看,在多语种、RAG和工具使用这三个维度上,Command R 都达到了GPT-4 turbo的水平。

但在输入成本方面,Command R 的价格仅为GPT-4 turbo的1/3。

输出成本方面,Command R 则是GPT-4 turbo的1/2。

图片

图片

正是这点引发了不少网友的关注:

图片

图片

不过,尽管在大模型竞技场这种人类主观评测上表现抢眼,还是有网友甩出了一些不同观点。

在HumanEval上,Command R 的代码能力就连GPT-3.5都没打过,在两组测试中分别排在32位和33位。

最新版GPT-4 turbo则没有悬念地拿下了第一。

图片

图片

另外,我们也在最近刚登上正经论文的弱智吧benchmark上简单测试了一下Command R 的中文能力。

图片

图片

你给打个分?

需要说明的是,Command R 的开源只面向学术研究,并不能免费商用。

最后的最后,还是多聊一嘴割麦子小哥。

Aidan Gomez,Transformer圆桌骑士中最年轻的一位,加入研究团队时只是个本科生——

不过,是在多伦多大学读大三时就加入了Hinton实验室的那种。

2018年,割麦子被牛津大学录取,开始像他的论文搭子们那样攻读CS博士学位。

但在2019年,随着Cohere的创立,他最终选择退学加入AI创业的浪潮。

Cohere主要是为企业提供大模型解决方案,目前估值达到了22亿美元。

参考链接:

[1]https://www.php.cn/link/3be14122a3c78d9070cae09a16adcbb1[2]https://www.php.cn/link/93fc5aed8c051ce4538e052cfe9f8692

以上是开源模型首胜GPT-4!竞技场最新战报引热议,Karpathy:这是我唯二信任的榜单的详细内容。更多信息请关注PHP中文网其他相关文章!