DeepMind升级Transformer,前向通过FLOPs最多可降一半

git

工程

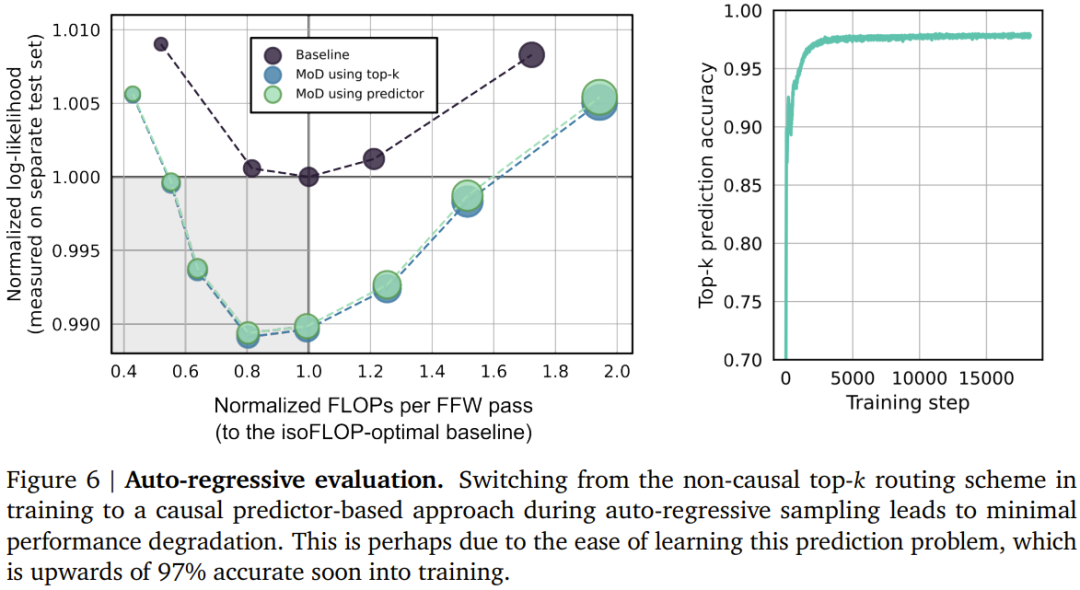

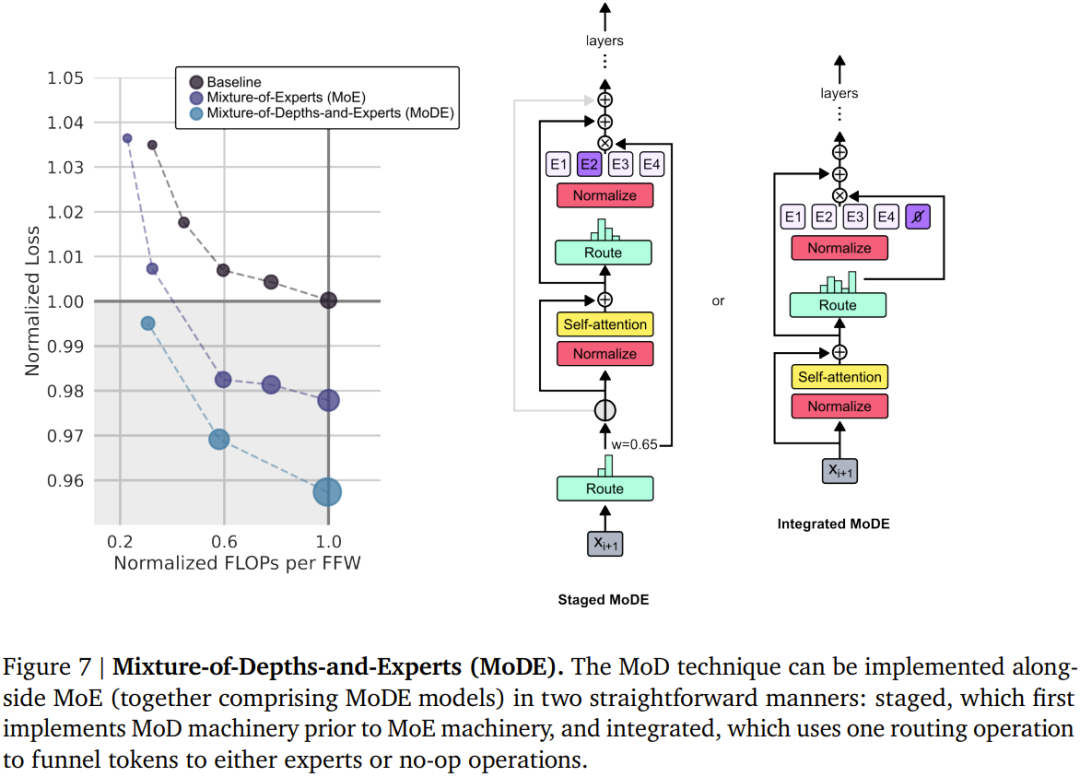

引入混合深度,DeepMind 新设计可大幅提升 Transformer 效率。

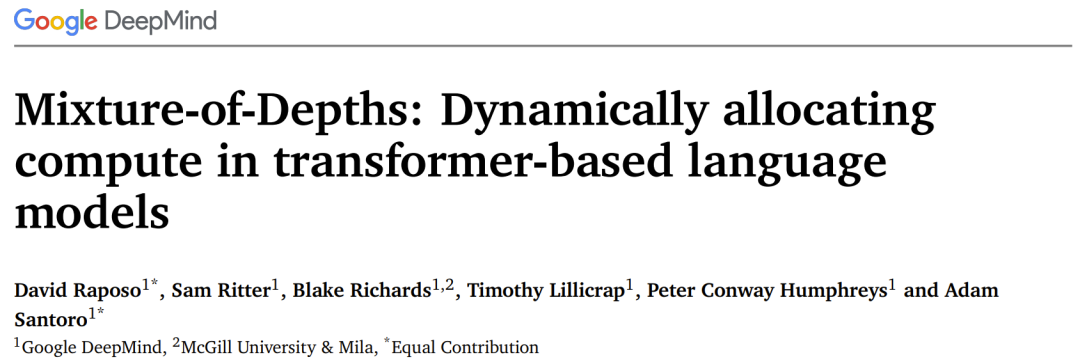

论文标题:Mixture-of-Depths: Dynamically allocating compute in transformer-based language models 论文地址:https://arxiv.org/pdf/2404.02258.pdf

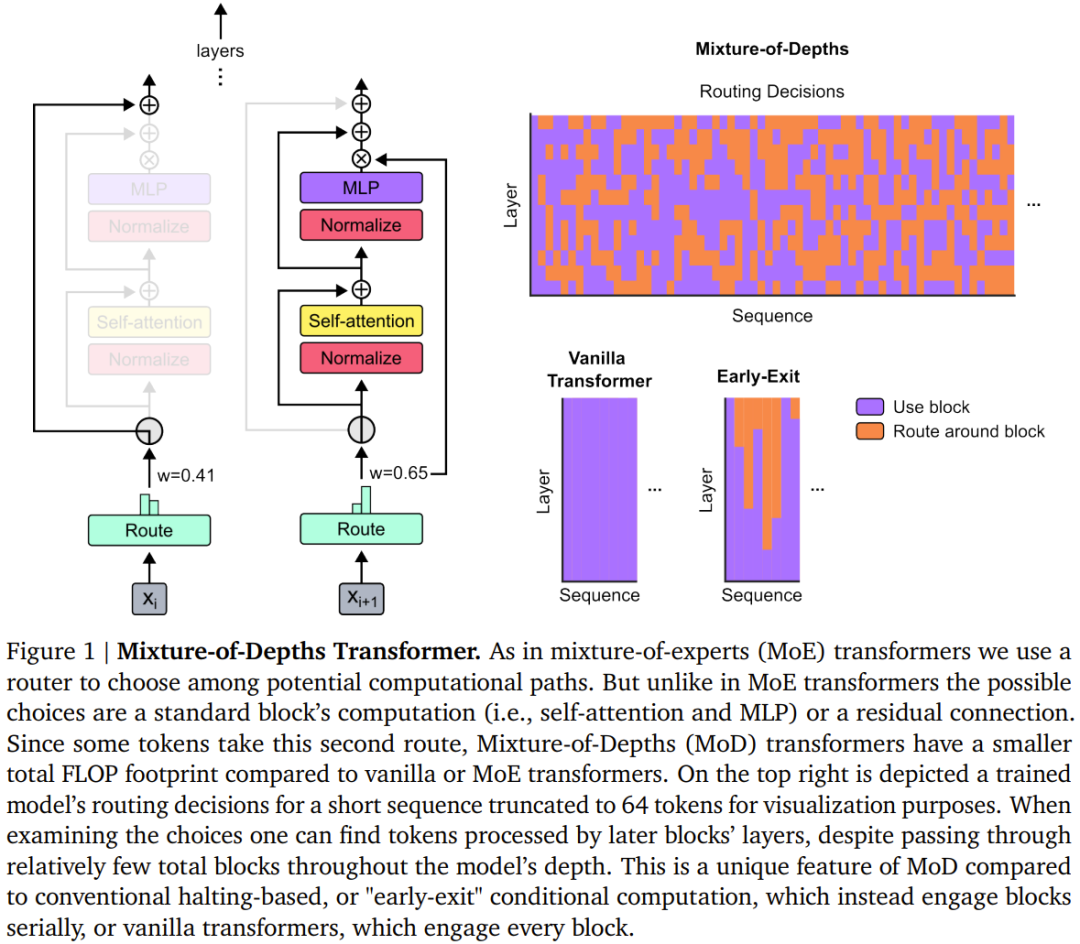

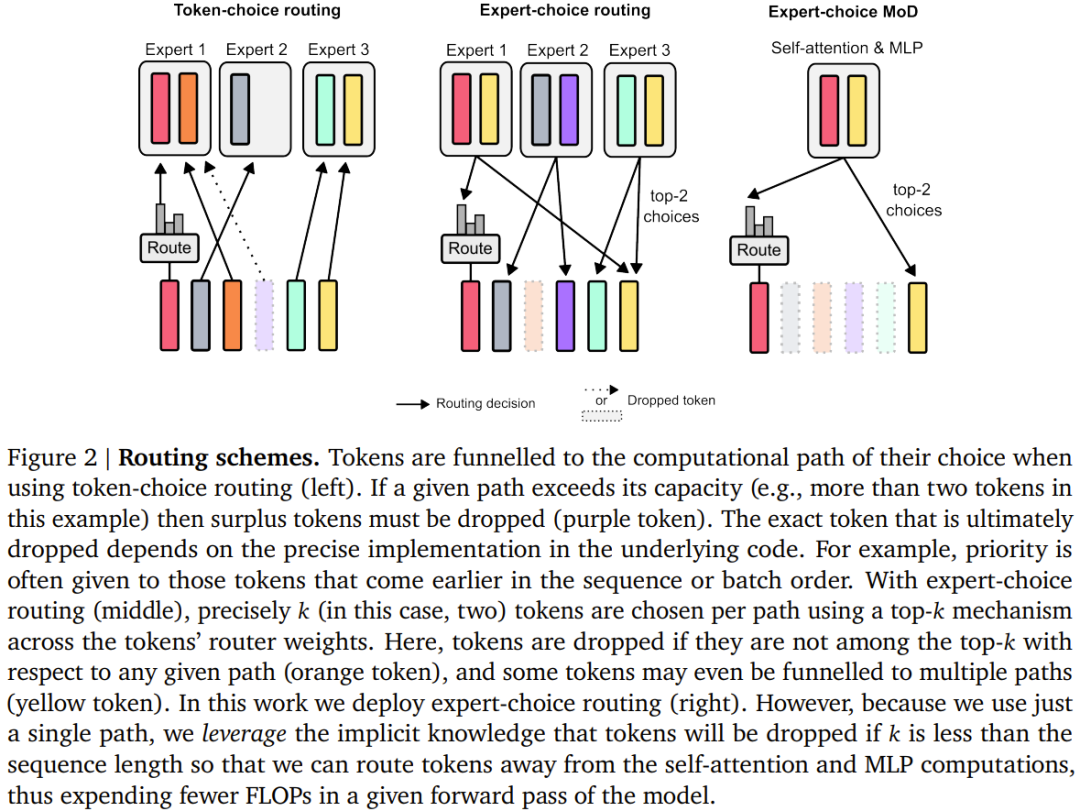

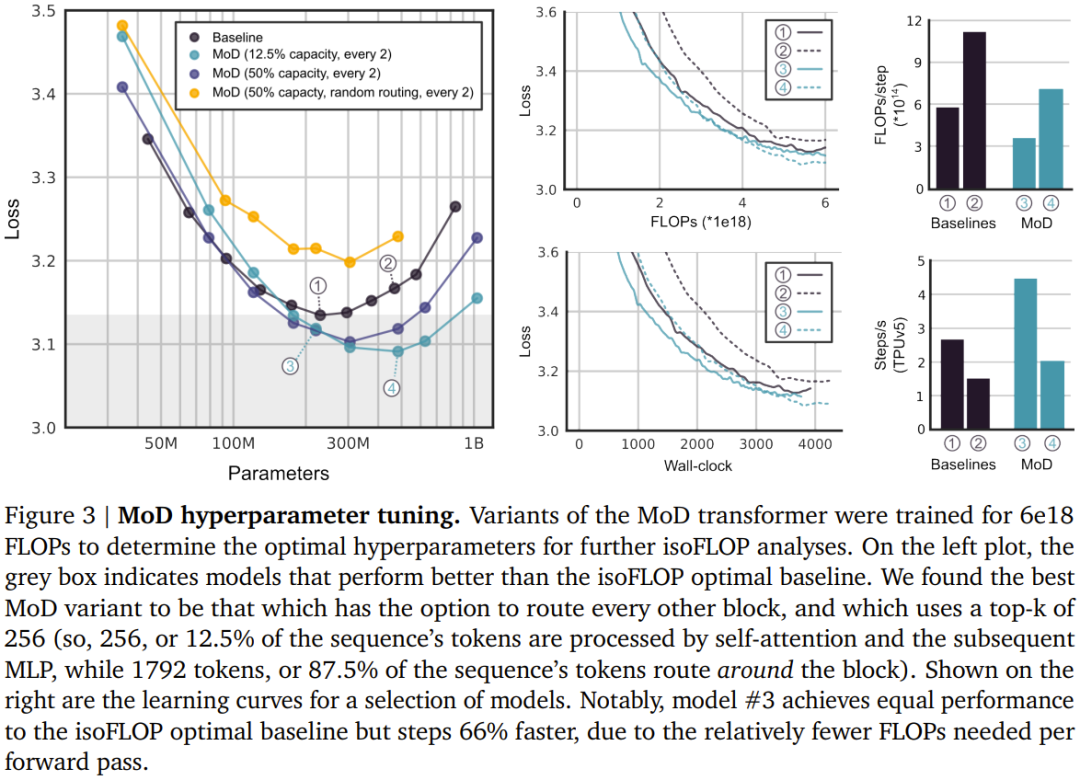

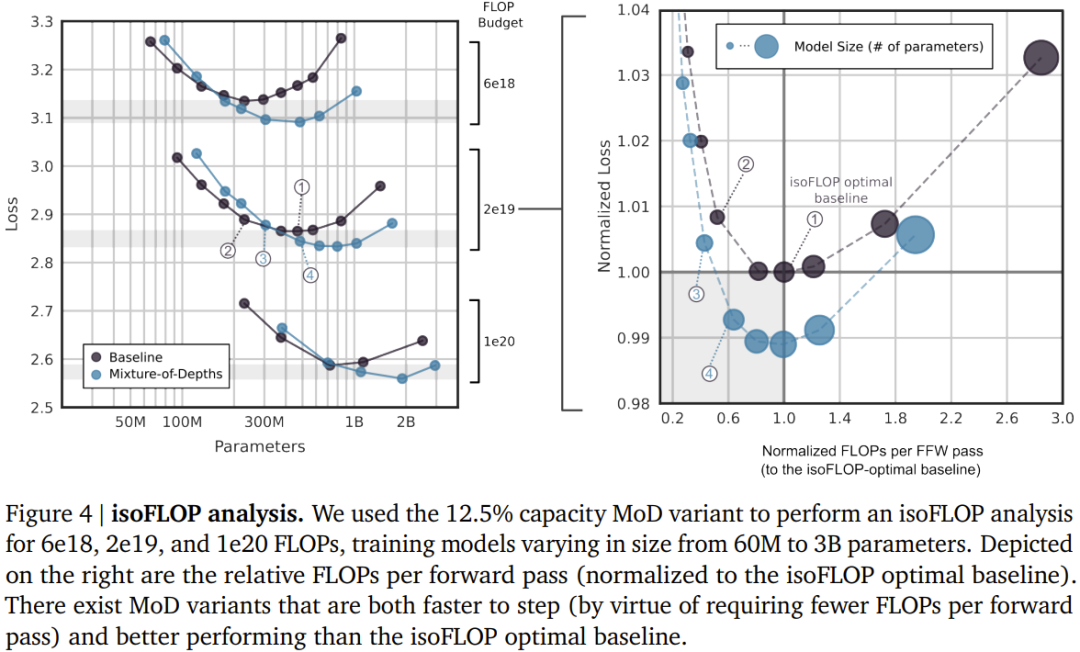

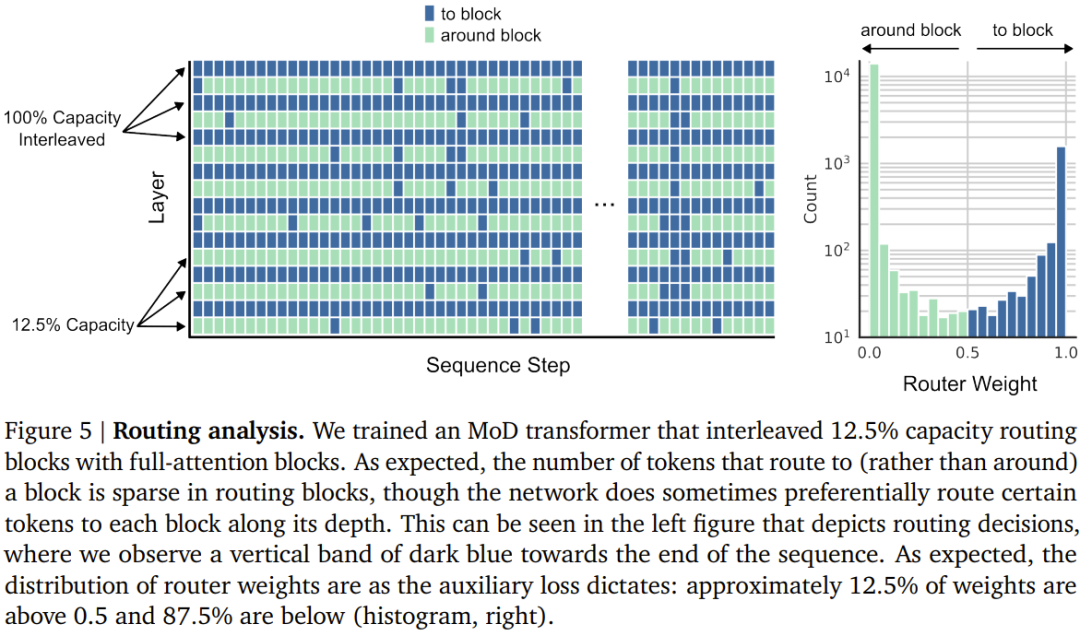

设定一个静态的计算预算,该预算低于等价的常规 Transformer 所需的计算量;做法是限制序列中可参与模块计算(即自注意力模块和后续的 MLP)的 token 数量。举个例子,常规 Transformer 可能允许序列中的所有 token 都参与自注意力计算,但 MoD Transformer 可限定仅使用序列中 50% 的 token。 针对每个 token,每个模块中都有一个路由算法给出一个标量权重;该权重表示路由对各个 token 的偏好 —— 是参与模块的计算还是绕过去。 在每个模块中,找到最大的前 k 个标量权重,它们对应的 token 会参与到该模块的计算中。由于必定只有 k 个 token 参与到该模块的计算中,因此其计算图和张量大小在训练过程中是静态的;这些 token 都是路由算法认定的动态且与上下文有关的 token。

以上是DeepMind升级Transformer,前向通过FLOPs最多可降一半的详细内容。更多信息请关注PHP中文网其他相关文章!

本站声明

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系admin@php.cn

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

R.E.P.O.能量晶体解释及其做什么(黄色晶体)

3 周前

By 尊渡假赌尊渡假赌尊渡假赌

R.E.P.O.最佳图形设置

3 周前

By 尊渡假赌尊渡假赌尊渡假赌

刺客信条阴影:贝壳谜语解决方案

2 周前

By DDD

R.E.P.O.如果您听不到任何人,如何修复音频

3 周前

By 尊渡假赌尊渡假赌尊渡假赌

WWE 2K25:如何解锁Myrise中的所有内容

4 周前

By 尊渡假赌尊渡假赌尊渡假赌

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Go语言中用于浮点数运算的库有哪些?

Apr 02, 2025 pm 02:06 PM

Go语言中用于浮点数运算的库有哪些?

Apr 02, 2025 pm 02:06 PM

Go语言中用于浮点数运算的库介绍在Go语言(也称为Golang)中,进行浮点数的加减乘除运算时,如何确保精度是�...

h5项目怎么运行

Apr 06, 2025 pm 12:21 PM

h5项目怎么运行

Apr 06, 2025 pm 12:21 PM

运行 H5 项目需要以下步骤:安装 Web 服务器、Node.js、开发工具等必要工具。搭建开发环境,创建项目文件夹、初始化项目、编写代码。启动开发服务器,使用命令行运行命令。在浏览器中预览项目,输入开发服务器 URL。发布项目,优化代码、部署项目、设置 Web 服务器配置。

Gitee Pages静态网站部署失败:单个文件404错误如何排查和解决?

Apr 04, 2025 pm 11:54 PM

Gitee Pages静态网站部署失败:单个文件404错误如何排查和解决?

Apr 04, 2025 pm 11:54 PM

GiteePages静态网站部署失败:404错误排查与解决在使用Gitee...

Beego ORM中如何指定模型关联的数据库?

Apr 02, 2025 pm 03:54 PM

Beego ORM中如何指定模型关联的数据库?

Apr 02, 2025 pm 03:54 PM

在BeegoORM框架下,如何指定模型关联的数据库?许多Beego项目需要同时操作多个数据库。当使用Beego...

Go语言中哪些库是由大公司开发或知名的开源项目提供的?

Apr 02, 2025 pm 04:12 PM

Go语言中哪些库是由大公司开发或知名的开源项目提供的?

Apr 02, 2025 pm 04:12 PM

Go语言中哪些库是大公司开发或知名开源项目?在使用Go语言进行编程时,开发者常常会遇到一些常见的需求,�...

在Go语言中使用Redis Stream实现消息队列时,如何解决user_id类型转换问题?

Apr 02, 2025 pm 04:54 PM

在Go语言中使用Redis Stream实现消息队列时,如何解决user_id类型转换问题?

Apr 02, 2025 pm 04:54 PM

Go语言中使用RedisStream实现消息队列时类型转换问题在使用Go语言与Redis...

H5页面制作是否需要持续维护

Apr 05, 2025 pm 11:27 PM

H5页面制作是否需要持续维护

Apr 05, 2025 pm 11:27 PM

H5页面需要持续维护,这是因为代码漏洞、浏览器兼容性、性能优化、安全更新和用户体验提升等因素。有效维护的方法包括建立完善的测试体系、使用版本控制工具、定期监控页面性能、收集用户反馈和制定维护计划。