谷歌出手整顿大模型'健忘症”!反馈注意力机制帮你'更新”上下文,大模型无限记忆力时代将至

编辑|伊风

出品 | 51CTO技术栈(微信号:blog51cto)

谷歌终于出手了!我们将不再忍受大模型的“健忘症”。

TransformerFAM横空出世,放话要让大模型拥有无限记忆力!

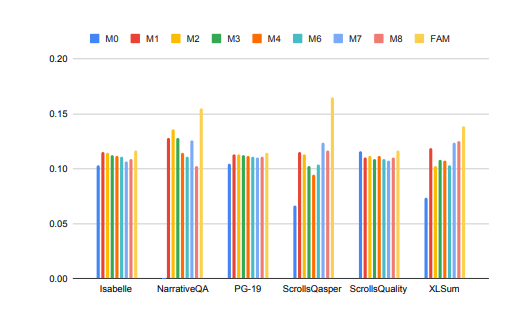

话不多说,先来看看TransformerFAM的“疗效”:

图片

图片

大模型在处理长上下文任务时的性能得到了显着提升!

在上图中,Isabelle、NarrativeQA等任务要求模型理解和处理大量上下文信息,并对特定问题给出准确的回答或摘要。在所有任务中,FAM配置的模型都优于所有其他BSWA配置,并且能够看到当超过某个点时,BSWA记忆段数量的增加已经无法继续提升其记忆能力。

看来,在卷长文本、长对话的路上,FAM这颗大模型的“忘不了”确实有点东西。

Google的研究人员介绍了FAM这种新颖的Transformer架构——Feedback Attention Memory。它利用反馈循环使网络能够关注自身的漂移表现,促进Transformer内部工作记忆的出现,并使其能够处理无限长的序列。

简单点说,这个策略有点像我们人工对抗大模型“失忆”的策略:每次和大模型对话前都再输入一次prompt。只不过FAM的做法更高阶一些,在模型处理新的数据块时,它会将之前处理过的信息(即FAM)作为一个动态更新的上下文,再次整合到当前的处理过程中。

这样就能很好地应对“爱忘事”的问题了。更妙的是,尽管引入了反馈机制来维持长期的工作记忆,但FAM的设计旨在保持与预训练模型的兼容性,不需要额外的权重。所以理论上说,大模型的强大记忆力,没有使其变得迟钝或者消耗更多的算力资源。

那么,这么妙的TransformerFAM是如何被探索出来的?相关技术又是啥?

一、从挑战中来,TransformerFAM为何能帮助大模型“记住更多”?

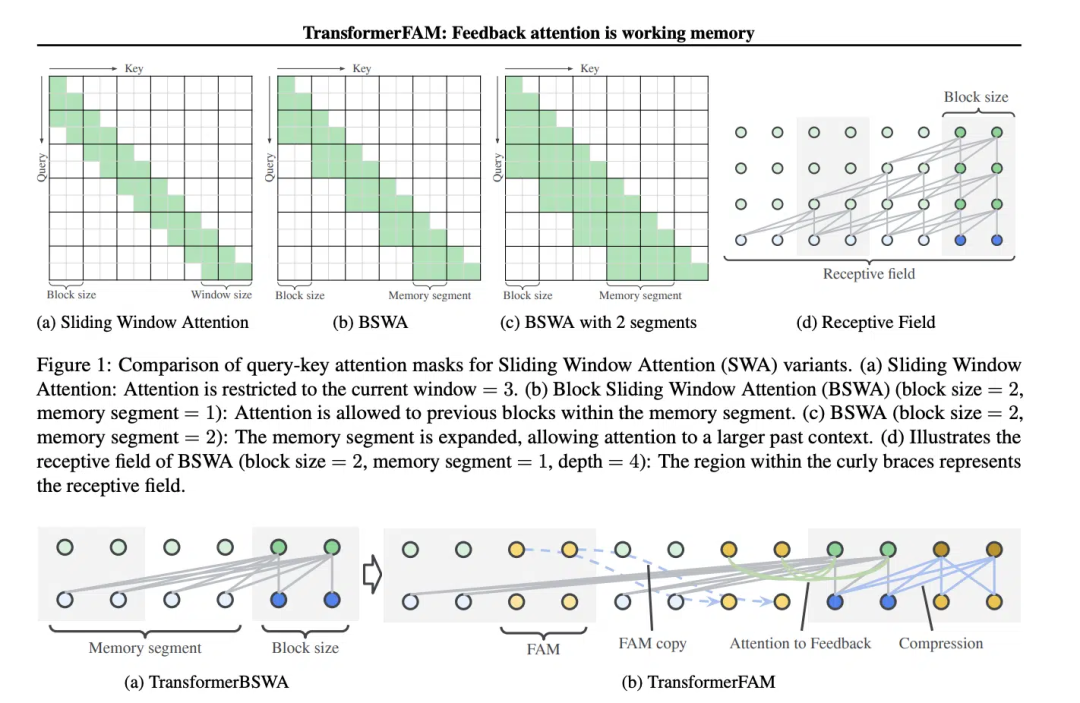

滑动窗口注意力(Sliding Window Attention, SWA)这个概念,对TransformerFAM的设计至关重要。

在传统的Transformer模型中,自注意力(Self-Attention)的复杂度随着序列长度的增加而呈二次方增长,这限制了模型处理长序列的能力。

“在电影《记忆碎片》(2000 年)中,主角患有顺行性遗忘症,这意味着他无法记住过去10 分钟发生的事情,但他的长期记忆是完好的,他不得不将重要信息纹在身上以记住它们。这与当前大型语言模型(LLMs)的状态类似,”论文中这样写道。

《记忆碎片》电影截图,图片源于网络

《记忆碎片》电影截图,图片源于网络

滑动窗口注意力(Sliding Window Attention),它是一种改进的注意力机制,用于处理长序列数据。它受到了计算机科学中滑动窗口技术(sliding window technique)的启发。在处理自然语言处理(NLP)任务时,SWA允许模型在每个时间步骤上只关注输入序列的一个固定大小的窗口,而不是整个序列。因此,SWA的优点在于它可以显着减少计算量。

图片

图片

但是SWA有局限性,因为它的注意力范围受限于窗口大小,这导致模型无法考虑到窗口之外的重要信息。

TransformerFAM通过添加反馈激活,将上下文表示重新输入到滑动窗口注意力的每个区块中,从而实现了集成注意力、区块级更新、信息压缩和全局上下文存储。

在TransformerFAM中,改进通过反馈循环实现。具体来说,模型在处理当前序列块时,不仅关注当前窗口内的元素,还会将之前处理过的上下文信息(即之前的“反馈激活”)作为额外的输入重新引入到注意力机制中。这样,即使模型的注意力窗口在序列上滑动,它也能够保持对之前信息的记忆和理解。

于是,经过这番改进,TransformerFAM就给了LLMs能够处理无限长度序列的潜力!

二、有了工作记忆的大模型,继续向AGI迈进

TransformerFAM在研究中展现出了积极的前景,这将毫无疑问地提升AI在理解和生成长文本任务中的性能,例如处理文档摘要、故事生成、问答等工作。

图片

图片

同时,无论是智能助手还是情感陪伴,一个有无限记忆力的AI听起来都更有吸引力。

有趣的是,TransformerFAM的设计灵感来源于生物学中的记忆机制,这一点与AGI追求的自然智能模拟不谋而合。这篇论文正是一个来自神经科学的概念——基于注意力的工作记忆——整合到深度学习领域的尝试。

TransformerFAM通过反馈循环为大模型引入了工作记忆,使得模型不仅能够记住短期的信息,还能够在长期序列中维持对关键信息的记忆。

通过大胆的想象,研究人员在现实世界与抽象概念间假设起桥梁。随着TransformerFAM这样的创新成果继续涌现出来,技术的瓶颈会一次次被突破,一个更加智能、互联的未来正向我们徐徐地展开画卷。

想了解更多AIGC的内容,请访问:

51CTO AI.x社区

https://www.51cto.com/aigc/

以上是谷歌出手整顿大模型'健忘症”!反馈注意力机制帮你'更新”上下文,大模型无限记忆力时代将至的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

deepseek怎么评论

Feb 19, 2025 pm 05:42 PM

deepseek怎么评论

Feb 19, 2025 pm 05:42 PM

DeepSeek是一款功能强大的信息检索工具,其优势在于能够深入挖掘信息,但缺点是速度较慢、结果呈现方式较简单且数据库覆盖范围有限,需要根据具体需求权衡其利弊。

deepseek怎么搜索

Feb 19, 2025 pm 05:39 PM

deepseek怎么搜索

Feb 19, 2025 pm 05:39 PM

DeepSeek是一个专有搜索引擎,仅在特定数据库或系统中搜索,速度更快,准确性更高。使用时,建议用户阅读文档、尝试不同的搜索策略、寻求帮助和反馈使用体验,以便充分利用其优势。

芝麻开门交易所网页注册链接 gate交易app注册网址最新

Feb 28, 2025 am 11:06 AM

芝麻开门交易所网页注册链接 gate交易app注册网址最新

Feb 28, 2025 am 11:06 AM

本文详细介绍了芝麻开门交易所(Gate.io)网页版和Gate交易App的注册流程。 无论是网页注册还是App注册,都需要访问官方网站或应用商店下载正版App,然后填写用户名、密码、邮箱和手机号等信息,并完成邮箱或手机验证。

Bybit交易所链接为什么不能直接下载安装?

Feb 21, 2025 pm 10:57 PM

Bybit交易所链接为什么不能直接下载安装?

Feb 21, 2025 pm 10:57 PM

为什么Bybit交易所链接无法直接下载安装?Bybit是一个加密货币交易所,为用户提供交易服务。该交易所的移动应用程序不能直接通过AppStore或GooglePlay下载,原因如下:1.应用商店政策限制苹果公司和谷歌公司对应用商店中允许的应用程序类型有严格的要求。加密货币交易所应用程序通常不符合这些要求,因为它们涉及金融服务,需要遵循特定的法规和安全标准。2.法律法规合规在许多国家/地区,与加密货币交易相关的活动都受到监管或限制。为了遵守这些规定,Bybit应用程序只能通过官方网站或其他授权渠

加密数字资产交易APP推荐top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

加密数字资产交易APP推荐top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

本文推荐十大值得关注的加密货币交易平台,涵盖币安(Binance)、OKX、Gate.io、BitFlyer、KuCoin、Bybit、Coinbase Pro、Kraken、BYDFi和XBIT去中心化交易所。这些平台在交易币种数量、交易类型、安全性、合规性、特色功能等方面各有千秋,例如币安以其全球最大的交易量和丰富的功能着称,而BitFlyer则凭借其日本金融厅牌照和高安全性吸引亚洲用户。选择合适的平台需要根据自身交易经验、风险承受能力和投资偏好进行综合考量。 希望本文能帮助您找到最适合自

芝麻开门交易所网页版登入口 最新版gateio官网入口

Mar 04, 2025 pm 11:48 PM

芝麻开门交易所网页版登入口 最新版gateio官网入口

Mar 04, 2025 pm 11:48 PM

详细介绍芝麻开门交易所网页版登入口操作,含登录步骤、找回密码流程,还针对登录失败、无法打开页面、收不到验证码等常见问题提供解决方法,助你顺利登录平台。

币安binance官网最新版登录入口

Feb 21, 2025 pm 05:42 PM

币安binance官网最新版登录入口

Feb 21, 2025 pm 05:42 PM

访问币安官方网站最新版登录入口,只需遵循这些简单步骤。前往官方网址,点击右上角的“登录”按钮。选择您现有的登录方式,如果是新用户,请“注册”。输入您的注册手机号或邮箱和密码,并完成身份验证(例如手机验证码或谷歌身份验证器)。成功验证后,即可访问币安官方网站的最新版登录入口。