OmniDrive: 一个关于大模型与3D驾驶任务对齐的框架

May 06, 2024 pm 03:16 PM从一个新颖的3D MLLM架构开始,该架构使用稀疏查询将视觉表示提升和压缩到3D,然后将其输入LLM。

题目:OmniDrive: A Holistic LLM-Agent Framework for Autonomous Driving with 3D Perception Reasoning and Planning

作者单位:北京理工大学,NVIDIA,华中科技大学

开源地址:GitHub - NVlabs/OmniDrive

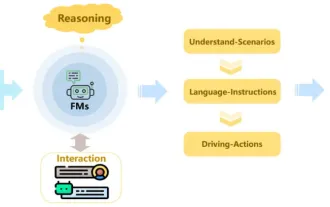

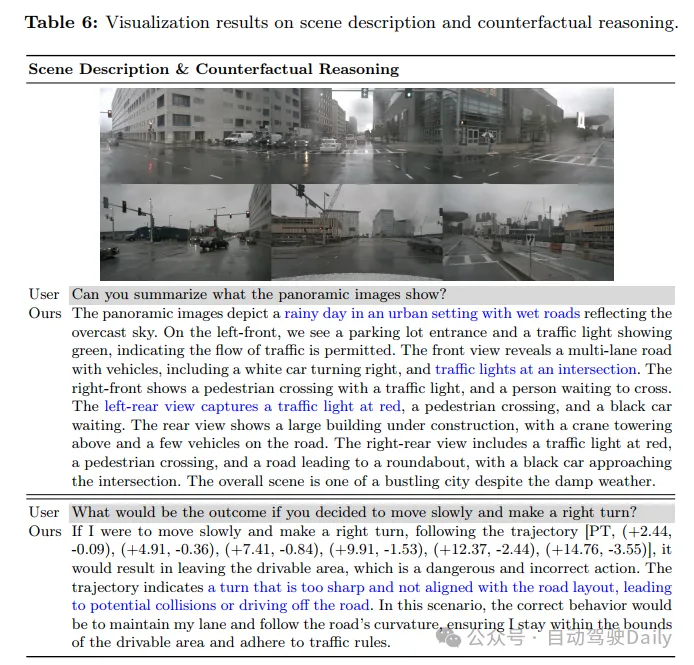

多模态大语言模型(MLLMs)的发展导致了对基于LLM的自动驾驶的兴趣不断增长,利用它们强大的推理能力。利用MLLMs强大的推理能力来改进规划行为是具有挑战性的,因为它们需要超越2D推理的完整3D情境意识。为了解决这一挑战,本工作提出了OmniDrive,这是一个关于智能体模型与3D驱动任务之间强大对齐的全面框架。框架从一个新颖的3D MLLM架构开始,该架构使用稀疏查询将观察表达提升和压缩到3D,然后将其输入LLM。这种基于查询的表达允许我们联合编码动态对象和静态地图元素(例如,交通道路),为3D中的感知-行动对齐提供了一个简洁的世界模型。进一步提出了一个新的基准,其中包括全面的视觉问答(VQA)任务,包括场景描述、交通规则、3D基础、反事实推理、决策制定和规划。广泛的研究表明,OmniDrive在复杂的3D场景中具有出色的推理和规划能力。

网络结构

实验结果

以上是OmniDrive: 一个关于大模型与3D驾驶任务对齐的框架的详细内容。更多信息请关注PHP中文网其他相关文章!

热门文章

热门文章

热门文章标签

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

迈向『闭环』| PlanAgent:基于MLLM的自动驾驶闭环规划新SOTA!

Jun 08, 2024 pm 09:30 PM

迈向『闭环』| PlanAgent:基于MLLM的自动驾驶闭环规划新SOTA!

Jun 08, 2024 pm 09:30 PM

迈向『闭环』| PlanAgent:基于MLLM的自动驾驶闭环规划新SOTA!

Delphi Digital:解析ElizaOS v2新架构,如何改变AI新经济?

Mar 04, 2025 pm 07:00 PM

Delphi Digital:解析ElizaOS v2新架构,如何改变AI新经济?

Mar 04, 2025 pm 07:00 PM

Delphi Digital:解析ElizaOS v2新架构,如何改变AI新经济?