58行代码把Llama 3扩展到100万上下文,任何微调版都适用

堂堂开源之王Llama 3,原版上下文窗口居然只有……8k,让到嘴边的一句“真香”又咽回去了。

在32k起步,100k寻常的今天,这是故意要给开源社区留做贡献的空间吗?

开源社区当然不会放过这个机会:

现在只需58行代码,任何Llama 3 70b的微调版本都能自动扩展到1048k(一百万)上下文。

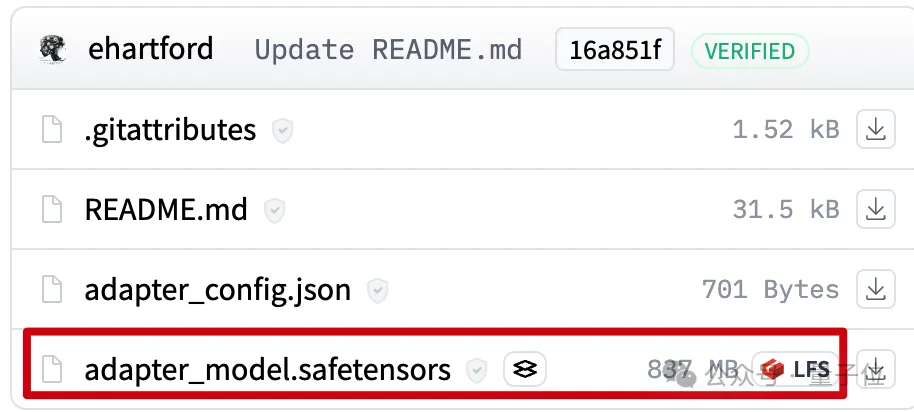

背后是一个LoRA,从扩展好上下文的Llama 3 70B Instruct微调版本中提取出来,文件只有800mb。

接下来使用Mergekit,就可以与其他同架构模型一起运行或直接合并到模型中。

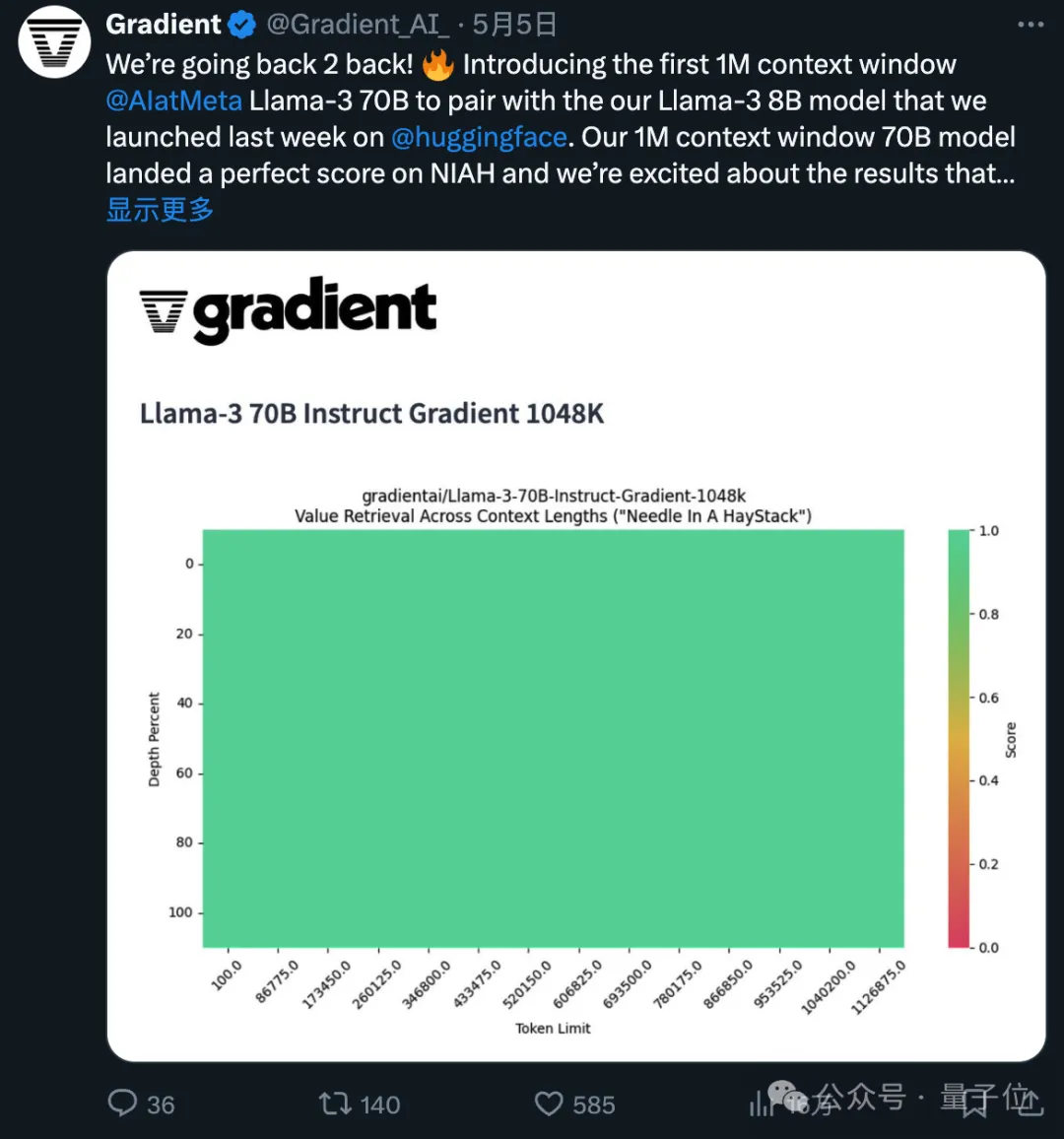

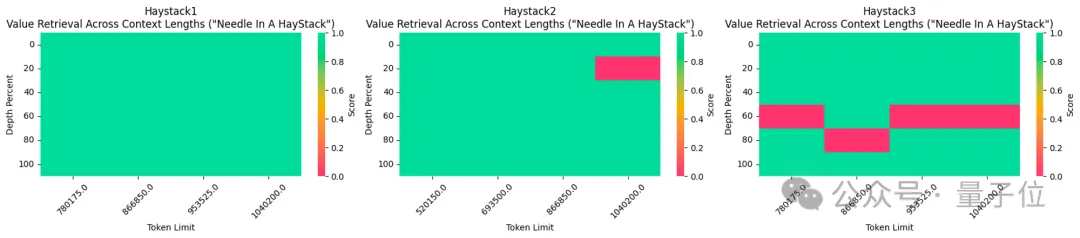

所使用的1048k上下文微调版本,刚刚在流行的大海捞针测试中达到全绿(100%准确率)的成绩。

不得不说,开源的进步速度是指数级的。

1048k上下文LoRA怎么炼成的

首先1048k上下文版Llama 3微调模型来自Gradient AI,一个企业AI解决方案初创公司。

而对应的LoRA来自开发者Eric Hartford,通过比较微调模型与原版的差异,提取出参数的变化。

他先制作了524k上下文版,随后又更新了1048k版本。

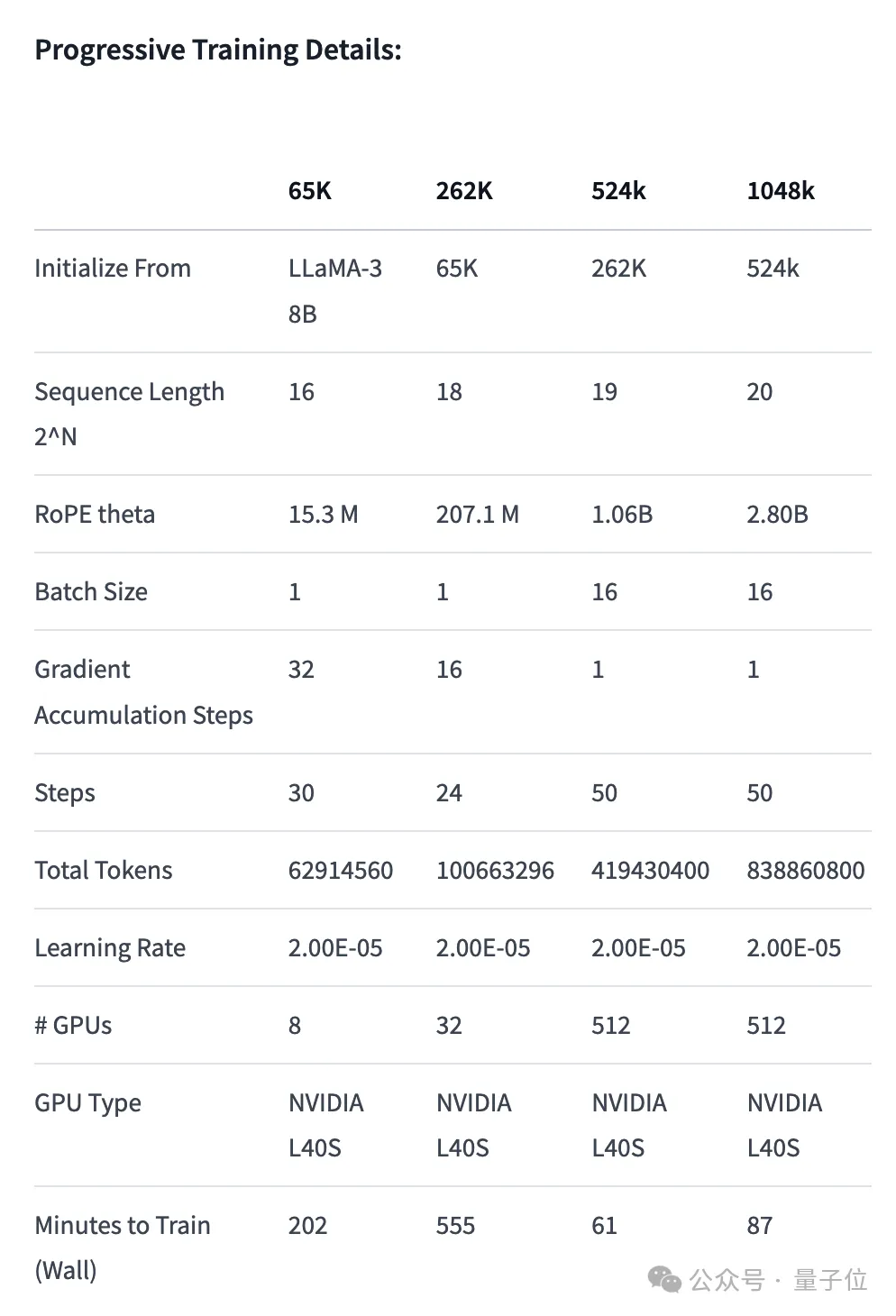

首先,Gradient团队先在原版Llama 3 70B Instruct的基础上继续训练,得到Llama-3-70B-Instruct-Gradient-1048k。

具体方法如下:

- 调整位置编码:用NTK-aware插值初始化RoPE theta的最佳调度,进行优化,防止扩展长度后丢失高频信息

- 渐进式训练:使用UC伯克利Pieter Abbeel团队提出的Blockwise RingAttention方法扩展模型的上下文长度

值得注意的是,团队通过自定义网络拓扑在Ring Attention之上分层并行化,更好地利用大型GPU集群来应对设备之间传递许多KV blocks带来的网络瓶颈。

最终使模型的训练速度提高了33倍。

长文本检索性能评估中,只在最难的版本中,当“针”藏在文本中间部分时容易出错。

有了扩展好上下文的微调模型之后,使用开源工具Mergekit比较微调模型和基础模型,提取参数的差异成为LoRA。

同样使用Mergekit,就可以把提取好的LoRA合并到其他同架构模型中了。

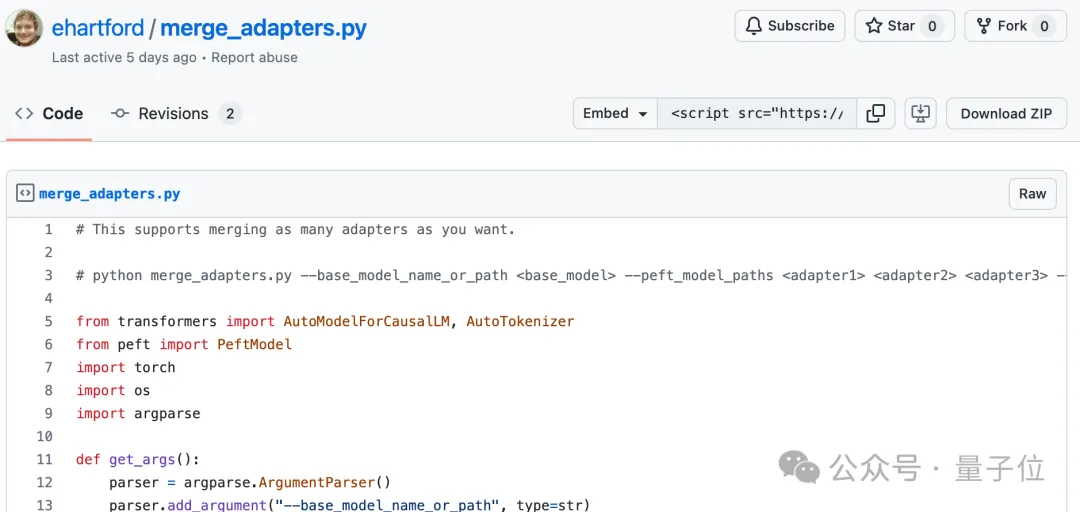

合并代码也由Eric Hartford开源在GitHub上,只有58行。

目前尚不清楚这种LoRA合并是否适用于在中文上微调的Llama 3。

不过可以看到,中文开发者社区已经关注到了这一进展。

524k版本LoRA:https://huggingface.co/cognitivecomputations/Llama-3-70B-Gradient-524k-adapter

1048k版本LoRA:https://huggingface.co/cognitivecomputations/Llama-3-70B-Gradient-1048k-adapter

合并代码:https://gist.github.com/ehartford/731e3f7079db234fa1b79a01e09859ac

以上是58行代码把Llama 3扩展到100万上下文,任何微调版都适用的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

git下载不动怎么办

Apr 17, 2025 pm 04:54 PM

git下载不动怎么办

Apr 17, 2025 pm 04:54 PM

解决 Git 下载速度慢时可采取以下步骤:检查网络连接,尝试切换连接方式。优化 Git 配置:增加 POST 缓冲区大小(git config --global http.postBuffer 524288000)、降低低速限制(git config --global http.lowSpeedLimit 1000)。使用 Git 代理(如 git-proxy 或 git-lfs-proxy)。尝试使用不同的 Git 客户端(如 Sourcetree 或 Github Desktop)。检查防火

git怎么下载项目到本地

Apr 17, 2025 pm 04:36 PM

git怎么下载项目到本地

Apr 17, 2025 pm 04:36 PM

要通过 Git 下载项目到本地,请按以下步骤操作:安装 Git。导航到项目目录。使用以下命令克隆远程存储库:git clone https://github.com/username/repository-name.git

git怎么删除仓库

Apr 17, 2025 pm 04:03 PM

git怎么删除仓库

Apr 17, 2025 pm 04:03 PM

要删除 Git 仓库,请执行以下步骤:确认要删除的仓库。本地删除仓库:使用 rm -rf 命令删除其文件夹。远程删除仓库:导航到仓库设置,找到“删除仓库”选项,确认操作。

git怎么更新代码

Apr 17, 2025 pm 04:45 PM

git怎么更新代码

Apr 17, 2025 pm 04:45 PM

更新 git 代码的步骤:检出代码:git clone https://github.com/username/repo.git获取最新更改:git fetch合并更改:git merge origin/master推送更改(可选):git push origin master

如何解决PHP项目中的高效搜索问题?Typesense助你实现!

Apr 17, 2025 pm 08:15 PM

如何解决PHP项目中的高效搜索问题?Typesense助你实现!

Apr 17, 2025 pm 08:15 PM

在开发一个电商网站时,我遇到了一个棘手的问题:如何在大量商品数据中实现高效的搜索功能?传统的数据库搜索效率低下,用户体验不佳。经过一番研究,我发现了Typesense这个搜索引擎,并通过其官方PHP客户端typesense/typesense-php解决了这个问题,大大提升了搜索性能。

git commit怎么用

Apr 17, 2025 pm 03:57 PM

git commit怎么用

Apr 17, 2025 pm 03:57 PM

Git Commit 是一种命令,将文件变更记录到 Git 存储库中,以保存项目当前状态的快照。使用方法如下:添加变更到暂存区域编写简洁且信息丰富的提交消息保存并退出提交消息以完成提交可选:为提交添加签名使用 git log 查看提交内容

git怎么提交空文件夹

Apr 17, 2025 pm 04:09 PM

git怎么提交空文件夹

Apr 17, 2025 pm 04:09 PM

在 Git 中提交空文件夹,只需遵循以下步骤:1. 创建空文件夹;2. 将文件夹添加到暂存区;3. 提交更改,并输入提交消息;4. (可选)将更改推送到远程存储库。注意:空文件夹的名称不能以 . 开头,如果文件夹已存在,需要使用 git add --force 添加。

git代码冲突怎么处理

Apr 17, 2025 pm 02:51 PM

git代码冲突怎么处理

Apr 17, 2025 pm 02:51 PM

代码冲突是指当多个开发者修改同一段代码导致 Git 合并时无法自动选择更改而出现的冲突。解决步骤包括:打开有冲突的文件,找出冲突代码。手动合并代码,将要保留的更改复制到冲突标记内。删除冲突标记。保存并提交更改。